La revue Sciences express a publié le 15 janvier 2015, une prétendue étude scientifique intitulée : "Planetary Boundaries: Guiding human development on a changing planet". Dix neuf auteurs y analysent une série de neuf critères justifiant, selon eux, des entraves à l’activité humaine sous forme de "limites planétaires".

La revue Sciences express a publié le 15 janvier 2015, une prétendue étude scientifique intitulée : "Planetary Boundaries: Guiding human development on a changing planet". Dix neuf auteurs y analysent une série de neuf critères justifiant, selon eux, des entraves à l’activité humaine sous forme de "limites planétaires".

Johan Rockström, un des co-auteurs, a longuement présenté les conclusions au « forum économique mondial » de Davos, les 21-24 janvier 2015. Nul doute que les principaux dirigeants de la planète seront convaincus de l’urgence de mesures de décroissance puisque, selon un des auteurs, "la civilisation a dépassé quatre des neuf soi-disant limites planétaires".

Cette étude vient à l'appui de l'ONU qui doit adopter les "Objectifs du développement durable" pour les années 2015-2030 et qui a associé "limites planétaires" et population. Elle en a fait son Groupe Thématique n°1 intitulé "Macroéconomie, dynamique des populations, et limites planétaires". Cette association est un aveu évident du malthusianisme qui règne au sein des instances internationales sous couvert de développement durable.

Les2ailes.com proposent une série d’articles, de (1) à (9), reprenant chacune de ces limites pour montrer leur caractère pseudo-scientifique. Un dixième article (10) tirera une conclusion sur l’absurdité même de ce concept de « limites planétaires ».

Ce premier article concerne le changement climatique, considéré comme la première limite de l’étude « Planetary Boundaries » (PB). Qu’en est-il ?

Commentaires "les2ailes.com"

1- Le contenu général de l’étude "Planetary boundaries"

L’étude utilise le concept de « limites planétaires » définies comme « un espace de fonctionnement sûr pour l'humanité basée sur les processus biophysiques intrinsèques qui régulent la stabilité du système terrestre ».

Dans cette étude, les auteurs prétendent « réviser et actualiser le cadre des limites de la planète, avec un accent mis sur les fondements de la science biophysique fondement, basés sur les observations ciblées des communautés de recherche d'experts ainsi que les avancées scientifiques plus générales réalisées au cours des 5 dernières années. Plusieurs des limites ont maintenant une approche à deux niveaux, ce qui reflète l'importance des interactions trans-sectorielles et de l'hétérogénéité des processus au niveau régional que sous-tendent les limites. Deux limites fondamentales - le changement climatique et l’intégrité de la biosphère - ont été identifiées, chacun d’eux ayant un potentiel sur la manière de gérer le « Système-Terre » vers un nouvel état à ne pas transgresser substantiellement et continuellement ».

2- Les critères retenus par l’étude "Planetary boundaries"

L’étude retient 9 critères:

- Le Changement climatique, fixant une limite d’émission de CO² dans l’air

- L’intégrité de la biosphère, fixant une limite de disparition d’espèces

- La réparation du « trou d’ozone » est considéré comme un fait acquit du fait de limites antérieures, le zéro CFC.

- L’acidification des océans serait évitée en appliquant la limite de CO2 retenue pour le climat

- Les flux de phosphore et d’azote en fixant des limites d’usages d’engrais

- Les changements de macro-écosystèmes en limitant les déforestations

- Les usages d’eaux douces en limitant les usages aux « exigences de flux écologiques des rivières »

- Les nouvelles entités chimiques dont l’analyse n’a pas encore permis de fixer une valeur limite

- Les aérosols et particules fines atmosphériques dont l’analyse n’a pas encore permis de fixer une valeur limite

Ils sont représentés et mesurés sous forme d’un graphique. Les couleurs sont sensées représentées la gravité des situations par rapport à chacune de ces limites.

Nous tirerons des conclusions dans un dixième article, mais, analysons le premier critère : le changement climatique :

3- Ce que dit l’étude "Planetary boundaries" sur le climat : limiter la concentration de CO² 450 ppm dans l’air

L’étude retient comme seuil historique celui du niveau de l’époque préindustrielle de 350 ppm de concentration de CO2 et celui du forçage radiatif de 1,0 W/m². Elle considère que « les preuves se sont accumulées pour suggérer que les zones d'incertitude pour la variable de contrôle de CO2 devrait être réduit de 350 à 550 ppm à 350-450 ppm de CO2 [1], tout en conservant les zones actuelles d'incertitude pour le forçage radiatif de + 1,0-1,5 W/m2 par rapport à l'ère préindustrielle. Les valeurs actuelles des variables de contrôle sont 397 ppm de CO2 (concentration moyenne annuelle pour 2013)[2] et 2,3 W m-2 (1.1 à 3.3 W/m²) en 2011 par rapport à 1750 [3]. Les changements observés dans le climat aux niveaux actuels des variables de contrôle confirment le choix initial des valeurs limites et le rétrécissement des zones d'incertitude pour le CO2. Par exemple, il y a déjà eu une augmentation de l'intensité, la fréquence et la durée des vagues de chaleur à l'échelle mondiale [4]; le nombre d'événements de fortes précipitations dans de nombreuses régions du monde est en augmentation [5]; des changements dans la circulation atmosphérique ont augmenté à la sécheresse dans certaines régions du monde [6]; et le taux combiné de la perte de masse du Groenland et des inlandsis de l'Antarctique est en augmentation [7] ».

L’étude ne fait que reprendre les allégations du Giec selon lequel la cause des variations climatiques récentes est humaine.

Or la science climatique est balbutiante. deux théories s’opposent : celle du Giec que nous qualifieront de « géo-carbonique » et celle qui prétend que les variations d’activité solaire sont responsables de ces variations. Nous qualifieront cette théorie d’ « hélio-centriste ».

- Malheureusement, pour les « hélio-centristes » (§ 3.1),

a) il ne suffit pas de faire une simple critique du Giec

b) il ne suffit pas de mettre en évidence des corrélations qui ne sont pas des preuves de relations de cause à effet

- Et pour les « géo-carbonistes » (§ 3.2)

a) il ne suffit pas de réfuter la thèse héliocentrique en disant qu’on ne pourrait pas en expliquer les mécanismes.

b) Il ne suffit pas de déclarer qu’on est des milliers de chercheurs, pour faire la preuve d’une cause anthropique. Entre l’avis d’une multiplicité de disciplines (climatologues, informaticiens, astronomes, physiciens, chimistes, paléo-climatologues, agronomes, pédologues, entomologues, etc...), il faut une science apportant la cohérence des preuves. Or la « détection attribution » mise au point par le Giec y échoue.

Or, depuis 2014, une approche par identification des systèmes dynamiques donne des résultats tout à fait opposés à ceux du Giec (§ 3.3).

Voyons ces trois points successivement

3.1- La position des « hélio-centristes »

A- Une critique du Giec, souvent fondée

Les hélio-centristes reprochent au GIEC (IPCC), d’avoir reçu, dès sa création, mission de « comprendre les fondements scientifiques des risques liés au changement climatique d'origine humaine » qui serait à l’origine de la période chaude actuelle. De fait, les travaux qu’il a expertisés s’accordent sur un réchauffement catastrophique avant la fin du siècle si rien n’est fait pour limiter les émissions anthropiques de CO2.

La principale objection faite au Giec est de ne pas avoir prévu, ni expliqué, le plafonnement actuel du réchauffement.

En effet, les observations montrent un fort ralentissement depuis une quinzaine d’année. Le GIEC reconnait, avec quelque réticence, ne pas l’avoir prévu : « La plupart des simulations de la période historique ne reproduisent pas la réduction observée dans la tendance au réchauffement de surface moyen sur les derniers 10 ou 15 ans » (IPCC -WG1-AR5 - Chap 9 p. 743).

Comment expliquer l’échec des modèles de calcul élaborés par le GIEC à expliquer cette réalité nouvelle ?

Le GIEC qualifie ces modèles de calcul de « modèles de connaissance ». Ils sont dérivés des outils utilisés par les météorologues, enrichis par la modélisation physique de multiples phénomènes additionnels. Si la « connaissance » de certains de ces phénomènes est parfois robuste, elle est malheureusement encore balbutiante dans d’autres domaines. Un exemple typique est la modélisation de la genèse des nuages, d’importance majeure sur le climat. Le GIEC reconnait que « les modèles climatiques incluent désormais d’avantage de processus décrivant les nuages et les aérosols, et leurs interactions, ... mais le degré de confiance dans la représentation et la quantification de ces processus dans les modèles reste faible » (Final SPM -chap. D1- p. 9 -line 23). Cette extrême complexité et l’impossibilité d’expérimentation à ce sujet incitent évidemment à une très grande prudence sur la fiabilité de modélisation de tels mécanismes et de leurs interactions mutuelles.

Au fil de ses rapports, le GIEC a cherché également :

- à globaliser le système climatique et le cycle du carbone. Il consacre un chapitre entier de son dernier rapport à étudier comment « le climat répond au CO2 et... comment le cycle du carbone océanique répond au changement climatique », tout en reconnaissant que « les réponses sont très incertaines » (chapitre 6.4.2.1, page 7).

- à intégrer des phénomènes comme celui des courants océaniques tels que El Nino. Le GIEC lui attribue un rôle en disant : « le renversement de tendance du réchauffement depuis 1998 s’explique par la combinaison d’une basse activité solaire dans les 10 années récentes et par l’exceptionnel évènement qui est arrivé sur El Nino » (Chap. 10.3.1.1.3 p. 21).

Ce sont là des défauts de conception intrinsèque aux « modèles de connaissance » (GIEC) qui n’isolent pas suffisamment :

- ni les systèmes complexes entre eux, par exemple, le système climatique, qui a une certaine logique propre, et celui du cycle du carbone, qui en a une autre.

- ni les boucles de réactions entre elles :

- Les boucles de rétroactions externes. Ainsi, les émissions de CO2 constituent une donnée d’entrée du cycle du carbone et la teneur en CO2 dans l’air n’est qu’une donnée de sortie de ce cycle, tout en étant une donnée d’entrée du système climatique.

- Les boucles d’interactions internes. Ainsi, le phénomène El Niño est à la fois une conséquence de variations spatiales de températures selon les régions et une cause de variations temporelles de températures. Or le GIEC est amené à considérer El Niño comme une entrée du système climatique et à lui affecter une contribution (Fig. 10.5, page 119).

Toute cette complexification a conduit le GIEC à reconnaitre lui-même ses « erreurs de forçage et une surestimation, par certains modèles, de la réponse à l’augmentation de forçage par les gaz à effet de serre ». (IPCC -WG1-AR5 - Chap 9 p. 743).

Le GIEC veut expliquer le « hiatus » climatique observé depuis 2000 par une accumulation de chaleur océanique au détriment de l’atmosphère. L’idée est plausible et séduisante mais elle vaut dans les deux sens : un dégagement de chaleur océanique n’aurait-il pas puissamment contribué au réchauffement à la fin du siècle dernier ?

En effet, aucune modélisation à partir des comportements océaniques n’est possible, faute :

- de pouvoir l’isoler du reste de la mécanique climatique alors qu’il en est un effet

- d’identifier un état initial des températures océaniques

- d’isoler des causes indépendantes des effets affectant les équilibres océaniques. Qu’est ce qui permettrait de dire ou d’infirmer qu’un tel réchauffement viendrait :

- d’un réchauffement de la couche séparant l’atmosphère de l’océan ou d’un refroidissement des couches profondes, qui même faible et compte tenu de leurs masses importantes entre 2 et 4.000 m, pourrait contribuer au réchauffement des 700 m supérieurs ?

- d’un réchauffement de l’atmosphère par une cause d’origine humaine ou par celle d’une activité solaire élevée ?

Rien ne permet de dire ni d’infirmer quoique ce soit, faute :

- de disposer d’événements océaniques sur des périodes largement plus longues que les quelques décennies de mesures en notre possession,

- de disposer de degrés de confiance sur quelques 0,015°C/an. Le GIEC évoque une « augmentation observée du contenu calorifique océanique supérieur équivalente à un flux de chaleur net moyen dans l'océan de 0.5 W/m²». (Source : AR5- Executive summary, Chap. 3, lignes 8 et 48). Il ne peut se prévaloir d’une cohérence avec le bilan radiatif à la surface de la terre ou en haute atmosphère, qui ne sont chiffrés qu’à 0.6 W/m² mais avec des approximations variant autour de ± 2 à 7 W/m² selon les mesures.

Le « hiatus » climatique ne peut donc s’expliquer à partir des comportements océaniques. Tout prétendu raffinement des modèles est source de nouvelles erreurs et ne permet en aucun cas d’annoncer « une prochaine ré-accélération du réchauffement global » (source : CNRS)

Les raisons sont à chercher dans une activité solaire qui est dans une phase de ralentissement.

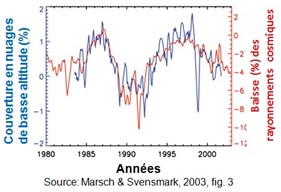

B- Une allégation des hélio-centristes sans véritable preuve

Les partisans d’une thèse plus solariste, n’apportent pas de preuves vraiment définitives. Le climatologue Richard Lindzen, le physicien Freeman Dyson ou les chimistes Ivar Giaever et Kary Mullis (deux Prix Nobel), pour ne citer qu’eux, se contentent souvent, outre la mise en évidence de la faiblesse des modèles mathématiques, de s’appuyer sur la superposition des courbes de l’activité solaire avec celles des évolutions de températures. Nous reprenons par exemple celle reprise dans le graphe ci-contre.  Mais il ne s’agit là que d’une corrélation : le coefficient de corrélation entre les deux courbes est de r²= 0,87. C’est un résultat excellent, car il est proche de 1. Mais cette corrélation appelle les commentaires suivants:

Mais il ne s’agit là que d’une corrélation : le coefficient de corrélation entre les deux courbes est de r²= 0,87. C’est un résultat excellent, car il est proche de 1. Mais cette corrélation appelle les commentaires suivants:

Il est exact qu’il ne faut pas toujours croire qu’un coefficient de corrélation proche de 1 induise forcément une relation de causalité entre deux phénomènes mesurés. En réalité, ils peuvent être corrélés à un même phénomène-source : une troisième variable non mesurée, et dont dépendraient les deux autres. Certes, dans le cas présent, on ne voit pas quelle pourrait être la troisième variable pouvant expliquer à la fois les variations d’irradiance solaire et celles des températures. La présomption est donc forte, mais, faudrait-il encore apporter la preuve d’un mécanisme explicatif.

3.2- La position des « géo-carbonistes »

A- Une cause solaire que le Giec ne parvient pas à expliquer

Le Giec explique, à juste titre, que la puissance radiative du soleil, même en période d’activité intense, ne suffirait pas à expliquer la hausse des températures.

Mais, faute de preuve d’un autre mécanisme, le Giec s’en tient à l’approche anthropique.

Pourtant, un important projet dénommé CLOUD ( "Cosmic Leaving Outdoor Droplets") a mené une expérimentation sur les rayons cosmiques produisant des gouttelettes extérieures.  Mené par une quinzaine d’instituts de plus de huit pays. Il confirme que les rayons cosmiques, se propageant en permanence dans la galaxie, émis par l'onde de choc due à l'explosion de supernovas, pourraient avoir un effet sur la constitution des nuages de haute altitude de la terre. Andreas Petzold, Henrik Svensmark, Eigil Friis-Christensen et d’autres émettent l’hypothèse selon laquelle les rayons galactiques cosmiques sont capables de moduler les aérosols dans les couches plus basses de l’atmosphère et d’y moduler la production de nuages.

Mené par une quinzaine d’instituts de plus de huit pays. Il confirme que les rayons cosmiques, se propageant en permanence dans la galaxie, émis par l'onde de choc due à l'explosion de supernovas, pourraient avoir un effet sur la constitution des nuages de haute altitude de la terre. Andreas Petzold, Henrik Svensmark, Eigil Friis-Christensen et d’autres émettent l’hypothèse selon laquelle les rayons galactiques cosmiques sont capables de moduler les aérosols dans les couches plus basses de l’atmosphère et d’y moduler la production de nuages.  Or ce sont les nuages de basse altitude qui ont un effet refroidissant sur la terre. Ces chercheurs expliquent que lorsque l’activité magnétique très puissante du soleil est à son maximum, on constate une pénétration inférieure des rayons cosmiques et des particules provenant de l’espace galactique. Ainsi, quand l’activité solaire serait importante, le rayonnement cosmique serait moins intense, la production de nuages de basses altitudes serait moindre et la terre se réchaufferait.

Or ce sont les nuages de basse altitude qui ont un effet refroidissant sur la terre. Ces chercheurs expliquent que lorsque l’activité magnétique très puissante du soleil est à son maximum, on constate une pénétration inférieure des rayons cosmiques et des particules provenant de l’espace galactique. Ainsi, quand l’activité solaire serait importante, le rayonnement cosmique serait moins intense, la production de nuages de basses altitudes serait moindre et la terre se réchaufferait.

B- La « détection&attribution » du Giec

Les contributeurs aux rapports du GIEC seraient-ils des milliers de scientifiques, en thermodynamique, physique, océanographie, glaciologie, biologie, chimie, ou en sciences informatiques, une méthodologie robuste pour juger l'adéquation entre la théorie et les observations n’en est que plus nécessaire.

Sur ce point, le GIEC s’appuie sur une théorie très spécifique mentionnée comme la « détection et l'attribution », qui est exclusivement consacrée à la science climatique. Or seul un nombre très restreint de personnes revendique cette technique de validation non reconnue par les autres communautés scientifiques : Gabriele Hegerl, citée plus de 20 fois parmi les références bibliographiques du chapitre 10 (AR5), est co-auteur des recommandations aux rédacteurs du GIEC: « Good practice guidance paper on detection and attribution related to anthropogenic climate change » (2009). Le titre de cette recommandation induit que l’objectif est de valider « la cause anthropogénique du changement climatique » ! Pourquoi le GIEC n'utilise-t-il pas les méthodes universellement reconnues, comme l'identification des systèmes ? Cet isolement conduit à des lacunes graves consistant à

- se limiter à des données portant sur les seules 150 années récentes (IPCC -WG1-AR5 - Chap 10 - Fig. 10.1- p. 107). L’imprécision des reconstructions antérieures ne peut justifier d’occulter 1000 ans d’histoire.

- et à inverser des causalités : l’effet « El Niño South Oscillation » est traité comme une cause.

Pourtant, il y a d'autres techniques pertinentes et reconnues, en particulier la théorie d'identification des systèmes.

3.3- Une méthode alternative d’analyse : l’identification des systèmes dynamiques complexes

Face à ces difficultés, le Professeur Philippe de Larminat a développé une méthode d’analyse alternative, publiée en 2014 dans « Changement climatique- Identification et projections », chez Iste et Wiley, maison d’édition scientifique prestigieuse dans le monde anglo-saxon. Il se fonde sur les techniques dites d’identification des systèmes, dont il est un expert reconnu. Ces techniques ont, à l’origine, été développées pour l’automatisation du contrôle de systèmes technologiques, et elles consistent à déterminer le modèle mathématique des systèmes, si complexes soient-ils, à partir de leur comportement global. Elles sont surtout enseignées dans les écoles d’ingénieurs et sont moins connues dans les milieux universitaires, plus traditionnellement attachés à la recherche de mécanismes physiques fondamentaux. Appliqués à la science climatique, ces modèles ne se limitent pas à la détermination mathématique de relations causales abstraites. Les modèles incorporent également les fondamentaux de la physique et de la thermodynamique, en particulier les phénomènes d’accumulation de chaleur dans les inerties thermiques océaniques. Ils constituent des outils d’investigation très puissants, permettant d’accéder de manière macroscopique à de précieuses informations quantitatives sur les mécanismes sous-jacents. Ils sont ainsi à parité avec les modèles « de connaissance », voire beaucoup performants que ces derniers lorsqu’il s’agit de systèmes très complexes… ce qui est très clairement le cas ici. LE GIEC le reconnait lui-même : « la moindre complexité ajoutée, bien que destinée à améliorer certains aspects du climat simulé, introduit aussi de nouvelles sources d’erreur possible » (FAQ 9.1 § 9, p. 76). !

A- La procédure d’identification se déroule en quatre temps :

- Définition de la structure du modèle.

Dans le cas de l’étude climatique, elle s’articule autour d’un modèle « à bilan énergétique » (EBM : Energy Balance Model), loi simple et robuste qui assure la cohérence de la conservation d’énergie dans toutes les relations entre les divers paramètres. Dans la « structure », est fait le choix fondamental des grandeurs d’entrée et de sortie du modèle. Pour les entrées, les signaux retenus sont la teneur en CO2 atmosphérique, l’activité solaire, et l’activité volcanique. L’unique signal de sortie retenu est l’historique de la température globale sur une période donnée.

- « L’observation » du comportement du système.

La période considérée est celle où l’on dispose de mesures suffisantes, directes ou indirectes, sur tous les signaux énoncés ci-dessus. En l’occurrence, il s’agit d’une période de l’an 843 à nos jours, durée nécessaires pour bénéficier d’un nombre suffisants d’évènements significatifs ; les historiques utilisés sont très largement issus des rapports du GIEC.

- L’identification des paramètres du système.

Le modèle est issu du traitement mathématique des données. Du choix d’un modèle à bilan énergétique, il résulte que les résultats du calcul donnent directement les coefficients dit de « sensibilité à l’équilibre » relatifs aux trois entrées (CO2, activités solaire et volcanique), qui se trouvent être également des résultats essentiels des évaluations du GIEC. La différence fondamentale est qu’un modèle « de connaissance » conduit à ces coefficients à partir de modèles physiques d’une extrême complexité, alors que l’identification donne accès aux mêmes élément uniquement à partir de l’observation des données historiques, et ceci sans requérir de connaissances physiques détaillées des mécanismes sous-jacents.

Outre l’évaluation des sensibilités, la méthode permet également d’effectuer de façon rigoureuse le calcul de la probabilité qu’a un paramètre de se trouver dans un intervalle donné. Ceci par opposition aux évaluations de « confiance » ou de « probabilité » du GIEC, qui reconnait lui-même que « la probabilité n'est pas issue d'un calcul statistique. Elle exprime ce qu’on entend par "très probablement". La probabilité donnée indique que les auteurs estiment que, sur 100 affirmations de ce type, plus de 95% sont vraies. C'est une évaluation subjective basée sur un faisceau d'indices » (Mail du GIEC adressé le 13 déc. 2014 à un groupe de travail français).

Notons également que la méthode d’identification permet de quantifier précisément ce que le GIEC appelle la « variabilité naturelle interne du climat ». En identification, elle se traduit par l’écart résiduel irréductible qui apparaît entre les résultats du modèle identifié et la réalité, du fait des phénomènes aléatoires ou non pris en compte dans le modèle.

Notons enfin, ce qui va sans dire, que le modèle d’identification est intrinsèquement un modèle dynamique, c’est-à-dire qu’il prend, de lui-même, en compte le délai entre toute variation d’une donnée d’entrée, et son effet différé et pondéré dans le temps, du fait notamment des inerties thermiques mises en jeu. Le modèle évalue de lui-même les effets de cette inertie par le biais de constantes de temps, là aussi sans qu’il soit besoin de « connaissance » à priori des phénomènes en jeu.

Dans l’ouvrage de Philippe de Larminat, la méthode, telle que très sommairement synthétisée ci-dessus, est appliquée à seize combinaisons de données : quatre chroniques de reconstitutions températures paléo-climatiques, et quatre reconstitutions d’activité solaire. Globalement, on peut en tirer deux types de conclusion. La première est que la période de réchauffement qui conduit à la période chaude actuelle est due, pour l’essentiel, à la conjonction des effets de l’activité solaire et de la variabilité interne naturelle du climat. La seconde est que l’éventuelle contribution de l’activité humaine ne se distingue pas suffisamment des effets ci-dessus pour qu’on puisse affirmer qu’elle soit significative avec le haut degré de certitude que lui attribue le GIEC.

- L’évaluation à posteriori de la validité du modèle.

Les calculs d’incertitude et les tests d’hypothèse apportent toutes les validations académiques requises, mais restent assez abstraits. Une preuve tangible résulte de l’adéquation entre ses résultats et les observationset sur sa capacité prédictive : On se replace dans la situation de l’an 2000, quand personne n’aurait misé sur un possible ralentissement du réchauffement. Or, les simulations effectuées à l’aveugle, sans y incorporer la moindre information de température postérieure à l’an 2000, prédisent avec une exactitude surprenante le palier de température que nous connaissons encore actuellement. La méthode exploite les techniques classiques dite « de reconstruction d’état » (filtrage de Kalman), où l’« état » en question correspond à des combinaisons de quantités de chaleur accumulées dans les inerties océaniques.

B- Des conclusions qui s’opposent aux scénarios-catastrophe du GIEC

En s’appuyant sur ses résultats d’identification, Philippe de Larminat pose dans son ouvrage les conclusions suivantes : "Non seulement il n’est pas possible d’estimer avec quelque précision la sensibilité au CO2, mais on ne peut même pas détecter avec certitude l’existence d’une relation de cause à effet. … L’hypothèse d’un impact insignifiant de l’ensemble des gaz à effet de serre et de l’activité humaine en général ne peut pas être écartée. … On doit considérer comme un fait établi que l’activité solaire, en tant que variable explicative causale, constitue effectivement l’explication première du "changement climatique". … Dans le scénario envisageable d’un retour aux faibles activités solaires des années 1700 ou 1800, les modèles identifiés font craindre, au contraire, une baisse des températures qui pourrait annuler la hausse du siècle dernier. Cette éventualité est ni plus ni moins probable que la reprise alarmante que nous promet le GIEC".

Le Professeur Philippe de Larminat est un pionnier dans l’application des techniques de l’identification au processus climatique terrestre. Nul doute qu’il sera suivi, avec toute la fécondité qui sortira de traitements croisés par d’autres chercheurs.

4- L’étude « PB » sur le climat fixe une limite pénalisant les pays pauvres

Cette conclusion n’a rien d’original ? il s’agit purement et simplement des assertions du Giec qui devraient, pourtant, inciter les observateurs à une extrême prudence. Rien n’indique que la période chaude contemporaine corresponde à un changement climatique d’origine humaine, ni qu’elle puisse devenir catastrophique. Quand le GIEC assure le contraire avec les accents d’une certitude qu’il qualifie de « jugement d’expert » (à 95%), ce n’est pas vrai et c’est grave. Si l’avenir lui donne tort au Giec, comme tout le laisse prévoir, on va vers une perte de confiance généralisée dans la Science, dans les médias qui colportent le catastrophisme.

Quant à l’application de cette mesure, elle conduira les pays les plus pauvres à s’appauvrirent encore plus.

[1] IPCC (Intergovernmental Panel on Climate Change), Climate Change 2013: The Physical Science Basis. Summary for Policymakers. L. Alexander et al. (IPCC Secretariat, Geneva, Switzerland, 2013). doi:10.1017/CBO9781107415324

[2] NOAA (National Oceanic and Atmospheric Administration), NOAA-ESRL Annual CO2 Data, accessed at: http://co2now.org/Current-CO2/CO2-Now/annual-co2.html (2014).

[3] IPCC (Intergovernmental Panel on Climate Change), Climate Change 2013: The Physical Science Basis. Summary for Policymakers. L. Alexander et al. (IPCC Secretariat, Geneva, Switzerland, 2013). doi:10.1017/CBO9781107415324

[4] S. E. Perkins, L. V. Alexander, J. Nairn, Increasing frequency, intensity and duration of obersved global heat waves and warm spells. Geophys. Res. Lett. 39, n/a (2012). 10.1175/2008EI260.1 doi:10.1029/2012GL053361

[5] IPCC (Intergovernmental Panel on Climate Change), Managing the risks of extreme events and disasters to advance climate change adaptation. A special report of Working Groups I and II of the IPCC. C.B. Field et al. (Eds.) (Cambridge University Press, Cambridge, UK (2012). doi: 10.1017/CBO9781139177245)

[6] IPCC (Intergovernmental Panel on Climate Change), Managing the risks of extreme events and disasters to advance climate change adaptation. A special report of Working Groups I and II of the IPCC. C.B. Field et al. (Eds.) (Cambridge University Press, Cambridge, UK (2012). doi: 10.1017/CBO9781139177245)

[7] A. Shepherd, E. R. Ivins, G. A, V. R. Barletta, M. J. Bentley, S. Bettadpur, K. H. Briggs, D. H. Bromwich, R. Forsberg, N. Galin, M. Horwath, S. Jacobs, I. Joughin, M. A. King, J. T. Lenaerts, J. Li, S. R. Ligtenberg, A. Luckman, S. B. Luthcke, M. McMillan, R. Meister, G. Milne, J. Mouginot, A. Muir, J. P. Nicolas, J. Paden, A. J. Payne, H. Pritchard, E. Rignot, H. Rott, L. S. Sørensen, T. A. Scambos, B. Scheuchl, E. J. Schrama, B. Smith, A. V. Sundal, J. H. van Angelen, W. J. van de Berg, M. R. van den Broeke, D. G. Vaughan, I. Velicogna, J. Wahr, P. L. Whitehouse, D. J. Wingham, D. Yi, D. Young, H. J. Zwally, A reconciled estimate of ice-sheet mass balance. Science 338, 1183–1189 (2012). 10.1126/science.1228102 Medline doi:10.1126/science.1228102