"Je crois que le suprême service que je puisse rendre à ces derniers [les « honnêtes gens »] serait précisément de les mettre en garde contre les imbéciles ou les canailles qui exploitent aujourd’hui, avec cynisme, leur grande peur, la Grande Peur des Bien-Pensants" (Georges Bernanos [1])

"Je crois que le suprême service que je puisse rendre à ces derniers [les « honnêtes gens »] serait précisément de les mettre en garde contre les imbéciles ou les canailles qui exploitent aujourd’hui, avec cynisme, leur grande peur, la Grande Peur des Bien-Pensants" (Georges Bernanos [1])

La lacune la plus grave des modèles du Giec est qu’ils se limitent à des calculs et des observations limités aux 150 dernières années. Comment pourrait être légitime des calculs qui ne cherchent pas à expliquer les causes de la période chaude médiévale, celle qui a valu aux occupants du Groenland de l’époque d’appeler cette zone « terre verte » ?

Inutile de remonter aux cycles des 40 ou 100.000 dernières années. Nos politiques ne cherchent pas à faire des prévisions à si long terme. En revanche, des modélisateurs s’attachent à quantifier les causes sur quelques centaines d’années seulement. Ils arrivent à la conclusion qu’« avec un niveau de probabilité de 90%, on ne peut pas rejeter l'hypothèse d'une contribution anthropogénique nulle ou insignifiante », et que « l'hypothèse d'une faible contribution de l'activité solaire doit être rejetée avec un niveau de probabilité supérieur à 90% »[1bis].

Le présent article s’appuie sur ces modélisateurs en imaginant, au mieux, que 40% de la contribution au réchauffement soit d’origine humaine, ce qui est considéré comme un grand maximum. Quelle serait la conséquence sur les 50 prochaines années ?

Analyse: "les2ailes.com"

1- Période chaude contemporaine : contribution d’origine naturelle ou humaine?

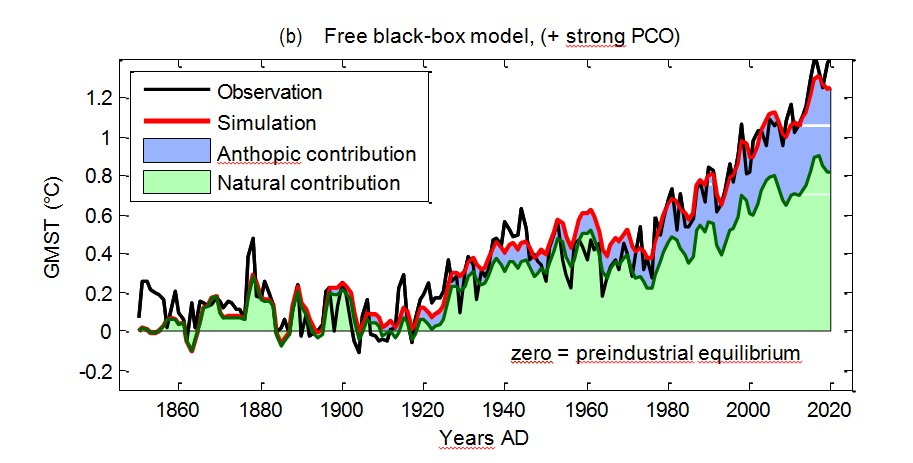

Une première thèse, celle du Giec, considère que la contribution naturelle ne serait que de 1 à 5% (Pavé a ci-contre en vert).

Une première thèse, celle du Giec, considère que la contribution naturelle ne serait que de 1 à 5% (Pavé a ci-contre en vert).

D’autres modélisations estiment que la contribution au réchauffement ne serait d’origine humaine qu’à hauteur d’un maximum de 40% ((pavé b ci-dessous, en bleu). Dès lors, la contribution d’origine naturelle pourrait dépasser 60% (en vert).

Les contributions naturelles (vertes) et les contributions anthropiques (bleues) sont donc en contradiction complètes selon les modélisations. Cette incompatibilité est au coeur du débat.

2- Une activité solaire historiquement très haute ! Et s’il advenait qu’elle se réduise ?

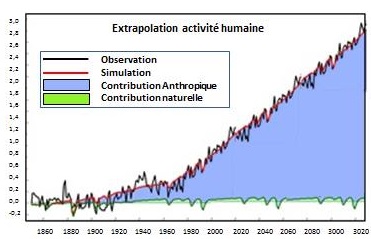

Avec la quantification menée par le Giec, il est facile de comprendre que les prévisions, sur les 80 prochaines années, ont une tendance catastrophiste, pouvant aller jusqu’à + 3°C en l’an 3000 (ci-contre)!

Avec la quantification menée par le Giec, il est facile de comprendre que les prévisions, sur les 80 prochaines années, ont une tendance catastrophiste, pouvant aller jusqu’à + 3°C en l’an 3000 (ci-contre)!

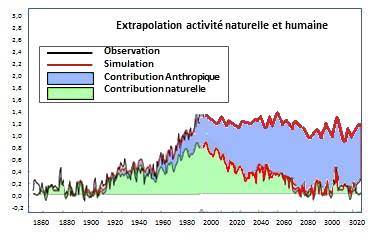

Si, au contraire, on retient le fait que la contribution

naturelle est actuellement à un maximum, la probabilité d’une baisse est très élevée. Cette hypothèse d'une baisse prochaine de l'activité solaire est d'autant plus plausible qu'on connait bien les cycles solaires dit de Suess (ci contre). Pourquoi ne pas retenir l’hypothèse que l'activité solaire baisse de manière symétrique à celle constatée sur les 150 années précédentes[2]. On peut même faire l’hypothèse que la contribution anthropique continue à augmenter, en même temps que se développeront de nouvelles technologies à haute densité énergétique.

Pourquoi ne pas retenir l’hypothèse que l'activité solaire baisse de manière symétrique à celle constatée sur les 150 années précédentes[2]. On peut même faire l’hypothèse que la contribution anthropique continue à augmenter, en même temps que se développeront de nouvelles technologies à haute densité énergétique.

Avec ces hypothèses, raisonnables et plausibles, la température arrêterait d’augmenter dans le futur.

3- Application du principe de précaution

Le texte qui a désormais valeur constitutionnelle dit: « Lorsque la réalisation d'un dommage, bien qu'incertaine en l'état des connaissances scientifiques, pourrait affecter de manière grave et irréversible l'environnement, les autorités publiques veillent …à l'adoption de mesures provisoires et proportionnées afin de parer à la réalisation du dommage ».

Trois mots clefs méritent réflexion :

a) En cas d’incertitude en l'état des connaissances scientifiques…

Imaginons qu’il n’y ait pas de certitude, malgré les projections alarmistes annoncées par le Giec et relayées par les médias.

b) ... et si la réalisation d'un dommage peut affecter de manière grave l’environnement,…

L’opinion publique pense aux évènements extrêmes qui pourraient advenir. Rappelons toutefois que le Giec lui-même dit que : « les modèles climatiques sont incapables de prévoir les événements extrêmes: manque de résolution spatiale et temporelle ». Il ajoute qu’avec un « degré de confiance élevé, les inondations des cinq derniers siècles ont été supérieures à celles observées depuis 1900 ». Il ajoute également qu’il n’ y a « pas de tendance significative dans la fréquence cyclones ».

c) ... les autorités publiques veillent à l'adoption de mesures provisoires et proportionnées.

L’opinion publique confond trop les notions de précaution et de prudence. La précaution induit trop souvent l’obsession de vivre avec un « zéro risque » qui conduit, le plus souvent à la paralysie. La prudence part de l’idée d’une obligation d’agir tout en pesant les bénéfices et les risques pour prendre des mesures proportionnées.

Or, est-il proportionné

- de vouloir « mobiliser des milliers de milliards de dollars dont la planète a besoin pour enrayer le changement climatique » (FMI et Banque Mondiale 2015) ?

- d’« interdire le financement pour l’exportations de centrale électriques à énergies fossiles sans techniques de capture du carbone » ? Les techniques de capture du carbone sont couteuses et inefficaces. Quand on sait que l’Afrique consomme dix fois moins d’énergie que l’Europe, on devine que les pauvres deviendront, avec cette mesure, encore plus pauvres.

- De décider, en Europe, le remplacement définitif des voitures thermiques par des voitures électriques ? Quand on sait que 80% des véhicules d’occasions sont exportés vers des pays à faible ou PIB moyen, on devine que la mobilité à l’intérieur de ces pays sera encore plus réduite qu’aujourd’hui ! Une entrave au développement supplémentaire !

Ne parlons pas d’un principe de précaution qui, quand il est utilisé à tort et à travers, ne fait que collaborer avec l’ennemi n°1 de notre époque : la peur.

4- Étant données ces prévisions, l’urgence d’un développement économique

Si donc, dans le pire des cas, la température reste constante dans les 150 années prochaines, quelle est l’urgence ?

Le développement des pays pauvres n’est possible qu’avec une énergie abondante et bon marché. Leur imposer des économies dé-carbonées est donc contreproductif.

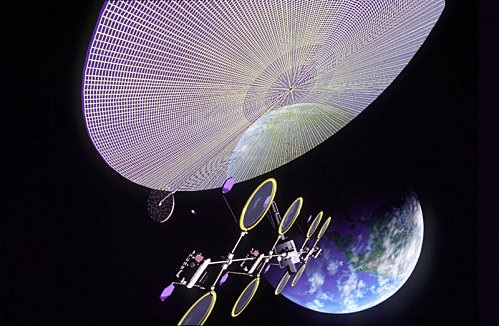

Quant aux pays développés, préparer le futur, ce n’est pas revenir à l’éolien. Il faut investir dans des énergies à « haute densité énergétique » comme de nouvelles générations de techniques nucléaires, la concentration d’énergie solaire par satellite, avec retransmissions par laser[3], etc.

[1] in Les Grands Cimetières sous la lune, page 419

[1bis] : http://www.sciencedirect.com/science/article/pii/S1367578816300931

[2] On sait que l’activité solaire n’intervient pas seulement à travers le seul TSI. Mentionnons les variations du magnétisme solaire (Courtillot, 2007), ses effets de bouclier envers le rayonnement cosmique, impactant la genèse des nuages (Svensmark, 2017, 2021), le vent solaire engendré par les éruptions solaires, (Landscheidt 2000), la répartition spectrale de l’irradiance, etc. (voir Soon (2015) pour une revue complète). Même si ces phénomènes ne sont pas encore suffisamment bien modélisés pour être intégrés dans les modèles physiques des CMIP, leurs effets n’en sont pas supprimés pour autant.

[3] Le principe consisterait à placer des satellites spéciaux en orbite géostationnaire à 35.000 km d’altitude et dotés de panneaux solaires de 50 mètres de long. La mission de ces satellites serait de récolter l’énergie qui arrive depuis notre soleil, de la concentrer en des rayons lasers infra-rouge puissants qui vont traverser notre atmosphère vers des capteurs géants. Ensuite, on reconvertit sur place l’énergie récoltée en électricité injectée sur le réseau électrique terrestre.

[3] Le principe consisterait à placer des satellites spéciaux en orbite géostationnaire à 35.000 km d’altitude et dotés de panneaux solaires de 50 mètres de long. La mission de ces satellites serait de récolter l’énergie qui arrive depuis notre soleil, de la concentrer en des rayons lasers infra-rouge puissants qui vont traverser notre atmosphère vers des capteurs géants. Ensuite, on reconvertit sur place l’énergie récoltée en électricité injectée sur le réseau électrique terrestre.

Un satellite expérimental, baptisé Arachne, pourrait être lancé en 2024 par l'entreprise Northrop Grumman.

Un tel projet présente néanmoins de grosses difficultés:

a) Le coût d'acheminement du satellite devrait avoir une envergure de 10 kilomètres carrés environ pour être efficace. Le coût par tonne de matériel transportée est actuellement de 8.300 à 18.700 $/kg de matériel mis sur orbite. Mais le lanceur SpaceX d’Elon Musk propose de le réduire jusqu'à 4.700 $/kg et l’Agence spatiale européenne, ArianeGroup et le CNES travaillent ensemble au développement d’un lanceur réutilisable, en mesure de proposer 5.000 $/kg. A 5.000 $/kg, le coût de l’assemblage d’une station d’un mégawatt, dont le poids est estimé par les ingénieurs chinois à 1.000 tonnes pour une centrale de 5 km², s’élèverait alors à 5 milliards de dollars.

b) La maintenance des panneaux solaires dans l'espace, soumis à des impacts de micrométéorites et aux radiations. Mais, la récente mise au point de films photovoltaïques organiques ouvre le champ des possibles en matière de centrale solaire spatiale.

La JAXA, agence spatiale japonaise, travaille également depuis 2009 en collaboration avec dix-sept entreprises privées à un projet de centrale solaire de 1.000 mégawatts (soit l’équivalent d’un gros réacteur nucléaire) à l’horizon 2030. La Russie et l’Inde travaillent sur des projets similaires et la Chine a récemment annoncé qu’elle avait, elle aussi, la ferme intention de mettre sur orbite, d’ici 2035, ses premières centrales solaires spatiales.