Le protocole de Montréal a été adopté en 1987 et ni les médias, ni les politiques, n'ont profité de son 30ème anniversaire pour en célébrer les mérites, comme s'ils craignaient de relancer un débat scientifique qui n'a jamais eu lieu. Depuis quelques années, des historiens ont entrepris de comprendre comment, malgré cette absence de débat, le trou d’ozone avait pu devenir une véritable icône environnementale. Certes, la période concernée est récente allant des années 1960-70 à aujourd’hui : le travail historique donc périlleux. Par ailleurs, le lecteur de documents historiques doit décrypter la propre posture de l’historien : la plupart d’entre eux participent à cette forme de fascination pour le consensus qui a conduit au fameux Protocole de Montréal ; d’autres, comme Stéphane Frioux (2011), confondent histoire et positions personnelles par exemple en faisant rimer Trente Glorieuses avec « Trente Pollueuses »[1]. La thèse de l’École des Hautes Études en Sciences Sociales soutenue en 2014 par Régis Briday a le mérite de faciliter l’accès à des sources indispensables, mais d’autres historiens se sont intéressés à ce phénomène comme Paul Edwards (2010), Hélène Guillemot, Heymann (2010) et tant d’autres.

La lecture de ces documents permet de mettre en évidence les disputes scientifiques, le rôle des industriels américains, la prégnance politique américaine et l’effet inhibiteur sur les esprits, pour ne pas dire dévastateur, de l’attribution mythique d’un prix Nobel.

Le trou d’ozone s’étant véritablement ancré dans l’imaginaire collectif des opinions, il est utile de faire une étude critique historique et scientifique du sujet. Il en ressort une absence totale d'identification du système complexe de l'ozone. Les séries d'observations n'étaient pas suffisamment longue quand la cause dite anthropique du "trou d'ozone" s'est ancrée dans les esprits. Il est de plus en plus probable qu'une cause liée à l'activité solaire apparaîtra comme incontournable.

Citation du jour: "C'est une belle théorie, mais contient-elle une vérité ?" (Einstein)

Dossier: "les2ailes.com"

Le dossier est articulé selon le plan suivant:

1- Aéronomie : Les anciens et les modernes.

1.1- De l’aéronomie et de l’aérologie.

1.2- L’alibi des supersoniques transatlantiques.

1.3- Les premiers lanceurs d’alerte.

2- Les controverses scientifiques.

2.1- L’éternel déséquilibre entre les modèles trop simplistes…...

2.2- L’éternel déséquilibre entre les modèles trop simplistes… et leur excès de complexité.

2.3- Le recours au catastrophisme.

2.4- Le caractère unidimensionnel des modèles de l’époque.

2.5- Les réalisations qui ne confirment pas les prévisions.

2.6- Le consensus : argument d’autorité développé par Molina.

2.7- Le procès en conflit d’intérêt entre Molina et Rowland vis-à-vis de la NASA..

2.8- L’absence de recours à la discipline de la détection-attribution.

2.9- La problématique géographique.

3.- L’élaboration d’indices et de concepts hasardeux.

3.1- Les indicateurs relatifs à la couche d’ozone.

3.2- Les indicateurs faisant le lien entre l’ozone et le climat

3.3- Le concept de panier d’ODS.

4- La controverse inhibée par l’administration américaine et la stratégie Dupont de Nemours

4.1- L’amendement au Clean-Air Act de 1977.

4.2- Le changement de stratégie de l’industrie américaine des CFC..

4.3- La création de l’UNEP.

4.4- Le monopole américain des mesures satellitaires.

4.5- La fuite des « cerveaux » de l’ozone vers le GIEC..

4.6- La signature des accords internationaux.

5- Un temps de prises de décisions politiques.

5.1- Décisions politiques fondées sur des approximations.

5.2- La Convention de Vienne.

5.3- Le protocole de Montréal

5.4- La mise en place d’organes de gouvernance.

5.5- Une gouvernance érigée comme une « référence » pour le climat

6- Le Prix Nobel : une science inexacte !

7- La remise en cause de l’origine anthropique du « trou d’ozone ».

7.1- Les mécanismes de la biosphère.

7.2- Le rôle des rayons cosmiques sur la couche d’ozone.

7.3- Le rôle des volcans.

7.4- Le rôle de l'activité géomagnétique terrestre

7.5- La vraie question des "modèles numériques"

8- Une opération de diversion : l’amendement de Kigali

8.1- L’extension de l’approche par « panier multiples » des ODP aux GES.

8.2- L’avenant de Kigali

8.3- La mise en place d’un nouvel organe : la CCAC..

9- L’impact anthropique sur l’atmosphère : trois alibis ?

9.1- Un alibi pour justifier une fiscalité mondiale supplémentaire: le MultiLateralFinance

9.2- Un alibi pour la bio-ingénierie

9.3- Un alibi pour les malthusiens

10- Conclusion

1- Aéronomie : Les anciens et les modernes

1.1- De l’aéronomie et de l’aérologie

L'aéronomie est l'étude des propriétés physiques et chimiques des parties de l'atmosphère où les réactions d'ionisation et de dissociation deviennent prédominantes par opposition à l'aérologie qui étudie les portions de l'atmosphère où les phénomènes de turbulences ont une importance majeure (Wikipedia)

Ce n’est que lorsque les modèles mathématiques, exploitant une troisième dimension de l’atmosphère, sa verticalité , qu’on a parlé d’aérologie. C’est Wladimir Köppen, qui a proposé en 1906 ce nom d’aérologie « pour l’étude de la haute atmosphère ».

1.2- L’alibi des supersoniques transatlantiques

De nombreux débats avaient eu lieu dès les années 1965 à propos de l’accusation de détruire la couche d’ozone, accusation portée par un chimiste de Boeing, Halstead Harrison, contre les Supersoniques transatlantiques (SST). Il publie en 1968 un article intitulé “The Condensation and Sublimation of CO2 with H2O: Carbonic Acid on Mars?”[2] . Le modèle qu’il avait mis en place calcula qu’un « faible nombre d’avions supersoniques [pouvait] perturber la couche d’ozone de manière significative, du fait de leurs émissions de vapeur d’eau dans la basse stratosphère terrestre »[3]. Cette hypothèse sera reprise par Russel Train en 1970. Elle suscitera, comme nous le verrons, des vocations chez d’autres scientifiques, qui élaboreront de nouvelles théories de destruction de l’ozone par les SST à partir de 1971. Pourtant, racontera Halstead Harrison en 2003, il était pour sa part alors « pratiquement certain » que cette inquiétude au sujet de l’altération de la stratosphère par la vapeur d’eau des SST était « exagérée », que ce soit au moment de ses premières modélisations en 1966-67, ou en 1970- 71, au plus fort de la controverse sur les SST. En 2003, il se disait être convaincu que les SST n’avaient jamais eu effectivement d’impact significatif sur la composition de l’ozone. Harrison raconte qu’il mesurait tout à fait les limites de ses modélisations.

Lors d’une conférence scientifique, organisée devant le Congrès par Hirschfelder le 18.3.1971, le chimiste Berkeley-Harold Johnston était parvenu, lui aussi à son hypothèse sur la destruction de l’ozone par les NOx des SST.

Toutes ces polémiques avaient provoqué une réelle agitation dans l’opinion américaine sous la pression de pétitions dès 1974[4].

1.3- Les premiers lanceurs d’alerte

Le tournant des sciences de l’atmosphère vers des programmes environnementaux était déjà en marche.

Dans les années 1960-70, la modélisation informatique bouscule violemment les pratiques des scientifiques de l’atmosphère, en particulier sous l’impulsion notamment des programmes chapeautés par des météorologistes théoriciens, Carl Gustav Rossby, John von Neumann et Jule Charney. Leurs programmateurs informatiques avaient requis un pouvoir d’expert supérieur aux météorologistes et climatologues traditionnels . Comme l’a fait remarquer l’un des acteurs de l’expertise états-unienne de l’ozone dans les années 1970, Harold Schiff, rares sont les chercheurs des débuts de la recherche sur la destruction de l’ozone qui ont été des "membres de la clique de chercheurs qui avaient choisi la chimie stratosphérique comme spécialité… Leur statut institutionnel de petit groupe de scientifiques… a pu renforcer leur identité collective"[5].

L’historien Paul Edwards a montré que ce changement avait été "provoqué, non par des climatologues traditionnels, mais par des scientifiques rompus à la météorologie théorique et à la programmation informatique qui travaillaient au sein d’une poignée d’institutions dotées d’immenses ressources informatiques"[6].

C’est dans ce contexte qu’émergent M. J. Molina et F. S. Rowland qui publient en 1974, dans Nature[7], leur étude "Stratospheric Sink for Chlorofluoromethanes: Chlorine Atom-Catalysed Destruction of Ozone". Leur raisonnement[8] partait des mesures de CFC (Chloro-Fluoro-Carbonés) atmosphériques de Lovelock et d’autres. Ils constataient le taux de production [important] de CFC par l’industrie chimique. S’appuyant sur des données spectroscopiques et chimiques compilées avec un œil critique dans des tables, ils mettent en œuvre des calculs informatiques, qui utilisaient des "coefficients hypothétiques" ("assumed coefficients") extraite d'un modèle de "diffusion tourbillonnaire" ("eddy diffusion") à une dimension pour trouver l’altitude à laquelle les CFC seraient décomposés par les rayons UV. Ils comparent leur système CFC/chlore avec un système semblable N2O/NO sur lequel Paul Krutzen[9] avait travaillé quelques années avant. Ils font également appel à des modélisations faites par Kockarts et Brinkmann[9bis]. Molina et Rowland reconnaissent le caractère théorique de leur publication puisqu'ils utilisent en seulement 3 pages, 12 fois des expressions de type "estimated", "expected", "roughly","substantial uncertainties", "assumed", "presumabily", "believed", "it seems". Ils reconnaissent leur approximation en matière d'activité solaire: "Les intensités appropriée des UV solaires à une altitude de 30 km peuvent être incertaines par un facteur de 2 ou 3"! (Nature, 1974, p. 811).

Leur chaîne de réaction CFC/chlore s’appuie sur les trois réactions suivantes :

CF2CL2 + hv → CF2Cl + Cl- (photodissociation), puis: Cl- + O3 → ClO- + O2, puis: ClO- + O- → Cl- + O2.

La formation chimiste de M. J. Molina et F. S. Rowland peut expliquer la hâte qu’ils montrèrent à conclure à une destruction possible d’ozone stratosphérique, là où beaucoup d’aéronomes étaient alors moins prompts à admettre la vulnérabilité du grand monstre géologique qu’est la couche d’ozone – alors qu’ils connaissaient, eux aussi, les travaux récents sur la diffusion des composés chlorés vers la stratosphère, en particulier ceux de James Lovelock communiqués depuis 1970.

2- Les controverses scientifiques

Peu de critiques réussirent à se développer contre les hypothèses proposées par M. J. Molina et F. S. Rowland. En effet, les scientifiques étaient rares, à l’époque, à avoir une autorité à la fois en aéronomie et en chimie. :

- J.N. Pitts et J.A. Taylor (University of California) ;

- C. Sandorfy (University of Montreal) ;

- R.A. Rasmussen (Washington State University) ;

- Richard Segar Scorer, météorologiste et Professeur de mécanique théorique à l’Imperial College.

Par ailleurs, Du Pont de Nemours et les producteurs de CFC (Chloro-Fluoro-Carbonés), de manière maladroite, feront appel, financements à l’appui, aux rares scientifiques de l’atmosphère contestataires. Dès lors, dès qu’ils s’exprimaient, ils se faisaient accuser de conflit d’intérêt[10] :

- James Lovelock, avait été financé pendant quelques mois par DuPont au début des années 1970 pour ses travaux sur l’accumulation des CFC dans l’atmosphère (sans lien alors avec la destruction de l’ozone).

- Quant à Richard-Segar Scorer, il fut décrédibilisé en 1975 lorsque le journal Los Angeles Times révéla qu’il avait reçu un financement de Hill & Knowlton et donc indirectement du lobby industriel[11].

Malgré tout, dès l’été 1976, Richard Scorer publia dans des revues à comité de lecture : c’est donc que les scientifiques de l’atmosphère ne pensaient pas que les objections scientifiques de Richard Scorer fussent ridicules .

Il n’empêche que, en réponse aux controverses, Rowland cru nécessaire de publier, dans le New Scientist du 2.10.1975, un « rapport d’étape » (status report) de 4 pages "Chlorofluorométhanes ans stratospheric ozone - a scientific staus report", courbes et équations à l’appui.

Nous évoquons ici les principales critiques qui seront mises en avant pendant près de 40 ans.

2.1- L’éternel déséquilibre entre les modèles trop simplistes…

Richard Scorer appela à se méfier des modèles de chimie-transport des années 1970. D’abord la puissance des ordinateurs était, à cette époque, beaucoup plus réduite qu’aujourd’hui. Par conséquent, « les compromis réalisés entre modélisation de la dynamique et modélisation des réactions chimiques sont nombreux », afin d’éviter de conduire les capacités des ordinateurs à saturation, et afin de réduire le temps de calcul à un nombre d’heures raisonnable.

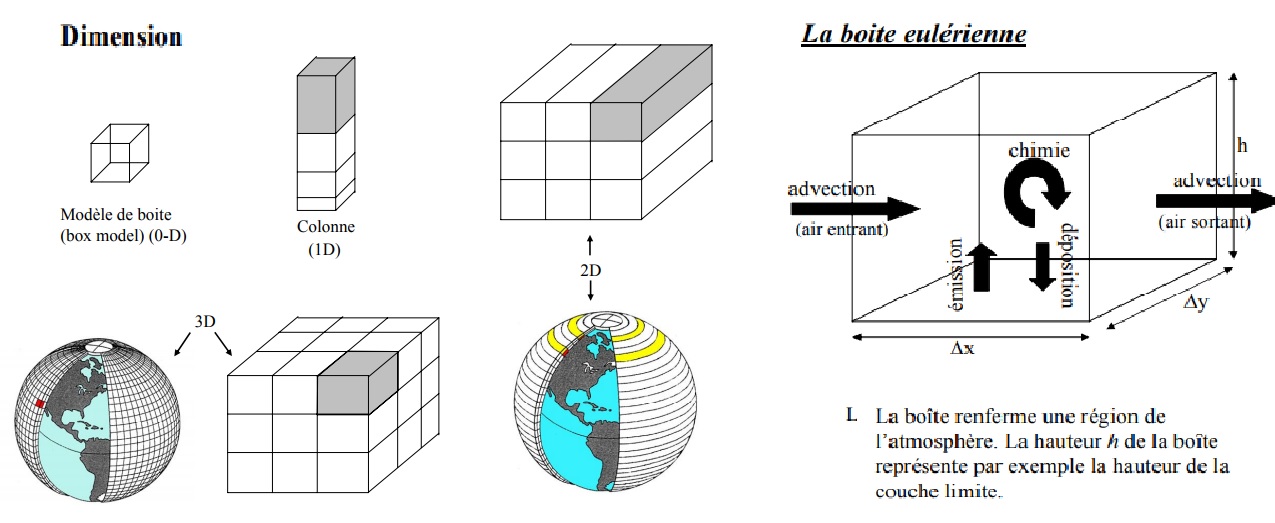

En quoi les pratiques de modélisation atmosphérique des années 1970 consistent-elles ? L’historien des sciences, Matthias Heymann, écrit dans un article intitulé « Lumping, testing, tuning : the invention of an artificial chemistry in the atmospheric transport modelling » : "Depuis la fin des années 1950, écrit Heymann, la simulation informatique a été utilisée pour l’étude du transport des polluants dans l’atmosphère"… Matthias Heymann distingue trois moments dans l’élaboration des équations… :

- Une phase de "lumping" (littéralement regroupement) qui permet de réduire le nombre d’équations dans l’atmosphère réelle, soit en regroupant plusieurs équations en une seule, en assimilant plusieurs composés à un seul, sous prétexte de leur appartenance à une même famille chimique.

- Une phase de "testing", c'est-à-dire de comparaison des données mesurées et des résultats des simulations… mais il faut préciser que "souvent les éléments individuels des modèles de simulation ne peuvent être testés indépendamment, dans la mesure où seul le résultat global est accessible", quantifiable[12] (p. 353)

- Une phase de "tuning" (réglage) qui mène en particulier à l’élaboration de ce que les scientifiques de l’atmosphère appellent des "paramétrages". Les paramétrages sont des expressions mathématiques souvent simples et induites à l’aide d’une argumentation empirique après l’analyse du comportement physique de données collectées lors de diverses campagnes de mesure in situ. Elles suppléent aux équations théoriques déterministes lorsqu’il n’est pas possible de les élaborer à l’échelle de la maille du modèle, mais seulement à une échelle inférieure[13].

Ces trois phases de lumping/testing/tuning se sont imposées dans les pratiques de modélisation de la stratosphère, …mais, jusqu’aux années 1980, il semble que les communautés de la stratosphère et de la troposphère aient rarement échangé afin de développer leurs modèles numériques respectifs.

2.2- L’éternel déséquilibre entre les modèles trop simplistes… et leur excès de complexité

Les modèles à deux et trois dimensions ont été élaborés au cours des années 1980 ; le nombre d’équations chimiques pris en compte augmenta inexorablement : "Plus de 192 réactions chimiques et 48 processus photochimiques sont impliqués dans la destruction de la couche d’ozone causée par les CFC, mais, aucun modèle de les reflète tous"[14]. C’est ce que reconnaissait une des scientifiques influents de la chimie atmosphérique pourtant proche des thèses de Molina.

Les premiers modèles tridimensionnels "ont été développés au début des années 1980. Ils prenaient en compte les effets turbulents et divisaient la terre en un maillage" géographique qui combinait donc altitude, latitude et longitude. Toutefois, comme en atteste le grand rapport international WMO/UNEP/… « atmospheric Ozone » de 1985, les scientifiques de l’ozone comptaient peu sur les modèles 3-D au milieu des années 1980.

Le professeur Bernard Aumont, du laboratoire LISA, visualise très bien le concept de modèle en 3D [15].

L’historienne Hélène Guillemot parlera d’un consensus « pratiquement général » qui se construira, y compris sur les incertitudes ! Elle juge délicat le compromis qui s’établira entre,

- d’une part, un tropisme des scientifiques pour une complexité croissante des modèles, tropisme "naturel" en phase de "science normale", et renforcé par l’augmentation spectaculaire du nombre d’études sur le changement climatique et par la puissance croissante des ordinateurs;

- et, d’autre part, le risque d’accroître les incertitudes des résultats des modélisations, à mesure que l’on intègre de nouveaux paramètres et de nouveaux résultats de mesure[16].

Dans l’étude de l’ozone global, comme dans celle de tout problème systémique, il est possible de négliger certains aspects de la réalité pour en souligner d’autres. Les modèles mathématiques se prêtent admirablement à cette stratégie…

2.3- Le recours au catastrophisme

Il s’agit d’une pratique assez courante chez certains scientifiques qui, faute de pouvoir faire la preuve d’une relation de cause à effet, joue du catastrophisme sur les conséquences du phénomène dont ils prétendent expliquer les causes.

Richard Scorer suspecta M. J. Molina d’avoir suggéré à un journaliste que "nous serions bientôt frits par les rayons UV-B qui atteindraient la surface de la terre après destruction de la couche d’ozone", avant d’ajouter quelques lignes plus loin : "les scientifiques sont certainement tentés d’effrayer ceux qui tiennent les cordons de la bourse de la recherche, et de nombreux scientifiques m’ont dit qu’utiliser la peur pour obtenir des financements étaient de toute évidence une bonne tactique"[17].

Ceci étant, les adversaires de M. J. Molina usaient d’arguments tout aussi émotionnels comme celui de Lovelock pour remettre en cause les études sur le trou d’ozone : "Si trop d’UV pourrait vouloir dire : cancer de la peau, trop peu signifie très probablement : rachitisme … De faibles niveaux d’UV pourraient être bénéfiques à d’autres espèces d’une manière que nous ne connaissons pas encore"[18].

Comme souvent, certains analystes prétendent observer les conséquences d’un phénomène pour prouver son existence, même si ce raisonnement n’apporte aucun élément sur son origine causale. Malgré tout, un chercheur de l’Université d’Arizona, James McDonald, s’étonna des prétendus liens entre cancer et Ozone. En 1970, des médecins croyaient que les radiations ultraviolettes causaient certaines formes de cancer de la peau. Or, disait James McDonald, "la couche d’ozone nous protège de ce type de radiations. S’il y avait déplétion, le nombre de cancers de la peau augmenterait. Pour James McDonald, le facteur amplificateur était en effet de 6 : chaque % de réduction de la concentration d’ozone produirait 6% d’augmentation de cancers de la peau". McDonald rendit compte de ces effets devant le Congrès en mars 1970.

Dans LeMonde du 30 janvier 1997, on put lire la dépêche suivante de l’AFP : Lors d’une conférence de presse tenue le 27 janvier au Costa Rica, le Néerlandais Paul Crutzen, prix Nobel de Chimie 1995…, a affirmé : « Lorsque des prévisions apocalyptiques furent avancées, on ne connaissait pas exactement l’ampleur de la détérioration de la couche d’ozone. Maintenant, on sait que les dégâts sont très faibles. Maintenant la démonstration a été faite que la couche d’ozone se détériore à un rythme fort ralenti » (Dépêches, « LeMonde », 30.01.1997, p. 24)

2.4- Le caractère unidimensionnel des modèles de l’époque

La critique de Richard Scorer porta principalement sur le caractère unidimensionnel des modélisations qui ne prenaient donc pas seulement en compte la dimension verticale des masses d’air. Les processus d’advection, qui se déploient dans les deux autres dimensions du référentiel atmosphérique, manquaient à l’appel. Il pointa du doigt la dynamique atmosphérique trop simpliste de ces modèles. Les rapports officiels ont d’ailleurs confirmé la critique : « L'incapacité des modèles unidimensionnels et bidimensionnels à reproduire l'ozone stratosphérique supérieur et les différences significatives parfois observées entre les modèles… sapent notre confiance dans l'évaluation à long terme » (rapport WMO/UNEP 1985, introduction, p. 18).

2.5- Les réalisations qui ne confirment pas les prévisions

Un chimiste britannique, Robert Watson créa en 1986 un « Ozone Trends Panel », composé de 21 membres[19]. Ce panel devait chercher à résoudre le conflit entre les mesures antarctiques des masse surfacique de l'ozone, exprimées en Dobsons[20], et celles du satellite instrumental « Total Ozone Mapping Spectrometer (TOMS) ». Le Panel conclut que les données satellites donnaient bien, comme les ‘Dobson’, une destruction d’ozone dans les latitudes moyennes en hiver. Toutefois, même après de nouvelles analyses, en 1988, les tendances à la baisse que l’on pouvait dégager avec les données de TOMS étaient toujours "deux fois plus importantes que celles prédites par les modèles théoriques"[21]. Il est symptomatique de voir que le futur prix Nobel, F.S. Rowland, était signataire de ce rapport et avait donc conscience des écarts entre prévisions et réalisations.

Les scientifiques convaincus de la pertinence de l’hypothèse de Molina-Rowland hésitèrent à lancer de nouveaux appels à légiférer. La première raison tenait au fait que, sur la base de nouvelles mesures (réalisées notamment à l’aide de LIDAR et de détecteurs de micro-ondes), un consensus s’est dégagé à la fin des années 1970 sur le fait que les chlores agissaient surtout autour de 40 kilomètres d’altitude. Par conséquent, les émissions anthropiques de composés chlorés engendreraient une destruction d’ozone moindre que prévue auparavant, pour des altitudes plus faibles, plus riches en ozone. Pour cette raison d’altitude et d’autres raisons scientifiques, la destruction d’ozone prédite par la plupart des modèles diminua de manière générale entre 1979 et 1983, par rapport aux prédictions antérieures.

Les prédictions de destruction de la couche d’ozone passèrent de 15% (CCOL n°3 ; Paris, 1979) à 10% (CCOL n°4 ; Bilthoven, 1980), puis à 5-10% (CCOL n°5 ; Copenhague, 1981) et à 3-5% (CCOL n°6 ; Genève, 1983)[22]. Or, à cette époque, les décisions politiques d’interdiction des CFC (Chloro-Fluoro-Carbonés) ne pouvaient pas avoir eu d’effet, d’autant moins que les experts reprochaient une longue durée de vie de ces composés dans la stratosphère.

Le rapport officiel de 1985 reconnaissait d’ailleurs que « Notre confiance dans les modèles (en particulier à des fins d'évaluation) dépend de la «validation» satisfaisante de ces modèles par rapport aux données disponibles. C'est trop souvent un exercice extrêmement subjectif ». (rapport WMO/UNEP 1985, Vol. 1, introduction, p. 17).

Dix ans après, les rapports admettaient que l’incertitude n’était pas levée : « Des modèles tridimensionnels et bidimensionnels ont été utilisés pour simuler la chimie des nuages stratosphériques polaires (PSC) dans le vortex et comment le transport vers l'équateur de l'air polaire perturbé chimiquement peut affecter l'ozone à mi-altitude. Notre manque de compréhension des mécanismes détaillés de la dénitrification, de la déshydratation et des processus de transport réduit notre confiance dans ces prévisions du modèle » (rapport WMO 1994, Stratospheric models § 6.1, p. 261).

Dans ce contexte d’édulcoration du risque et de forte instabilité de la science de l’ozone, les industriels états-uniens allaient réclamer "plus d’expertise scientifique", et surtout "plus de mesures d’ozone in situ et de données de laboratoire"[23].

Avec le temps, les prévisions ne se réalisèrent toujours pas : vers 1990, les "preuves empiriques" d’une destruction anthropique d’ozone importante au-dessus de l’Antarctique mirent à mal la théorie chimique de l’ozone, que les auteurs du grand rapport de 1985 pensaient être parvenus à stabiliser. Des campagnes de mesures indiquèrent qu’un trou "se creusait" aussi en Arctique d’une année sur l’autre, le phénomène étant de moindre ampleur qu’en Antarctique, toutefois). Les scientifiques proposeront en particulier une théorie complexe de chimie hétérogène pour les nuages polaires stratosphériques (ou PSC, pour ‘Polar Stratospheric Clouds’) [24].

Comment les prévisions des modèles pourraient-elles se réaliser quand on lit que « les projections futures n'incluent pas l'influence des éruptions volcaniques ou des variations du cycle solaire » (Rapport WMO 2010, rapport pour les décideurs, fig. ES2 §d).

2.6- Le consensus : argument d’autorité développé par Molina

Charles Scorer reproche ce recours à l’idée de consensus : "On a dit que, puisque plusieurs modèles à une dimension faits par des personnes différentes avaient donné des résultats semblables, il existait par conséquent un consensus [souligné en gras par Scorer] à l’intérieur de la communauté scientifique … Or l’accord survint parce que tous les scientifiques avaient utilisé le même modèle défaillant et obtenu la même réponse erronée"[25].

2.7- Le procès en conflit d’intérêt entre Molina et Rowland vis-à-vis de la NASA

Plus tard, à Kyoto, les deux chercheurs insistèrent sur le chlore d’origine volcanique comme destructeur potentiel de la couche d’ozone, parce que la NASA leur aurait demandé de ne rien dire à propos de la navette spatiale.

2.8- L’absence de recours à la discipline de la détection-attribution

a) L’identification des systèmes climatiques complexes.

Nous verrons au § 7 que, près de quarante ans après l’étude publiée par M. J. Molina et F. S. Rowland, des chercheurs se sont intéressés à l’impact des variations de rayons cosmiques sur la couche d’ozone. D’autres se sont interrogés sur l’impact éventuel de l’activité volcanique.

La détection d’un effet, l’épaisseur de la couche d’ozone, et son attribution à une de ces causes nécessitent l’appel à de multiples disciplines : des climatologues, aérologues, aéronomes, chimistes, physiciens, hélio-sismologues, géographes, médecins, … Comment mettre d’accord toutes ces disciplines ? L’identification des systèmes complexes est la seule qui permet de quantifier des relations de cause à effet et de donner une cohérence scientifique à des disciplines aussi diverses, dont certains s’occupent des causes et les autres des conséquences.

Cette discipline nécessite de définir une structure simple du modèle d’identification, d’observer, sur une longue durée, le comportement du système, d’identifier quelques paramètres essentiels du système et d’évaluer a posteriori la validité du modèle.

b) Les difficultés de la « détection - attribution » dans les années 1970-2000

Malheureusement, pendant les années 1970 à 2000, la communauté scientifique ne disposait pas de mesure séculaire, ce qui est un minimum. Les premières données sur l’ozone stratosphérique datent seulement des années 1930. S. Larsen et T. Hendrikson ont analysé les données accumulées depuis 1935 à Oslo et Trömso sur l'ozone du cercle arctique et publié des résultats dans Nature en 1990. La concentration en ozone serait restée constante, si on exclut la baisse des années 1958 à 1962, époque où les CFC n'étaient pas encore utilisés à grande échelle. Quatre études[26] américaines, qui portent sur les années 1970 à 1984, donnent une variation de la concentration d'ozone stratosphérique qui va de -0,26 à +1,5, variation insignifiante et qui reste dans les limites de l'erreur de mesure.

C’est ce qui a amené beaucoup de scientifiques à remettre en cause l’approche de M. J. Molina et F. S. Rowland sur plusieurs critères :

- le paramétrage de leurs modèles

Lorsqu’ils ont pris en compte des aspects dynamiques, les modélisateurs de la chimie stratosphérique s’en sont jusqu’alors tenus au mieux à des paramétrages très grossier des mélanges de polluants dans l’atmosphère.

- la collecte des mesures

Nombreux sont les scientifiques de l’atmosphère qui concédèrent les grandes limitations de la modélisation numérique des variations de concentration d’ozone stratosphérique en fonction de l’apport en polluants parce que les simulations étaient très imparfaitement soutenues par les mesures atmosphériques physiques et chimiques[27].

- l’absence de prise en compte des variations naturelles

Dès 1978, un article publié dans la revue Nature par Jack Fishman et Paul Crutzen “The origin of ozone in the troposphere”, contesta le fait que, comme le pensent la plupart des atmosphériciens de l’époque, la première source d’ozone troposphérique provienne de la stratosphère, en descendant massivement au niveau des hautes latitudes moyennes de chaque hémisphère. Les deux chercheurs du National Center for Atmospheric Research (NCAR) arguaient que, puisqu’il y a beaucoup plus de terre dans l’Hémisphère nord, et par conséquent plus de captation d’ozone atmosphérique (car les vitesses de déposition d’ozone atmosphérique sont plus importantes au niveau des terres que des océans), on aurait dû observer un déficit d’ozone dans l’Hémisphère nord. Les mesures n’indiquaient rien de tel[28].

Il faudra donc attendre les années 2005 pour que des observations sur des durées suffisantes permettent de retenir d’autres causes des variations de la couche d’ozone. (cf § 7)

c) Ni quantification ni calcul de probabilité !

Quand il n’y a pas de quantification des relations de cause à effet, il n’y a pas, bien sûr, de calculs de probabilité qui pourraient préciser les degrés de confiance que les scientifiques accordent à leurs allégations. Dans les rapports officiels de 1985, il est même précisé que « le déséquilibre significatif de l'ozone dans la région photochimiquement contrôlée de la moyenne atmosphère limite la confiance que l'on peut accorder aux prédictions du modèle des futurs changements d'ozone en réponse aux augmentations à long terme des concentrations atmosphériques de gaz sources (chlorofluorocarbones, protoxyde d'azote, méthane) » (rapport UNEP/WMO 1985, Vol. 1, introduction, p. 14).

Et quand le même rapport chiffre à 95% le degré de confiance, il ne s’agit pas de la probabilité de relation de cause à effet, mais d’un simple degré de précision de la mesure des observations de taux d’ozone : « L'examen du programme de mesure satellitaire NOAA SBUV-2 indique que si le système fonctionne comme prévu, il est capable de détecter les tendances de l'ozone dans la stratosphère moyenne à supérieure, ainsi que l'ozone total, à environ 1,5% sur une période d'une décennie au niveau de confiance de 95% ». (Rapport WMO/UNEP 1985, Vol. 1, introduction, p. 20)

2.9- La problématique géographique

Les scientifiques s’interrogent également sur la raison pour laquelle le « trou d’ozone » se trouverait surtout au dessus de l’Antarctique, où, à l’évidence, les émissions de gaz industriels sont les plus faibles. Or les vents polaires majoritaires poussent les masses d’air vers les latitudes faibles et non vers les pôles. Pourquoi ces gaz, surtout émis par l’hémisphère Nord exerceraient-ils leur ravages dans l’hémisphère sud ?Certes, les nuages convectifs tropiques peuvent même aller jusqu'à entraîner des gaz se trouvant au niveau du sol jusqu'à la partie stratosphérique, mais les courants de haute altitude oscillent essentiellement d’est en ouest et vice versa (Oscillations Quasi Biennales - QBO) ; les vents d’altitude de la Cellule de Ferrel, c'est-à-dire dans les zones tempérées et donc les plus industrielles, sont orientées des pôles vers l’équateur et non l’inverse. Ces turbulences ne plaident donc pas pour des accumulations de gaz industriels sur les pôles.

La question se pose d’autant plus que des mesures faites à 30 km d'altitude montrent qu'on n'y trouve pas de CFC[29], là où les baisses les plus fortes d’ozone sont enregistrées. Ces molécules lourdes ont plutôt tendance à tomber sur le sol, à s'y infiltrer dans les fissures, à être adsorbées sur les argiles et l'humus et à être détruites par des bactéries anaérobies friandes de cette substance. Ou bien elles tombent sur la surface des lacs et des mers et y sont dissoutes dans l'eau et détruites par les micro-organismes et les algues. La végétation absorbe également de grandes quantités de fréons comme l'ont montré les analyses de fumées de forêts.

3.- L’élaboration d’indices et de concepts hasardeux

3.1- Les indicateurs relatifs à la couche d’ozone

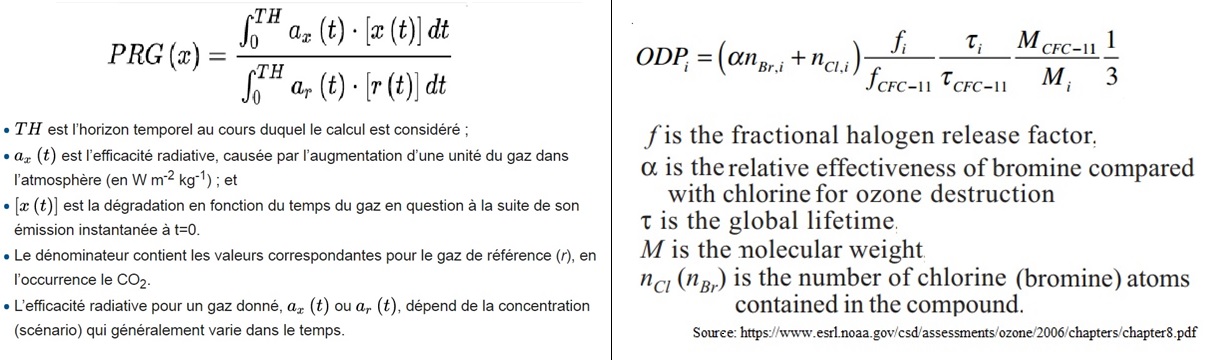

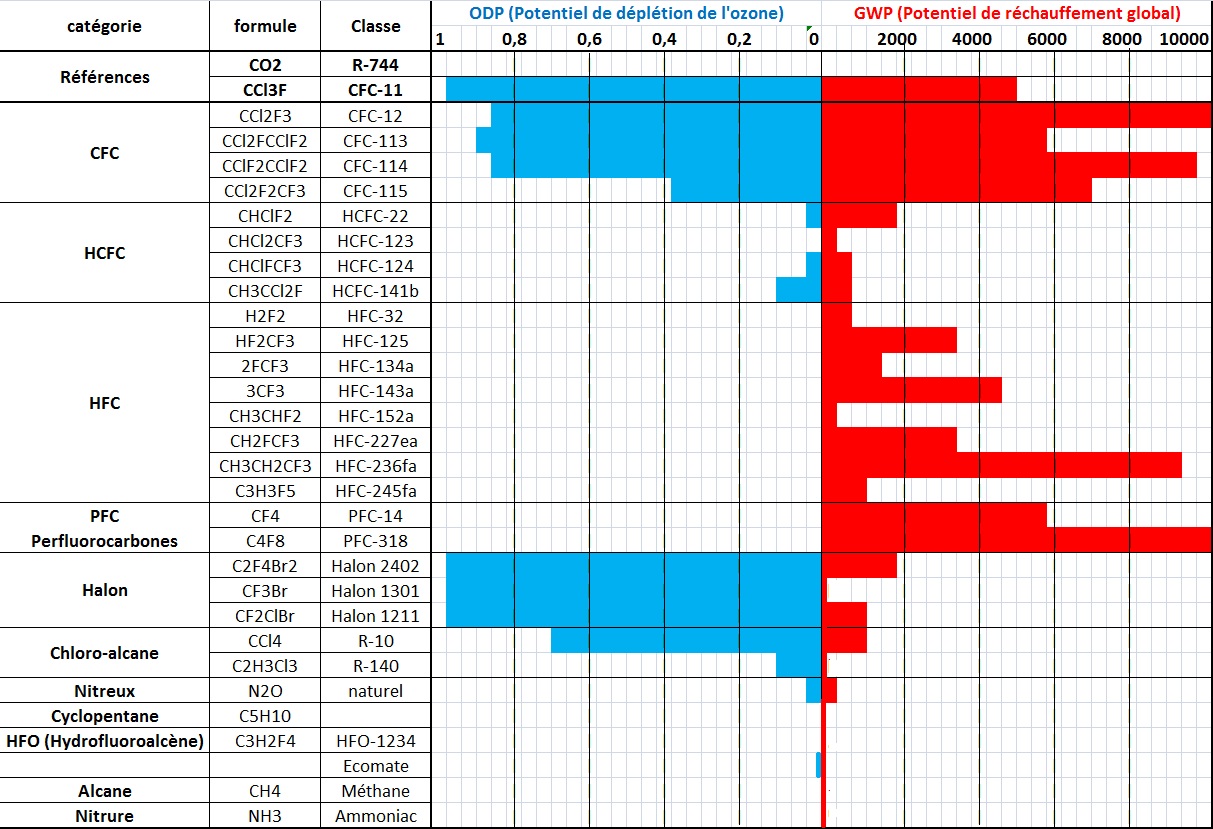

En 1981, et à la demande de l’US Environmental Protection Agency (EPA), Donald Wuebbles[30] introduit une notion de « potentiel relatif de destruction d’ozone des gaz » (ODP). Celle-ci est une estimation quantifiée du potentiel relatif de destruction d’ozone des halocarbones par rapport à un gaz référent, l’un des deux CFC les plus libérés dans l’atmosphère (avec le CFC-12), le CFC-11. « Les valeurs d'ODP ont toutes été basées sur les changements d'ozone calculés dans une atmosphère modélisée » (rapport WMO 1989, § 4.3.4.2). Cette atmosphère modélisée exclue tout effet éventuel des rayons cosmiques.

D’autres indicateurs seront introduits dans les débats sur l’ozone peu après l’ODP :

- La "charge en chlore (‘chlorine-loading’) »

- et le "potentiel de charge en chlore (‘chlorine loading potential’ (CLP)" de la stratosphère.

Pourtant, étant donné l’absence de quantification rigoureuse de relation de cause à effet entre le CFC-11 et la couche d’ozone, il est hasardeux de comparer de manière très théorique les effets d’autres molécules par rapport à ce CFC-11, dont, en définitive, aucune preuve définitive de l’effet n’a été apportée. C’est pourquoi plusieurs controverses auront lieu au sujet des conséquences politiques de l’utilisation, soit de l’ODP, soit de la charge en chlore stratosphérique. On fera, en particulier, remarquer que certains ODS n’ont pas le même ODP selon la composition de l’air où ils se trouvent.

Il n’empêche : des tableaux comparatifs de l’ODP est largement diffusé aux négociateurs. C’est ainsi que l’ODP et la "charge en chlore" joueront un rôle décisif de médiation entre les décideurs politiques et l’industrie, et entre les négociateurs nationaux.

Comme l’a montré Karen Litfin[31], en 1989, les scientifiques de l’ozone jugeaient qu’ils avaient établi le lien entre trou de la couche d’ozone et CFC sur la base de leurs mesures de terrain. Mais, la théorie du trou de la couche restait quant à elle seulement embryonnaire. Dans une telle situation où les modèles étaient impuissants à rendre compte du phénomène, écrit K. Litfin, l’utilisation de la charge en chlore de l’atmosphère comme indice était « la stratégie discursive » la plus crédible pour formuler des propositions de nouvelles réglementations, dans la mesure où un calcul fiable d’ODP nécessitait une théorie physico-chimique qui n’existait pas encore.

3.2- Les indicateurs faisant le lien entre l’ozone et le climat

a) Invention et contenu des indicateurs

Au milieu des années 1980, des scientifiques décident d’élaborer un "Global Warming Potential" (GWP) sur le modèle de l’ODP. On ajoutera[32] un indicateur "Halocarbon Global Warming Potential" qui est le GWP spécifique aux halo-carbones. La référence est à nouveau celui du CFC11 = 1.

Quand le Giec sera créé en 1987, ses experts retiendront le CO2 comme gaz de référence en remplacement du CFC11. Des collègues aéronomes-climatologues demanderont alors à Donald Wuebbles de développer un GWP pour le GIEC, qui serait « un pouvoir de réchauffement climatique » relatif au pouvoir de réchauffement du CO2 (avec GWP (CO2) =1)[33].

Les inventeurs de ces indices se drapent derrière un paravent de formules mathématiques qui les rendent crédibles.

Ce n’est que sept ans après son invention que l’indicateur est évoqué dans les rapports Mais ces rapports donnent des tableaux comparatifs des ODP/GWP. Il y est simplement indiqué que « des modèles atmosphériques globaux unidimensionnels et bidimensionnels ont déterminé des ODP pour un certain nombre d'halocarbures, y compris des CFC, d'autres composés chlorés, plusieurs hydrohalocarbures de remplacement potentiels et plusieurs composés bromés » (rapport WMO 1989, résumé pour les décideurs, p. xxix), or, ce sont précisément ces modèles que les mêmes auteurs jugent comme relevant d’un « exercice extrêmement subjectif » ! (cf ci-dessus § 2.5). En tout état de cause, la « discussion » n’est pas à l’ordre du jour, puisque dans le cœur du rapport WMO de 1989, il est simplement dit : « Le concept de potentiel relatif d'appauvrissement de la couche d'ozone (PDO), introduit par Wuebbles (1981), a été adopté comme référence ou référence rapide pour estimer le potentiel relatif de destruction de l'ozone stratosphérique par les CFC et autres halocarbures. … Ce concept joue un rôle important dans la mise en œuvre des politiques de réglementation pour les CFC entièrement halogénés adoptés dans le Protocole de Montréal » (rapport WMO 1989, § 4.3, p. 424). Qu’importe le contenu du « concept » (sic) pourvu qu’on ait l’ivresse de pouvoir en tirer des « politiques de réglementation ».

Qui plus est, il semble que les valeurs chiffrées découlent « du modèle de DuPont » (rapport WMO 1989, § 4.3, p. 425, fig. 4.3.1) ! Que penser d’indicateurs comparant des substituts de CFC quand ils sont élaborés par l’industriel produisant les dit-substituts ?

Le GWP (‘Global Warming Potential’) est-il moins apte à corréler les émissions à des changements de température que le GTP (‘Global Temperature Potential’) ?

"La plupart des problèmes avec le GWP et le GTP ne sont pas intrinsèques aux métriques elles-mêmes, renchérissent les auteurs, mais à l’imposition d’une unique échelle de temps pour calculer la métrique"[34]. C’est pourquoi les auteurs ont proposé à Kyoto, au lieu d’utiliser uniquement un GWP100 à horizon 100 ans, d’utiliser un GWP25 (forçage radiatif sur 25 ans, par rapport à l’action d’une même quantité de CO2), et les impacts à horizon 50 ans, à l’aide d’un GWP50. Tout cela ne donne pas plus de fondement scientifique à un GWP100 qui n’en n’avait pas !

Les inventeurs de ces indices reconnaissent que « de nombreuses incertitudes subsistent. L'établissement d'un critère strict pour estimer l'incertitude globale dans les ODP calculés n'est pas une tâche simple. Il existe encore de nombreuses incertitudes associées au traitement des processus chimiques, radiatifs et dynamiques de l'atmosphère dans les modèles actuels. L'incertitude la plus importante est peut-être qu'aucun des modèles utilisés pour calculer les ODP n'inclut les processus chimiques et dynamiques à l'origine des pertes saisonnières d'ozone associées au trou d'ozone au-dessus de l'Antarctique » (rapport WMO 1989, § 4.34, p. 430)[34bis]. « Incertitude » ! On est en plein euphémisme quand, dans les programmes du secondaire, on enseigne déjà qu’un ratio n’est pas déterminable quand le dénominateur n’est pas déterminé. Or l’« identification des systèmes complexes » permet de considérer que le soleil est la principale cause des variations climatiques et qu’il n’est pas exclu que l’effet du CO2 soit nul. Dès lors comment fonder des calculs de GWP autour du CO2 ? Il en est de même pour l’élaboration d’un indicateur ODP. Dès lors que les variations de rayonnement cosmiques, ou de volcanismes n’ont jamais fait l’objet d’une véritable quantification par détection/attribution, toute élaboration d’un tel indicateur par rapport au CFC11 ne peut être que théorique.

b) Utilisation des indicateurs ODP et GWP

Les inventeurs de ces indicateurs ont réussi la performance d’entraîner tous les négociateurs et experts sur ce terrain sans chercher à en vérifier la crédibilité. Il n’empêche que des tableaux comparatifs des ODP et GWP seront diffusés partout, tant dans les instances de gouvernance que dans l’industrie.

Tous ces indicateurs n’ont pas plus de sens que toute une litanie d’autres indicateurs : ADP (Abiotic depletion potential), AETP (Aquatic ecotoxicity potential), AP (Freshwater acidification potential), CED (Cumulative energy demand), EP (Eutrophication potential), HTP (Human toxicity potential), POCP (Photochemical ozone creation potential), TETP (Terrestrial ecotoxicity potential), WD (Water demand). Ces outils évoquent des pollutions multiples, plus locales que planétaires, mais dont il ne faut pas lier l’existence. Malgré tout, les conditions locales sont trop différentes pour que ces indices aient un sens global. Ils sont probablement élaborés par une société civile qui rêve de réglementation, de normes à imposer pour créer, pense-t-elle, une "croissance dite verte".

c) La critique interdite sur ces indicateurs

L'un des inventeurs du test de QI se fit, dit-on, prendre à partie un jour sur la définition du QI. A chaque tentative de réponse, son interlocuteur lui montrait que les caractéristiques mesurées par ce test ne correspondaient pas à une véritable intelligence des choses. A la fin excédé, il répondit: "Vous voulez vraiment savoir ce que c'est que le QI? Hé bien c'est ce que mesure mon test". On n'est pas loin de cette boutade avec les paramètres d'ODP et GWP. Dans les deux acronymes, on trouve le "P" de "Potentiel". Dans un cas comme dans l'autre, on part d'hypothèses sur un mécanisme (de dégradation de l'ozone, ou de réchauffement climatique). Puis, on compare entre eux ce que seraient les effets de divers produits selon ces hypothèses. La démarche a l'avantage d'être cohérente, ce qui ne veut pas dire qu'elle corresponde à une réalité. Elle n'a que l'intérêt d'analyser les impacts potentiels de telle ou telle politique de restriction des produits incriminés. Dans ce sens, ces outils peuvent être utiles pour une application du principe politique de précaution, qui n'a rien à voir avec le principe de prudence. Cela nécessite de garder un regard critique sur la validité des hypothèses sous-jacentes, laquelle conditionne la validité de l'ensemble de la démarche. Là où le bât blesse, c'est que cette critique est interdite, et qu'on présente comme vérités révélées les hypothèses sous-jacentes.

Moralité: le serpent se mord la queue. Pour positiver, on peut se réjouir qu'il y ait, pour encore combien de temps?, dans ces acronymes le P de "Potential", et non le E de "Effect".

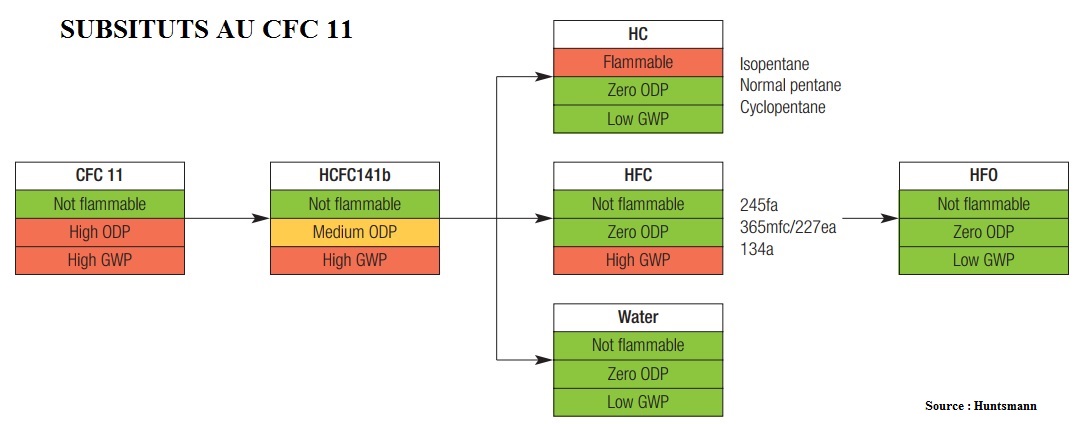

3.3- Le concept de panier d’ODS

Au fur et à mesure que les industriels proposent des substituts aux CFC, certains d’entre eux ne sont pas jugés anodins au regard de leurs prétendus ODP. On assiste, dès lors, à la mise en place vers 1989, d’une logique de paniers multiples[35]. Ce sont essentiellement Susan Solomon, John-S. Daniel, Mack McFarland et leurs collègues qui ont imaginé que chaque groupe de substances destructrices d’ozone (ODS), ou panier, devait être réglementé séparément.

Au fur et à mesure que les industriels proposent des substituts aux CFC, certains d’entre eux ne sont pas jugés anodins au regard de leurs prétendus ODP. On assiste, dès lors, à la mise en place vers 1989, d’une logique de paniers multiples[35]. Ce sont essentiellement Susan Solomon, John-S. Daniel, Mack McFarland et leurs collègues qui ont imaginé que chaque groupe de substances destructrices d’ozone (ODS), ou panier, devait être réglementé séparément.

- un premier panier regroupe les CFC (CFC-11, -12, -113, -114, et -115)

- le second panier se limite pour ainsi dire aux HCFC

- le troisième panier rassemble le tétrachlorure de carbone

- le quatrième panier se limite au méthylchloroforme

- le cinquième panier rassemble les divers halons dans un cinquième, etc. ..

Les divers halons ont probablement été mis en dernier car, il n’y a aucun substitut pour le Halons@R utilisé pour la lutte contre les incendies sur les aéronefs et les data-centers. Le tétrachlorure de carbone est considéré comme « artificiel », comme les CFC et est interdite en vertu du protocole de Montréal, alors que le tétrachlorure de carbone est émis par le gigatonne de volcans, sources hydrothermales et altération la biomasse (voir Gordon Gribble-Dartmouth).

Les négociations de réduction de production et de consommation ce font pour chaque panier, mais pas entre paniers[36].

Cette approche sera étendue aux gaz à effet de serre lors du protocole de Kyoto, mais en accordant plus de flexibilité aux GES que le protocole de Montréal n’en avait accordé aux émetteurs d’ODS.

Quand on sait le peu de fondement scientifique des ODS, on comprend qu’on est en plein concept politique voire commercial. D’ailleurs, les initiateurs de la méthode parlent de "choix trading"[37] ou de "cap-and-trade" pour les émetteurs d’ODP.

4- La controverse inhibée par l’administration américaine et la stratégie Dupont de Nemours

Les historiens parleront d’une forme d’armistice entre les parties. Ceci ne signifie pas, comme on va le voir, que les véritables arguments aient été étudiés en profondeur. Mais force est de constater que les controverses des années 75-80 vont s’éteindre assez naturellement pour plusieurs raisons.

4.1- L’amendement au Clean-Air Act de 1977

Le Clean Air Act (CAA) était une loi fédérale introduite en 1963 traitant de la pollution de l’air. L’amendement au Clean Air Act de 1977 décida d’interdire la vente sur le sol états-unien des produits contenant des CFC dans les secteurs de l’alimentation, des médicaments, des appareils ménagers et des produits cosmétiques (à l’exception des inhalateurs doseurs), puis l’arrêt de toute production manufacturée de propulseurs aérosols aux CFC dans le pays[38].

Pourtant l’amendement stipule que "la preuve empirique de la destruction de l’ozone n’était pas requise pour activer une action réglementaire". Cette loi n’a donc pas été fondée sur une preuve d’un lien entre la couche d’ozone et les CFC. Malgré tout, ce texte rendait un peu stérile la poursuite de la controverse

4.2- Le changement de stratégie de l’industrie américaine des CFC

L’étouffement de la critique scientifique sera également le résultat d’un changement graduel d’attitude de l’industrie des CFC qui finira par prend acte de l’inéluctabilité d’un abandon à court terme de tout CFC au vu de la mobilisation médiatique et politique pour la sauvegarde de la couche d’ozone au milieu des années 1980.

ar ailleurs, elle avait entamé, dès 1975 un processus de développement de substituts aux CFC (p 429). Les produits de substitution aux se devaient se vendre 15 fois plus chers que les CFC d’origine. Certains s’interrogent même sur le financement des ONG environnementales par des industriels : Edgar Bronfman, un des actionnaires principaux de Dupont de Nemours aurait fait de substantielles donations aux associations vertes aux États-Unis. Un des principaux héritiers de la famille ICI en Angleterre, Lord Peter Melchett, est directeur de Grenpeace dans ce pays[39].

Les industriels iront jusqu’à développer une recherche scientifique privée sur les impacts des CFC qui allaient plutôt dans le sens des experts internationaux.

En 1989, lorsque les substituts au CFC se développent et commencent à être, à leur tour suspectés d’être également nocifs, 15 industries productrices d’ODP utilisent la même stratégie en constituant un consortium « Alternative Fluorocarbon Environmental Acceptability Study » (AFEAS)[40]. Ce consortium produit une étude sur les dangers des substituts. Leur souci est, à l’évidence, de ne pas reproduire leur erreur antérieure, mais de générer une plus grande confiance des industriels dans la théorie de la destruction anthropique de l’ozone. Ils ont compris, par ailleurs, que c’était une stratégie efficace pour gagner la bataille mondiale de la production de substituts à « pouvoirs de destruction » (ODP) faibles.

Cette confiance amène d’ailleurs les États-Unis à souhaiter "harmoniser" par le haut les réglementations des CFC. Ils veulent amener Allemands, Français, Britanniques, Japonais, Soviétiques, etc. à s’aligner sur les objectifs de réductions nord-américains. Or, il faudra pour cela que l’expertise de l’ozone se présente comme une science "universelle", "neutre", et non une science nord-américaine. Des scientifiques de certains pays sont donc invités aux ‘Workshops’ bien que les américains savent très bien que leur contribution sera marginale. On espère qu’ils pourront mobiliser leurs pays sur l’ozone, « adoucir les préjugés nationalistes » et servir d’ambassadeurs. Il s’agit, d’autre, de créer un sentiment d’appartenance à une élite, autour de la rédaction d’un grand rapport international soutenu par l’ONU. Des rencontres scientifiques internationales sur l’ozone qui se déroulent de manière ritualisée à partir de 1976-77 ont une fonction sociale évidente. Elles sont financées par l’ONU ou même parfois par la NASA elle-même.

4.3- La création de l’UNEP

Une nouvelle institution de l’ONU, le Programme des Nations unies pour l’Environnement (UNEP) est créé le 15.12.1972. En mal de reconnaissance, l’UNEP organise, à Washington en mars 1977, la première grande rencontre transnationale et "hybride" sur la couche d’ozone.

Il s’agit, non seulement d’aboutir à une standardisation accrue des instruments de mesures, mais également de "standardiser", d’homogénéiser, de faire converger les savoirs sur l’ozone. Ce but est imparfaitement atteint. A la fin des années 1970 et au début des années 1980, les projections de destruction anthropique d’ozone à l’aide de modèles numériques donnent des résultats souvent difficilement conciliables. Il en va de même au sujet des mesures spectroscopiques d’ozone (au sol, depuis l’espace). Tous ces ‘Workshops’ internationaux génèrent un sentiment d’appartenance à une communauté internationale et "écologique".

Les américains attirent des scientifiques aux ‘Workshops’ en faisant ressortir leur valeur professionnelle, déclarant que « les meilleurs scientifiques du monde s’y trouveraient »[41], et que ces rencontres donneraient naissance à "un document dont ils pourraient tous être fiers". L’aspect vertueux d’un travail contribuant à la protection de l’environnement est bien sûr mis en avant et contribue à la procédure de consensus. Tout cela ne laisse plus de place au dissensus.

4.4- Le monopole américain des mesures satellitaires

L’avantage pris par la recherche états-unienne est patent : d’abord, en matière de développement des modèles numériques, qui impliquent de posséder des ordinateurs puissants, que l’on trouve notamment au LLNL et au NCAR ; ensuite et surtout, sur un plan instrumental, puisque la recherche états-unienne se trouve en capacité de déployer des technologies multiples, dont les plus coûteuses, pour mesurer par satellite les paramètres importants dans la science de l’ozone. Tout cela ne facilite pas l’émergence d’équipes pour contester les travaux de la NASA et de la NOAA.

4.5- La fuite des « cerveaux » de l’ozone vers le GIEC

Au cours des années 1970-80, des chimistes de l’ozone se familiarisent avec la problématique du changement climatique. Lorsque le GIEC sera constitué, en 1988, certains d’entre eux, comme Susan Solomon, Robert Watson et Donald Wuebbles vont compter parmi les auteurs du premier rapport AR1 du GIEC.

D’autres scientifiques de l’ozone, révélés par l’expertise "à succès" de l’ozone, surent mettre à profit la nouvelle force qui était la leur, pour proposer des voies politiques à suivre en matière de réductions de GES, de géo-ingénierie, de pollution dans les villes, d’environnement global. C’est le cas de Paul Crutzen, de Mario Molina, de Susan Solomon, de Ralph Cicerone, ou encore de Michael McElroy.

Les rares experts qui contestent les modèles sur l’Ozone se retrouvent isolés et s’emploieront à utiliser leurs compétences pour contester l’inefficacité des modèles sur l’effet des Gaz à effet de Serre.

D’une certaine manière, le combat cessa faute de combattants. Cela ne servait pas vraiment l’émergence de la vérité scientifique sur les causes de variations de la couche d’ozone.

4.6- La signature des accords internationaux

Les controverses scientifiques au sujet de la destruction anthropique de l’ozone stratosphérique s’apaisent au début des années 1990. Jugeant que la gouvernance de l’ozone a été actée, en Occident, les médias, les « marchands de doute » et les scientifiques de l’atmosphère s’intéresseront de moins en moins à l’ozone et s'orienteront, faute de budgets, vers des études sur le changement climatique. Cela ne facilitait pas la poursuite de la controverse.

5- Un temps de prises de décisions politiques

5.1- Décisions politiques fondées sur des approximations

- Même dans le grand rapport international mis en place par la Convention de Vienne sur l’Ozone, WMO/UNEP/…, 1985, on pouvait lire que « aucune tendance "statistiquement significative" ne peut être dégagée des mesures par spectrophotomètres Dobson au sol dans la période 1970-1983, ni des mesures par ballons-sondes, ni des satellites. la menace d’une destruction (globale) d’ozone repose alors sur des modélisations numériques utilisant notamment l’hypothèse de Molina et Rowland. Par contre, ajoutent les experts internationaux, une preuve récente a été présentée, qui indiquait une diminution considérable de la colonne d’ozone antarctique printanière depuis 1968 ».

Il est symptomatique de voir que, même après que la signature de la convention de Genève sur l’ozone, qui prenait donc des décisions politiques en la matière, les rapports officiels reconnaissaient l’absence (WMO/UNEP, 1985)[42], de "tendance statistiquement significative". Ces rapports qualifient de simple "hypothèse" les travaux de Molina et Rowland. C’est pourquoi ils ont recours à "une preuve récente a été présentée, qui indiquait une diminution considérable de la colonne d’ozone". Or un tel recours à l’observation des conséquences (épaisseur de la couche d’ozone) ne dit rien de la cause (CFC ou rayons cosmiques)

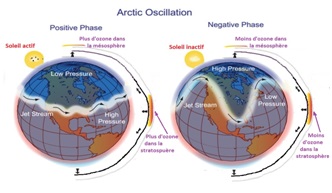

- Seuls les modèles post-1985 calculeront les destructions dites du trou d’ozone, aux pôles, mais également des destructions jugées beaucoup moins rapides, au niveau des moyennes et basses latitudes. Or, ce n’est que dans les années 2010 que Stephen Wilde constatera, parallèlement aux Oscillations Arctiques (AO) du Jet Stream, des oscillations de teneur en ozone en haute altitude au niveau de l’équateur et d’expliquer cette variation en fonction de l’activité solaire : quand le soleil est actif, on constate une phase positive de l’ozone stratosphérique à l’équateur et l’inverse en phase solaire inactive[43].

- Seuls les modèles post-1985 calculeront les destructions dites du trou d’ozone, aux pôles, mais également des destructions jugées beaucoup moins rapides, au niveau des moyennes et basses latitudes. Or, ce n’est que dans les années 2010 que Stephen Wilde constatera, parallèlement aux Oscillations Arctiques (AO) du Jet Stream, des oscillations de teneur en ozone en haute altitude au niveau de l’équateur et d’expliquer cette variation en fonction de l’activité solaire : quand le soleil est actif, on constate une phase positive de l’ozone stratosphérique à l’équateur et l’inverse en phase solaire inactive[43].

5.2- La Convention de Vienne

Elle est signée le 16.9.1987. Ses organes scientifiques sont essentiellement américains : le CIAP[44] et la NAS (National Academy of Sciences)

5.3- Le protocole de Montréal

Le "Protocole de Montréal relatif à des substances qui appauvrissent la couche d'ozone" est signé le 22.3.1985. Cette signature et celle de ses amendements ne se fit pas dans le contexte idéal qui a souvent été dépeint, mais toujours dans un climat de controverse scientifique.

5.4- La mise en place d’organes de gouvernance

Les groupes d’évaluation furent les piliers du régime de protection de l’ozone dès le début de la mise en œuvre du Protocole de Montréal :

A partir de 1989, les groupes d’experts internationaux soutenus par l’ONU prendront leur forme définitive, en trois groupes :

- Le Scientific Assessment Panel (SAP), en français Groupe de l’évaluation scientifique (GES). Il mesure l’appauvrissement de la couche d’ozone et passe en revue les questions dont il y a lieu de tenir compte du point de vue des sciences de l’atmosphère. Il publie les ‘Scientific Assessments of Ozone Depletion’

- L’Environmental Effects Assessment Panel (EEAP), en français Groupe de l’évaluation des effets sur l’environnement (GEEE), évalue les effets divers de l’appauvrissement de la couche d’ozone

- Le Technology and Economic Assessment Panel (TEAP), en français, Groupe de l’évaluation technique et économique (GETE).

Il est l’organe consultatif des Parties au Protocole de Montréal pour les questions techniques et économiques. Il produit des rapports annuels.

Le Groupe fonctionne à l’aide de six Technical Options Committees (TOCs), en français Comités des choix techniques (CCT) :

- le Comité des choix techniques pour les produits chimiques, (CTOC)

- le Comité des choix techniques pour les mousses souples et rigides, (FTOC)

- le Comité des choix techniques pour les halons, (HTOC)

- le Comité des choix techniques pour les produits médicaux, (MTOC)

- le Comité des choix techniques pour le bromure de méthyle (MBTOC)

- et le Comité des choix techniques pour la réfrigération, la climatisation et les pompes à chaleur (RTOC)

5.5- Une gouvernance érigée comme une « référence » pour le climat

En 1988, l’OMM et l’ONU décide de constituer le GIEC. Dès lors, la chimie atmosphérique a intégré les rapports du GIEC

La gouvernance de Montréal est immédiatement recopiée pour le GIEC :

- Le GIEC est lui aussi composé de trois groupes : un groupe "scientifique" (‘Working Group I’), un groupe sur les "impacts, l’adaptation et la vulnérabilité" (‘Working Group II’) et un groupe sur les moyens d’ "atténuer" le changement climatique (‘Working Group III’).

- On parle de Gaz à effet de Serre (GES, comme on parlait des composés destructeurs d’ozone (ODS, ‘Ozone Depleting Substances’)

- Les trois groupes d’experts du GIEC rédigeront des rapports, publiés conjointement tous les sept ans (AR1 1990, AR2 1995, AR3 2001, AR4 2007, AR5 2014), de la même manière que les rapports « Assessments of Ozone Depletion » étaient publiés régulièrement (NASA/UNEP/WMO/…, 1985; WMO/…, 1989; WMO/…, 1992; WMO/…, 1994; WMO/…, 1999; WMO/…, 2003; WMO/…, 2007; WMO/…, 2010)[45]

- Comme on l’a vu, l’indice ODP (‘Ozone Depletion Potential’), a servi de modèle au GWP (‘Global Warming Potential’)

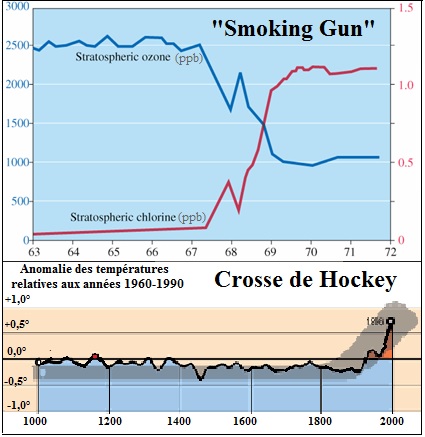

- On vit même la mise en place similaire de courbes induisant le sentiment d’urgence : la courbe en "crosse de hockey", de la même manière qu’il y avait eu la courbe dite en forme de "pistolet qui fume (‘smoking gun’)"[46] établie en 1989 par Anderson.

- On vit même la mise en place similaire de courbes induisant le sentiment d’urgence : la courbe en "crosse de hockey", de la même manière qu’il y avait eu la courbe dite en forme de "pistolet qui fume (‘smoking gun’)"[46] établie en 1989 par Anderson.

La courbe "smoking gun", faisait allusion à l’expression anglo-saxonne qui évoque le pistolet fumant comme étant l’élément essentiel “qui prouve un crime”. Mais cette courbe n’apporte aucune preuvePerpetrators of financial crimes have a reputation of destroying paperwork because doing so reduces the possibility that authorities will find a smoking gun. puisqu’elle ne donne pas les teneurs en Ozone et en ClO, échelonnées dans le temps, mais ne rapporte que des résultats de détection géographique. On voit que leurs auteurs voulaient évoquer l’idée d’un “crime“ contre l’ozone.

Quant à la courbe en cross de Hockey, proposée en 1998 par le climatologue américain Michael E. Mann, elle fut complètement discréditée par le GIEC lui-même.

- Le GIEC mit en place les mêmes réunions périodiques que celles des organes de Montréal : les MOP (‘Meeting of the parties’), les "forums hybrides", lieux de négociations entre signataires de Conventions internationales ; les COP (‘Conference of the parties’).

6- Le Prix Nobel : une science inexacte !

Mario-José Molina[47], Paul-Josef Crutzen et Frank-Sherwood Rowland, se sont vus attribué, en 1995, le Prix Nobel de Chimie "pour leurs travaux sur la chimie de l'atmosphère, particulièrement en ce qui concerne la formation et la décomposition de l'ozone".

Il s’agit là d’une consécration sociale, mais qui aurait du laisser la porte ouverte à la poursuite du débat. En effet, un prix Nobel n’est pas une preuve. Plusieurs exemples le démontrent.

- Les historiens des sciences citent volontiers le cas de l'Espagnol Santiago Ramon y Cajal à qui fut attribué le Prix Nobel de médecine en 1906 pour ses travaux sur "l'existence des neurones et la structure du système nerveux". De cette date est né un dogme que l'on a longtemps cru intangible : le cerveau s'apparentait à une superbe machine, avec des zones parfaitement câblées entre elles. Une fois arrivé à maturité, on ne pouvait plus y toucher et, si l'une de ses parties était détruite, il n'y avait plus rien à faire. Progressivement, ce prix Nobel s’est fait contredire avec les découvertes ultérieures sur l’extraordinaire élasticité du cerveau et sa capacité à régénérer des neurones.

- En 1926, le prix Nobel est attribué au danois Johannes Fibiger pour la découverte de Spiroptera carcinoma, un ver nématode sensé être capable de provoquer le cancer. On le sait aujourd’hui, il s’agissait d’une erreur intégrale.

- En 1938, le chercheur italien Enrico Fermi obtint la distinction suprême de physique pour sa découverte de nouveaux éléments radioactifs, dont les numéros d’ordre sont 93 et 94. Mais, plusieurs mois plus tard, des scientifiques répétant ses test réalisent que l'italien n'avait créé aucun nouveau produit.

Un autre prix Nobel Derek Barton a même déclaré, à propos de l’ozone : "Il y a tant de propagande médiatique autour du trou d'ozone, que j'en deviens sceptique"[48].

Le Monde a eu raison de titrer en 2017: "Le prix Nobel, science inexacte"[49].

7- La remise en cause de l’origine anthropique du « trou d’ozone »

7.1- Les mécanismes de la biosphère

a- Le rôle des composés azotés

Dès le début des années 1970, Crutzen avait démontré pour la première fois que les transformations microbiologiques dans le sol affectaient directement l'épaisseur de la couche d'ozone, dans la stratosphère, à 30 km au-dessus de la Terre[50]. L'oxyde nitreux, N2O, est produit dans le sol par activité biologique et pourrait atteindre la stratosphère. Sous l'action de la lumière du soleil, il se désintégrerait alors pour former les oxydes d'azote NO et NO2. Ces oxydes d'azote réagiraient alors eux-mêmes avec l'ozone stratosphérique (O3). Ils le feraient de manière catalytique, ce qui signifierait que même s'ils appauvrissent la quantité d'ozone, ils seraient eux-mêmes inchangés par la réaction et chaque molécule d'oxyde d'azote pourrait donc éliminer de nombreuses molécules d'ozone.

b- Les composés halogénés naturels

Il est faux d’affirmer qu’il n'y a pas de source naturelle de composés halogénés organiques. Il est maintenant admis par tout le monde que la principale source de bromure de méthyle, composé halogéné jugé pouvoir être encore plus dangereux pour la couche d'ozone que les CFC, est l'océan qui produit aussi de grandes quantités de chlorure de méthyle ainsi que du chloroforme, du trichloréthylène et du tétra-chlor-éthylène[51]. Le rapport officiel de 1994 du protocole de Montréal reconnait d’ailleurs que « le bromure de méthyle continue d'être considéré comme un important composé appauvrissant la couche d'ozone…. il existe des incertitudes significatives dans la quantification du puits océanique pour le bromure de méthyle atmosphérique ». (WMO 1994, résumé pour les décideurs, p xv)

Le CO2 et le méthane participent également à la chimie de l'ozone et une étude de 1983 a montré que ces gaz contribuent à la génération de l'ozone[52]. Ces auteurs montrent également que si l'ozone est détruit dans les couches supérieures de la stratosphère, les rayons UV-B peuvent pénétrer dans les couches plus basses où toutes les conditions sont requises pour une génération massive d'ozone. Le système se maintiendrait de cette façon en équilibre. Des mesures ont été faites par des avions de ligne circulant dans la troposphère qui montrent que la concentration de l'ozone à des altitudes de 10 à 12 kilomètres est extrêmement variable et qu'elle est sans doute due à des échanges massifs entre troposphère et stratosphère. C'est surtout dans la troposphère au-dessus des tropiques qu'on a trouvé ces concentrations extrêmement élevées[53]. Les éclairs des orages génèrent par année 10 à 15 millions de tonnes de NOx et c'est particulièrement dans les tropiques que ce gaz peut participer à la production d'ozone[54].

Il faudrait vérifier s'il existe des comparaisons entre les quantités naturellement émises de ces produits (pondérées par leur "ODP"), avec l’équivalent d’émissions anthropiques. Certains articles évoquent:

* les émissions naturelles[55] .

* les émissions anthropiques : rapports du Protocole de Montréal

* les valeurs des "ODP"[56].

Si les émissions naturelles pondérées sont largement supérieures aux émissions anthropiques, ce ne serait pas, pour autant, une preuve de déséquilibre planétaire. Il existe, au niveau planétaire, de multiples, cycles et de boucles de réactions internes à l'origine de corrections de toutes sortes de déséquilibres planétaires. La planète aurait-elle une résilience plus considérable qu’on ne l’imagine ?

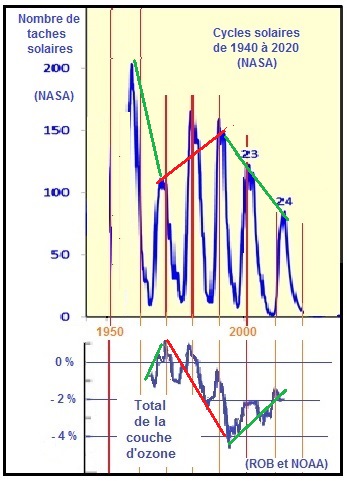

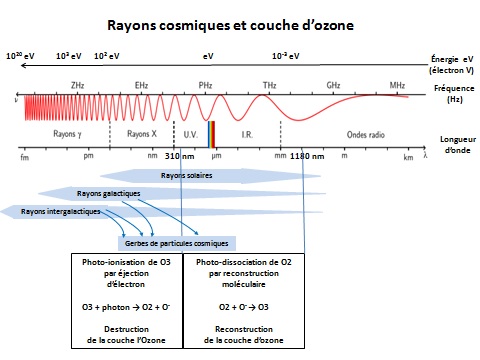

7.2- Le rôle des rayons cosmiques sur la couche d’ozone

Les modèles d’ozone sous-estiment l’influence du cycle solaire sur l’ozone. Labitzke et van Loon [56.1] « suggèrent que l’on trouve une semblable sous-estimation dans le rapport de l’OMM [1990] sur l’ozone Stratospherique ».

Chandra et McPeters [56.2]montrent que ces modèles, pourtant classiques, sous –estiment l’influence du cycle solaire d’un facteur deux ou trois. Hood et al. [56.3] étaient parvenus à des résultats similaires.

D'ailleurs, un « rapport financé par l’OMM, l’UNEP, la NASA, la NOAA et le ministère anglais de l’environnement, et rédigé par « 65 experts internationaux » avec le concours de 144 spécialistes [56.4]» a été publié en décembre 1991 alors que les protocoles de Londres (1987) et de Londres (1990) avaient été adoptés… Il représente donc fidèlement la base « scientifique » sur llaquelle ces traités ont été signés. Le rapport mentionne l’influence du cycle solaire [56.5], … et tire une conclusion surprenante : « On ne peut rendre entièrement compte de la tendance à la baisse de l’ozone global. … Les scénarios retenus dans les modèles n’incluent qu’un seul forçage : les modifications de la composition atmosphérique, qui a été dominée pendant la dernière décennie par l’augmentation du chlore provenant des halocarbones… » [56.6].

a- Les travaux de Professeur Canadien Qin-Bin Lu

Qin-Bin Lu, professeur de physique et d'astronomie à l'Université de Waterloo au Canada (Ontario), pense également que le trou de l'ozone doit tout ou presque, aux rayons cosmiques[57]. Dans une étude, parue dans la revue" Physical Review letters"[58] du 20.3.2009, il s’appuie sur des données satellitaires fiables couvrant la période 1980-2007 couvrant deux cycles complets de rayons cosmiques de 11 ans. Il montre clairement la corrélation entre les rayons cosmiques et l'appauvrissement de l'ozone, en particulier sur l'Antarctique.

Qin-Bin Lu, professeur de physique et d'astronomie à l'Université de Waterloo au Canada (Ontario), pense également que le trou de l'ozone doit tout ou presque, aux rayons cosmiques[57]. Dans une étude, parue dans la revue" Physical Review letters"[58] du 20.3.2009, il s’appuie sur des données satellitaires fiables couvrant la période 1980-2007 couvrant deux cycles complets de rayons cosmiques de 11 ans. Il montre clairement la corrélation entre les rayons cosmiques et l'appauvrissement de l'ozone, en particulier sur l'Antarctique.

« Cette conclusion va en contradiction avec la théorie photochimique largement acceptée », a déclaré Qin-Bin Lu.

Les recherches de Qin-BinLu sont financées par les instituts de recherche en santé du Canada (IRSC) et le Conseil Canadien de sciences naturelles et de recherche en génie (CRSNG).

b- Les travaux de la NASA

Un article publié par la PNUE/OMM[59] fait état d’une courbe qui prouverait que "La couche d’Ozone est en voie de guérison" à l’horizon 2040-2080. Curieusement, l’étude n’explique pas les variations de la période 1960-2000 qui, de manière flagrante, sont corrélées aux cycles de 10 ans du soleil. Cette courbe confirme la référence de Qin-Bin Lu à un minimum d’ozone en 2009.

Un article publié par la PNUE/OMM[59] fait état d’une courbe qui prouverait que "La couche d’Ozone est en voie de guérison" à l’horizon 2040-2080. Curieusement, l’étude n’explique pas les variations de la période 1960-2000 qui, de manière flagrante, sont corrélées aux cycles de 10 ans du soleil. Cette courbe confirme la référence de Qin-Bin Lu à un minimum d’ozone en 2009.

Or, la Nasa explique[60] qu’un rapport du CNRC (Conseil National de Recherches du Canada), financé en particulier par "NASA’s Living with a Star Program", avait réuni des dizaines d’experts de nombreuses disciplines lors d’un atelier unique. Un des participants, Greg Kopp, du Laboratoire atmosphérique et physique de l’espace à l’Université du Colorado, avait fait observer que les rayonnements solaire dans la bande des UV varie de 10%, lors des cycles de 11 ans, contre environ 0.1% dans l’ensemble du spectre. Ceci peut fortement affecter la chimie et la structure de la structure thermique de l’atmosphère supérieure. Rube-Goldberg expliquait que ce n’est pas parce que quelque chose est compliqué que cela signifie que ce n’est pas vrai.

c) Les travaux de B. Soukharev de l’Université de St-Petersbourg

B.Soukharev[61] de l'Université de St.Pétersbourg ne trouve pas non plus de diminution de la concentration d'ozone stratosphérique au-dessus de la Russie. Le cycle des tâches solaires joue un rôle majeur les variations de concentration annuelles et décennales.

d) Les travaux du WCRP

Le programme mondial de recherche sur le climat (WCRP), a mené un projet scientifique dénommé SPARC (Stratosphere-troposphere Processes and their Role on the Climate), Il conclut qu’un Soleil actif augmente l'ozone dans la stratosphère: "Les variations de l'irradiance spectrale ultraviolette solaire modifient directement le taux de production de l'ozone dans la stratosphère supérieure[62] et il est donc raisonnable de s'attendre à une variation de la quantité d'ozone en fonction du cycle solaire. Les enregistrements mondiaux d'ozone par satellite depuis 1979 montrent des signes d'oscillation décennale de l'ozone total avec une amplitude maximale (~ 2%) aux basses latitudes"[63].

e) Les publications de Stephen Wilde

Jeanne Nova, est une rédactrice scientifique enseignant à l’université nationale australienne. Le 2 janvier 2015, elle a mis en ligne un article vulgarisant l’impact du soleil à la fois sur l’ozone et sur le climat. Elle s’appuie sur des publications de Stephen Wilde, membre de la Royal Meteorological Society.

La théorie solaire du délai de rajustement (Notch-Delay)[64] de David Evans est que le TSI est un indicateur avancé, et après que les taches solaires auront atteint un pic, les températures sur Terre suivront avec un pic d’environ 11 ans (ou un cycle solaire). Mais quel est ce mécanisme ? Stephen Wilde a une théorie. Suivons la chaîne de causalités potentielles qu’il propose:

Soleil → UV ou particules chargées → ozone → courants polaires → nuages → températures de surface.

Stephen Wilde a présenté la première version de cette hypothèse en 2010.[65]

f) Les travaux de J.K. Angell (NOAA) en 1989

Dans une publication de juin 1989, il présente un parallèle frappant entrele nombre de taches solaires et l'ozone global. La figure ci-contre montre une baisse sensible de l'ozone au début des 1960, période pendant laquelle les CFC étaient encore peu utilisés.

Dès 1962, Willet avait déjà remarqué « une corrélation négative très significative entre le nombre de tâches solaires et la moyenne mondiale de l’ozone total » [65bis].

g) Une reconnaissance des faits par les organes du protocole de Montréal

Dix ans après l’adoption du protocole de Montréal, un rapport officiel de son organe de gouvernance a d’ailleurs reconnu l’impact des variations de rayons UV : « Des augmentations locales des UV-B ont été mesurées en 1992/93 aux latitudes moyennes et élevées de l'hémisphère Nord. Les signatures spectrales des améliorations impliquent clairement l'ozone anormalement bas observé au cours de ces années, plutôt que la variabilité de la couverture nuageuse ou de la pollution troposphérique. De telles corrélations renforcent la capacité de lier les changements d'ozone aux changements d'UV-B sur des échelles de temps relativement longues » (Rapport WMO 1994, résumé pour décideurs, p. xx). C’est confirmé dans le cœur du rapport : « Les variations du flux ultraviolet solaire (UV) peuvent affecter les quantités et profils d'ozone de la colonne, les changements les plus importants se produisant dans la haute stratosphère (Hood et al., 1993, Brasseur, 1993, Fleming et al., 1994). » (Rapport WMO 1994, § 4.16, p.210). Mais aucune conclusion pratique n’a été tirée de ces observations. Y a-t-il une réelle volonté de comprendre ? Dans le rapport de 2010, tout un chapitre est consacré à l’hypothèse solaire, mais la conclusion est « L'origine d'une telle réponse dynamique au cycle solaire n'est pas totalement comprise » (rapport WMO 2010, § 2.4.3.2).

h) La confusion entre cause et conséquence

Dans toute approche d’identification d’un système complexe comme celui des mécanismes stratosphériques en matière d’ozone, il convient de ne jamais confondre les causes et les conséquences.

Dans toute approche d’identification d’un système complexe comme celui des mécanismes stratosphériques en matière d’ozone, il convient de ne jamais confondre les causes et les conséquences.

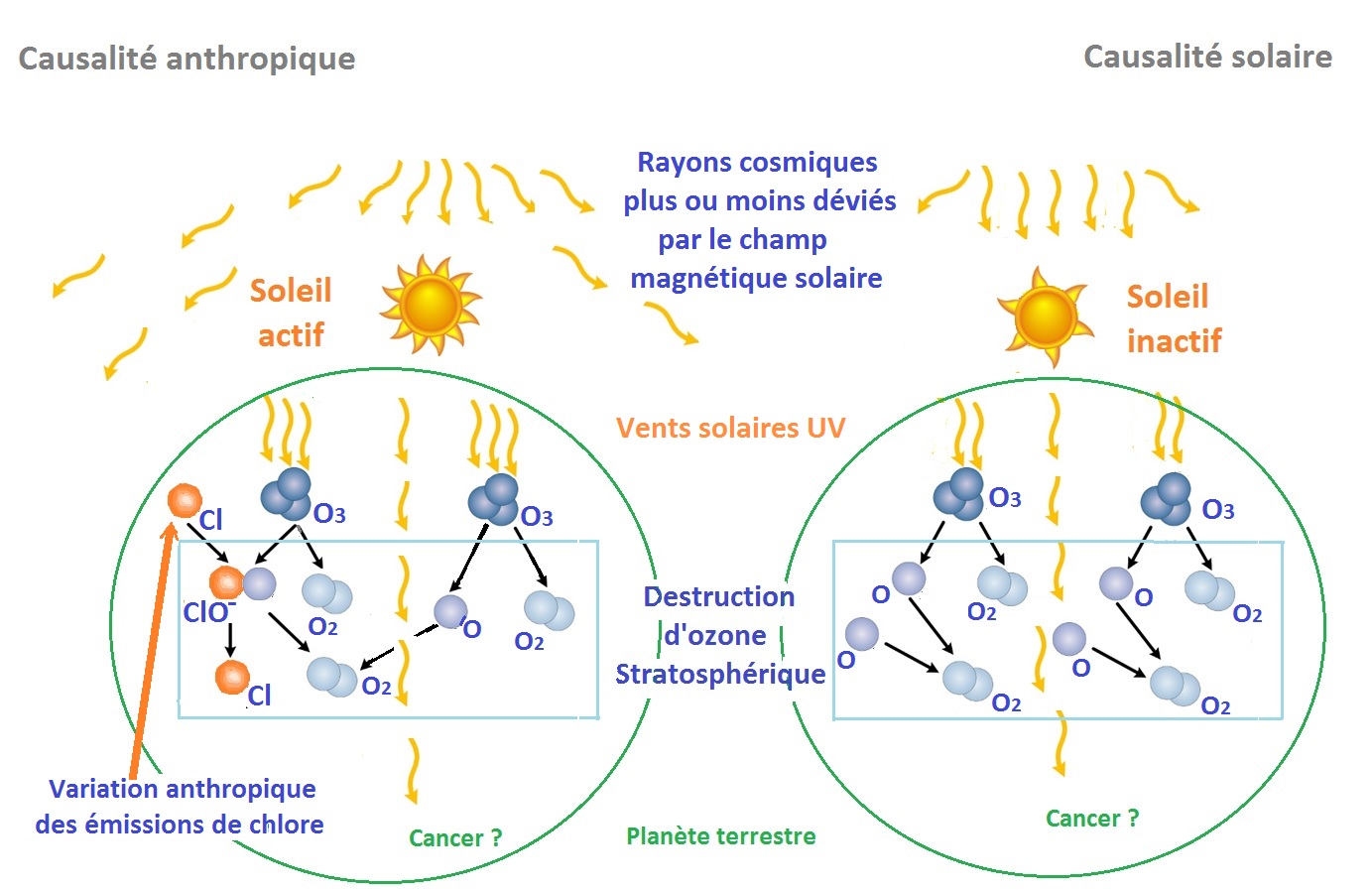

- Dans l’hypothèse d’une causalité anthropique de la destruction de l’ozone que Mario-José Molina et Frank-Sherwood Rowland ont imaginé, les produits chlorés émis par l’homme entreraient en réaction chimique avec l’ozone qui se disloquerait en oxygène. Dès lors, Molina énonçait le risque que les quantités d’ozone soient, dès lors, insuffisantes pour protéger l’homme des effets cancérigènes des rayons UV.

Pour entrer dans le détail de cette hypothèse, il faut comprendre que l’énergie des UV est suffisamment élevée pour provoquer une dislocation des liaisons moléculaires et le transformer en ozone. C’est précisément cette destruction qui réduit la pénétration des UV à travers la stratosphère.

- Dès lors, on peut comprendre une causalité solaire, et non anthropique : plus le soleil est actif, plus son champ magnétique dévie les rayons cosmiques, denses en UV, en les éloignant du champ terrestre. Mais en même temps, les vents solaires augmentent avec l’activité solaire. Dès lors, la destruction de l’ozone sera différente de ce qu’elle serait quand le soleil est moins actif.

C’est donc bien la forte destruction d’ozone qui, en fonction de l’activité solaire, protège l’homme des effets des UV, et non l’homme qui détruisant la couche d’ozone rendrait l’homme vulnérable aux effets des UV. Quand on confond les causes et les conséquences, on occulte l’idée que le bombardement de la terre par les UV cosmiques et des vents solaires n’est pas constant.

i) Le rôle des longueurs d'ondes des UV sur l'Ozone

L'ozone se forme dans la stratosphère à une altitude supérieure à 30 km où le rayonnement UV d'une longueur d'onde inférieure à 240 nm dissocie lentement l'oxygène: O2 + UV → O- + O- + KE (KE est l'énergie cinétique). La présence d'autres radicaux chimiques R peut favoriser la formation d'ozone:

O- + O2 + M → O3 + M + VE. (VE est l'énergie de résonance, c'est à dire la quantité d'énergie nécessaire pour la stabilisation de la molécule).

En haut de la stratosphère, l'air peut atteindre des températures proches de O°C. Cette élévation de température est provoquée par l'absorption des rayons UV du soleil.

C'est sous l'impact d'UV de longueurs d'ondes supérieures, de 240 à 320 nm, que l'ozone peut être dissocié:

O3 + UV → O2 + O-+ KE . L'ozone peut également réagir avec l'atome d'oxygène pour redonner de l'oxygène O3 + O- → O2 + O2 + KE .

La quantité d'ozone dans la stratosphère résulte donc d'un équilibre complexe entre formation et destruction naturelles

7.3- Le rôle des volcans

Le célèbre vulcanologue, Haroun Tazief, écrivait[66] : "Je me demande si l'on n'accuse pas les CFC de détruire la couche d'ozone pour des raisons plus économiques, qu'écologiques. Car il y a énormément d'argent à gagner. Mais les sommes investies dans des batailles gigantesques contre des pollutions imaginaires ne sont plus disponibles pour lutter contre des pollutions réelles"[67].

On sait que les volcans émettent des CFC mais aussi de grandes quantités d’acide fluorhydrique (HF), l’acide chlorhydrique (HCl) et acide hydrodrobromic (HBr) qui transportent jusqu'à la stratosphère. (Ian Plimer, et al.).

Or, on a mis en évidence des "trous d’ozone" dans la troposphère au dessus du volcan du Spitzbergen et aux alentours de la Sibérie[68].

On peut citer d'autres cas:

- Le volcan antarctique Erebus, en éruption permanente depuis 1972, émet plus de 1.000 tonnes de gaz chlorhydrique par jour et ce gaz reste dans l'air parce qu'il n'y a pas de pluies pour le ramener par terre.

- Pourquoi avoir si peu parlé de l'éruption du mont Hudson au Chili en août 1991 alors qu'elle contribuait manifestement à la formation du trou d'ozone d'octobre 1991[69] ? La "réparation" du trou s'ozone serait-elle liée à l'atténuation de l'activité de ce volcan?

Les dernières 15 années ont été caractérisées par une série d'éruptions volcaniques exceptionnelles.

- On estime qu'en 1982 l'éruption de El Chichón en 1982 a causé une réduction de l'ozone de 1 à 2 %, et même de 7 % à 24 km d'altitude[70].

L'éruption du Pinatubo aux Philippines en 1991 est la plus forte éruption enregistrée au XXe siècle de par la quantité d'aérosols stratosphériques produite. Le sommet du nuage a atteint une altitude de 40 km.

Le volcan de l'île de Satsuma Iwojima, au sud du Japon déverse, lui aussi, chaque jour dans l'atmosphère quelque 135 T/jour de chlore. Les augmentations de chlore dans la stratosphère au cours des dernières 20 années pourraient en grande partie être expliquées par ces éruptions.

Le dernier rapport officiel de l’accord de Montréal sait tout cela et reconnait que « les mécanismes de ces changements sont qualitativement compris, mais certaines incertitudes demeurent quant à leur quantification » (Rapport WMO 2010, prologue, p. xwiii). Ce n'est pas étonnant étant donné que le rapport ne pratique aucune quantification comparée des divers impacts éventuels comme pourrait le faire un traitement "par identification".

7.4- Le rôle de l'activité géomagnétique terrestre