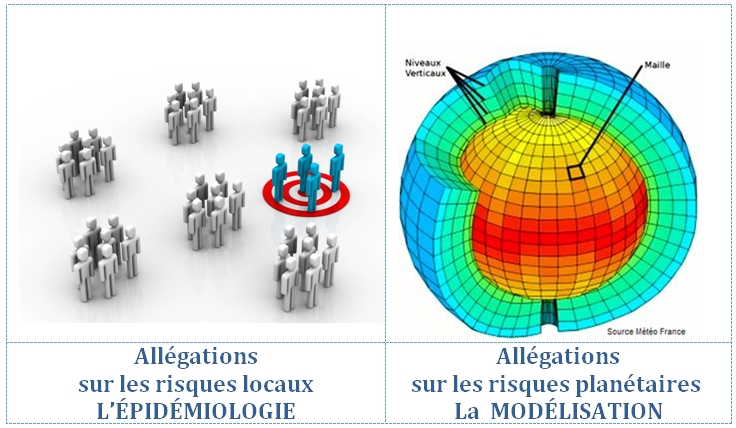

Dans de nombreux articles de ce blog, nous mettons en garde sur les fausses allégations santé concernant des problématiques environnementales locales, et sur les graves erreurs des modèles attribuant à l’homme les pollutions planétaires telles que le réchauffement climatique ou le trou d’ozone.

Dans de nombreux articles de ce blog, nous mettons en garde sur les fausses allégations santé concernant des problématiques environnementales locales, et sur les graves erreurs des modèles attribuant à l’homme les pollutions planétaires telles que le réchauffement climatique ou le trou d’ozone.

Nous considérons comme un acquit nos arguments. Il n’est pas inutile de rappeler ici sur quoi nous nous fondons.

Analyse: "les2ailes.com"

Notre réflexion s'articule de la manière suivante:

En quoi les risques environnementaux sont-ils-avérés ?

1- Les risques sur l’environnement local

Les risques de type accidentel

Les risques allégués et fondés sur des études épidémiologiques.

2- Les risques sur l’environnement planétaire

Réflexions d’ordre méthodologique.

Réflexions méthodologique sur le système climatique planétaire.

3- Conclusion

1- Les risques sur l’environnement local

Les risques de type accidentels

Il ne s’agit pas de nier que les activités des entreprises puissent avoir des impacts sur l’environnement.

Les exemples sont multiples dans le passé : Seveso, Bophal, Tchernobyl, Fukushima.

La mise en place de normes, dites Seveso, pesant sur les entreprises pour réduire la probabilité de ces types d’accidents n’ont malheureusement pas supprimé des risques qui relèvent, par nature, de toute activité humaine. L’exemple de l’incendie survenu en octobre 2019 à l’usine de Lubrizol de Rouen a montré que le nuage de fumées avait eu des répercussions sur plus de 200 communes et 2000 agriculteurs. L’incendie du 3 juillet 2019 à l’usine Seine Aval du SIAAP à Achères, bien que beaucoup moins médiatisé, a eu des effets environnementaux peut-être plus graves encore.

Les risques allégués et fondés sur des études épidémiologiques.

Tout ce qui relève des risques alimentaires, des risques liés aux émissions hertziennes, à l’usage de pesticides en agriculture, sont des problématiques difficiles à évaluer.

Selon la gravité des enjeux, on peut avoir recours à plusieurs niveaux de méthodologie :

L’expérience a montré, par exemple, qu’on ne peut tirer des conclusions scientifiquement fiables d’une enquête auprès d’habitants dans le voisinage d’émetteurs de téléphonie.

Ce n’est pas une étude scientifique mais simplement un recensement d’études. Celle publiée par un groupe de travail restreint de l’Organisation Mondiale de la Santé est arrivé à la conclusion en mars 2015 que le glyphosate était « probablement cancérigène ». Reste à vérifier si ces monographies sont représentatives d’une vraie controverse scientifique ou si elles sont rassemblées à charge en fonction d’un objectif partiel.

Accessoirement, il n’est pas inutile d’aller vérifier si l’auteur de la monographie a déclaré ou non des conflits d’intérêt. Dans le cas cité, l’animateur qui avait conduit le groupe de travail de l’OMS sur le Glyphosate, Christopher J. Portier, n’avait pas fait état de ses activités précédentes dans l’ONG anti-pesticides américaine, Environmental Defense Fund (EDF), ni du contrat qu’il avait passé avec la firme juridique Weitz & Luxenberg chargée d’attaquer Monsanto.

Au demeurant, l'OMS s'est contredite en participant à une: "Réunion mixte de la FAO et de l’OMS sur les résidus de pesticides" (JMPR, 16 mai 2016). L'OMS adhérait à ces conclusions:

« Le JMPR a conclu qu’il est improbable que le glyphosate soit génotoxique aux expositions alimentaires anticipées » (p. 2)

« Le JMPR a conclu qu’il est improbable que le glyphosate soit génotoxique aux expositions alimentaires anticipées » (p. 2)

« Compte tenu de l’absence de potentiel cancérogène chez les rongeurs à des doses pertinentes pour l’Homme et de l’absence de génotoxicité par voie orale chez les mammifères et compte tenu des preuves épidémiologiques d’expositions professionnelles, le JMPR a conclu que le glyphosate est peu susceptible de présenter un risque cancérogène pour l’Homme à travers le régime alimentaire » (p. 2).

« Compte tenu de l’absence de potentiel cancérogène chez les rongeurs à des doses pertinentes pour l’Homme et de l’absence de génotoxicité par voie orale chez les mammifères et compte tenu des preuves épidémiologiques d’expositions professionnelles, le JMPR a conclu que le glyphosate est peu susceptible de présenter un risque cancérogène pour l’Homme à travers le régime alimentaire » (p. 2).

Le Circ est la seule agence, à ce jour, à avoir classé ainsi le glyphosate. Toutes les autres agences qui se sont prononcées sur le sujet l’ont classé comme non cancérigène : l’Anses, la FAO et l’OMS, l’Efsa, l’Echa, l’EPA, l’Osav, l’Arla, la PMRA, la RDA, l’APVMA, la FSC, la NZ EPA et la BFR.

- Les études de laboratoire

Il s’agit d’un stade un peu supérieur. Mais il convient de vérifier les protocoles d’étude (a), de comparer le résumé de l’étude, pouvant être repris par les média de manière simpliste (b) avec la discussion interne aux auteurs de l’étude (c), de voir la qualité de la revue scientifique dans laquelle est publiée l’étude et la renommée de ses reviseurs (d).

Il n’est malheureusement pas rare qu’après publication, une étude soit contestée au point que la revue exige une rétraction de l’étude, contredisant ainsi, les conclusions du comité des pairs. Le cas exemplaire a été celui du retrait de l’étude d’un laboratoire connu qui avait allégué que les O.G.M. seraient cancérigènes. Les souches de rats retenus dans le protocole, Sprague Dawley, étaient connues pour développer spontanément des incidences de cancers élevées. En sept 2019, la revue Nature a demandé à des océanographes de retirer leur article publié onze mois auparavant sur le réchauffement des océans. Ces auteurs étaient pourtant réputés[1].

- Les études épidémiologiques

Il s’agit d’un stade encore plus élaboré au plan de la méthodologie. Elle est donc plus coûteuse. Mais si une question devient obsessionnelle d’un point de vue social, il faut avoir le courage d’y avoir recours.

Le mot épidémie suggère qu’il s’agit d’enquêtes auprès d’un échantillonnage très importants de personnes. Cela peut aller jusqu’à plusieurs dizaines de milliers de personnes. La multiplicité des facteurs possibles à comparer impose l’usage de questionnaires très détaillés sur l’alimentation des personnes interrogées, sur les sports pratiqués, leur profession, leur sexe, leur âge, leur degré de tabagisme, leur consommation éventuelle de stupéfiants, les traitements pharmaceutiques qu’ils suivent pour cause de maladie ou par confort, … Il faut retenir un maximum de critères, de façon à essayer de séparer les facteurs de risques à partir d’algorithmes mathématiques. Un sous échantillonnage des personnes enquêtées peut même être invité à subir un check-up devant un médecin. L’étude épidémiologique doit, par ailleurs, être ce qu’on appelle longitudinale et non pas transversale. Une étude transversale consiste à observer des individus, à un moment donné. Elle sera longitudinale si l’enquête est reprise sur les mêmes personnes dix ans après par exemple.

Pour prendre des décisions relatives aux allégations-santé, il faut avoir recours à des protocoles adaptés aux degrés de gravité d’un problème. Tel ou tel type d’étude sera privilégiée selon qu’il s’agit d’un degré de gravité tangible, ou d’un degré de gravité sociétale. Faute de cela le subjectif non quantifié, ou l’émotionnel seront souvent imposés par des pouvoirs idéologiques divers et variés.

Certes le coût des études épidémiologiques peut être très élevé. Ceci étant, le coût cumulé pour toutes les entreprises d’un secteur soumis à des pressions irrationnelles peut être encore plus considérable si elles sont tenues de modifier inutilement leurs processus industriels. On pourrait recommander, voire subventionner des entreprises pour qu’elles cofinancent, en lien avec les experts universitaires, des études épidémiologiques digne de ce nom. Nous y reviendrons en conclusion.

2- Les risques sur l’environnement planétaire

Réflexions d’ordre méthodologique.

L’écologie est une science du complexe. Elle nécessite une forme de pluridisciplinarité qui n’est pas sans poser des problèmes : dans certains domaines, il faut avoir recours à des milliers et des milliers de scientifiques. Ce recours est souvent mis en avant pour prétendre qu’il y a un consensus scientifique. Mais un consensus, dit le Larousse, est toujours une « procédure d’accord » mais ne qualifie pas nécessairement le « contenu de l’accord ».

Sur la question climatique, par exemple, qui sont ces milliers de scientifiques ?

Ce sont des gens aussi divers que des climatologues, des pédologues – parce que les sols stockent du CO2- et des agronomes, des glaciologues, des océanographes, des hélio-sismologues, des biologistes, des mathématiciens, des modélisateurs, des thermodynamiciens, des chimistes de l’atmosphère... Tous contribuent à la science de l’écologie, chacune avec sa discipline propre. Et la science écologique a besoin de toutes ces sciences, parce qu’on est face à un système complexe. Il ne s’agit pas ici de contester le sérieux de chacune de ces sciences, et encore moins celui de chacun de ces scientifiques. Chacune, prise une par une, peut être considérée comme une pièce d’un puzzle. La question à se poser, est de savoir si des milliers de pièces du puzzle peuvent donner une cohérence à ce puzzle complexe et permettre d’énoncer une loi écologique. Quelle discipline va rapprocher le glaciologue qui étudie les fontes de glaciers, qui sont une des conséquences des variations climatiques, et ceux qui s’interroge sur leurs causes comme le font les hélio-sismologues au niveau du fonctionnement du soleil ? Comment mettre au même niveau les thermo-physiciens qui réfléchissent aux lois de l’effet de serre, et les vulcanologues qui s’interrogent sur l’impact des éruptions sur le climat ? Chacune de ces disciplines est très sérieuse dans ses analyses. Mais les unes s’occupent des conséquences, les autres des causes. Qu’est ce qui va leur donner une cohérence suffisamment légitime pour énoncer une vérité scientifique ?

Il ne s’agit pas d’ériger le « scepticisme » ou le doute, en système de pensée. Il ne suffit pas, non plus de se contenter d’une « croyance », au sens de ceux qui commencent une phrase en disant, « je crois que… ». Il serait malsain que les opinions publiques ne soient réduites qu’à choisir entre des étiquettes très réductrices de climato-sceptique ou de climato-crédule !

Se référer à un consensus, autour de milliers de scientifiques qui « croient que… », relève de l’argument d’autorité. Mais l’autorité des arguments en est-elle pour autant renforcée ?

Quelles sont donc les méthodologies existantes en matière de systèmes complexes planétaires ?

Étant donnée la complexité des systèmes en jeu, il faut bien construire des modèles. Les modélisateurs savent qu’un modèle n’est pas destiné à expliquer une complexité, mais à faire des prévisions à travers cette complexité. Il est classique de reprocher à des épistémologistes de vouloir interpréter tous les types de modèles à partir d’un seul type de modèle. C’est une tentative très courante. Malgré tout, des constantes dans tous les types de modèles sont décelables. Quelles sont ces constances ? Il est possible de les regrouper autour de cinq principes.

On peut aussi les appeler des signaux. Il faut en retenir qui soient indépendants du système et distinguer ce qui sont des signaux d’entrée, des causes, et d’autres qualifiés de sortie, c’est à dire des effets. Il faut, surtout, éliminer tout ce qui ressemblerait à des variables intermédiaires présupposant le résultat du modèle.

Certaines problématiques peuvent se contenter de mesures sur des périodes courtes. Mais quelquefois, il faut être capable de recourir à des données sur des périodes longues. Dans ce cas, il peut être nécessaire d’avoir recours à des « reconstructions » de données. A cette fin, il est possible de recourir à des « proxys ». Un proxy est une mesure de substitution étroitement corrélée à une variable manquante dans une base de donnée. Ces reconstructions de données exigent de « corriger » des données dans le but de reconstruire et de raccorder des séries de données entre elles, tout en veillant à ne pas effacer des réalités, même si ces réalités ne sont pas cohérentes avec le résultat attendu d’une recherche.

Structurer les modèles consiste à retenir des lois simples et robustes et à paramétrer le dit-modèle. Il faut également veiller à ne jamais confondre une cause et un effet. Des boucles de rétroactions internes au système ne peuvent pas être assimilées à des causes.

Il s’agit de quantifier chaque hypothèse causale par des tests d’hypothèses. Une hypothèse est vérifiée en s’assurant que la prévision qui en ressort est conforme aux observations. La quantification ne se limite pas à retenir une hypothèse causale plus qu’une autre, mais va jusqu’au calcul des degrés de confiance à accorder à une relation de cause à effet. Un « test d’hypothèse » est une procédure statistique ayant pour but de fournir une règle de décision permettant, sur la base d’observations, de discriminer deux hypothèses statistiques.

- Les prévisions et vérifications avec les réalisations

C’est le principe fondamental d’un modèle pour qu’il ne soit pas virtuel mais relié au monde réel. Certains imaginent qu’il est difficile de faire des prévisions au motif que les phénomènes observés relèvent d’une temporalité longue et qu’il n’est pas possible d’avoir recours à la méthode expérimentale en laboratoire. Or les statisticiens savent que la mathématique n’est qu’un langage et qu’elle n’a pas le sens du passé et du futur. Ils s’appuient donc sur ce qu’ils appellent « l’hypothèse d’ergodicité », utilisée depuis le 19ème siècle : elle permet de remplacer une série d’expériences par une seule, de durée suffisamment longue. Il suffit de traiter le passé comme un futur. C’est, en quelque sorte, une « rétro-prévision ».

Réflexions méthodologique sur le système climatique planétaire.

A titre d’exemple, parmi les multiples systèmes complexes planétaires, ces principes peuvent aider à prendre du recul sur les questions d’ordre climatique :

- Les indicateurs climatiques

De manière assez unanime, et à part quelques climato-sceptiques peu crédibles, tout le monde retient la température globale terrestre, comme effet détecté, et comme facteurs causaux éventuels, l’irradiance solaire, les émissions de CO2 et l’activité volcanique. Vouloir prendre d’autres indicateurs comme celui de la hausse du niveau des océans risquerait d’être approximatif. Le niveau des océans est en effet impacté par d’autres facteurs internes au système : les mouvements de la tectonique des plaques qui peuvent faire varier le niveau des océans dans certaines régions (a), les variations de pressions atmosphériques colossales dans les régions du pacifique sud touchées par les phénomènes El Nino et El Nina (b), ou les mécanismes de la circulation thermo-haline qui sont si puissants qu’ont les qualifie de « tapis roulant » au cœur des océans (c).

- L’historique des données climatiques

Le G.I.E.C. est-il légitime à se limiter à 150 ans d’observations[2] ? Ce type de pratique revient à occulter la période chaude médiévale puis le petit âge glaciaire du xve à la fin du xixe siècles au moment de la Bérézina. Pour expliquer ces variations, même un non spécialiste, avec son propre bon sens, peut comprendre qu’il est nécessaire de retenir un minimum d’observations sur mille ans.

- La structuration des modèles climatiques

Presque tous les modèles climatiques utilisent des modèles à transfert d’énergie, (Energy Balance Model – E.B.M.) fondés sur les principales lois de la physique. Il en existe plusieurs types.

Toute la question est alors de savoir à quel espace appliquer ces lois.

(a) La première possibilité est d’englober, en un seul système, la globalité de la mécanique climatique terrestre.

(b) Le G.I.E.C., quant à lui, l’applique à plus de deux cent mille sous-ensembles sous-forme de « planètes numériques » constituée de cubes d’océans de profondeur, de cubes de montagne, ou de toundras, des cubes de haute ou de basse atmosphère, etc …. Malheureusement, la complexité des transferts d’énergie d’un cube à l’autre est telle que les sources d’erreur augmentent, car la complexité engendre l’imprécision.

Ajoutons qu’il ne suffit pas qu’une loi physique, par exemple l’effet de serre, soit vérifiée en laboratoire pour qu’elle suffise à structurer un modèle climatique. En effet, les perturbations colossales des masses d’air peuvent rendre plus complexes le phénomène de l’effet de serre : les masses d’air sont brassées avec une ampleur colossale par les mouvements verticaux des alizés dans les régions tropicales. Ils renvoient des masses d’air chaud, donc émettrice d’infra rouges, à des altitudes où les concentrations de CO2 sont plus faibles. C’est ce qui explique, paradoxalement, que c’est au niveau des tropiques, là où la planète est la plus chaude, qu’elle émet dans le cosmos le plus d’infra rouges[3] !

Par ailleurs, le G.I.E.C., lui-même, reconnait qu’il est conduit à éliminer certains facteurs pour limiter la complexité, en particulier le rôle des nuages : dans leurs modèles, le G.I.E.C. ne retient que « des conditions de ciel clair[4] … ». Pourquoi cela? Parce que, dit le G.I.E.C., « l’introduction de nuages compliquerait grandement les objectifs de la recherche[5]. » Or la recherche devrait se fixer comme mission de faire des prévisions malgré la complexité du système ! Pourtant, tous les climatologues reconnaissent que la vapeur d’eau est également un gaz à effet de serre et que les nuages sont un facteur de rétroaction interne fondamental.

Ce n’est pas une raison pour introduire un phénomène comme El Nino[6] dans les facteurs causaux[7]. Or, il est connu que ces oscillations océano-atmosphériques du Pacifique sud ne sont que des boucles internes de la mécanique climatique, et ne sont pas la cause des variations longues.

Il faut, enfin, structurer le modèle en utilisant des calculateurs avec des algorithmes mathématiques. Le G.I.E.C. qualifie cette étape de « détection-attribution », c’est-à-dire la détection d’un effet et son attribution à une cause. Mais comment s’expliquer que le G.I.E.C. dise que cela « n’exige ni n’implique que chaque aspect de la réponse au facteur causal en question soit correctement simulé[8] » ?

Le G.I.E.C. aborde cette problématique de la « détection-attribution » en utilisant des modèles de planète virtuelle. Les modèles qui travaillent sur un seul système climatique global considèrent que les nuages font partie du système mais ne cherchent pas à expliquer les mécanismes interne de rétro-causalité. Ils s’attachent à l’essentiel : non pas expliquer les relations de cause à effet entre les signaux extérieurs au système, mais les quantifier pour faire des prévisions.

- Le paramétrage des modèles climatiques

Les modèles référencés par le G.I.E.C. introduisent des paramètres, par exemples, la sensibilité de la température à la variation d’émission de CO2 qu’ils exploitent ensuite dans leurs calculs, ou la viscosité des fluides dans les transferts d’énergie d’un cube à l’autre, ou encore des coefficients d’évaporation en fonction de l’état de la mer ou des vents.

Une première méthode consiste à faire des études théoriques et spécifiques pour estimer a priori ces paramètres et les introduire dans le système, avec des degrés d’imprécision qui s’accumulent.

Une autre méthode consiste à laisser le système calculer lui-même quelques-uns de ces paramètres sans aucun a priori, à partir de l’observation des faits et non à partir d’études scientifiques préalables.

Le risque de l’approche des modélisateurs du G.I.E.C. est d’être partial. D’ailleurs un des théoriciens de la modélisation, faisant autorité dans la communauté du G.I.E.C., a fait une enquête et a reconnu que 22 des 23 principaux centres de modélisation climatiques qu’il a interrogés paramétraient leurs modèles « pour obtenir les propriétés souhaitées »[9] ! Pourtant, le principe d’une méthode scientifique est de ne pas préjuger des résultats. Les calculs menés par le G.I.E.C. sur ces paramètres sont d’ailleurs d’une très grande opacité. Il faut une solide expertise scientifique pour arriver à reconstituer certains paramètres comme les sensibilités climatiques retenues par le G.I.E.C.

A contrario, les modèles ne cherchant à identifier qu’un seul système global, parviennent, grâce aux tests d’hypothèses, à calculer les paramètres de sensibilité de la température au CO2, d’irradiance solaire ou d’activité volcanique. C’est ce qui explique que l’utilisation de modèles par identification conduit à des sensibilités complètement différentes de celles du G.I.E.C. Bien entendu, une modélisation sur 150 ans d’observation ne conduit pas aux mêmes sensibilités que celles calculées sur 1000 ans de données.

- La quantification des relations de cause à effet en matière de climat

Nécessairement, ces différences d’approche de paramétrage vont permettre ou non des quantifications précises des relations entre les signaux retenus.

La modélisation alternative fondée sur l’identification d’un système unique global exploite avec rigueur ses tests d’hypothèses. Sa conclusion est que « l’hypothèse, selon laquelle l’activité humaine n’aurait pas d’effet significatif, ne peut pas être exclue... Avec un taux de certitude significatif de 90%..., on doit considérer comme un fait établi que l’activité solaire, en tant que variable explicative causale, constitue l’explication première du « changement climatique »[10].

Le G.I.E.C., travaillant sur une planète numérique multicellulaire, invoque une probabilité de 95% que le réchauffement soit d’origine humaine. L’auteur de cet article a participé à un débat avec deux représentants du G.I.E.C. à qui il était demandé par écrit les références du calcul de 95%. La réponse écrite a été qu’il ne s’agissait pas d’une probabilité calculée mais d’une probabilité subjective. Les rapports du G.I.E.C. le confirment : « les probabilités "Objectives" et "Subjectives" ne sont pas toujours explicitement distinguées »[11]. Peut-on parler de chiffrage et de quantification avec de telles approches ?

- Les prévisions et les réalisations climatiques

Dire que la gravité et l’urgence des enjeux sont telles qu’on n’a pas le temps de vérifier si les modèles auront raison ou tort, relève d’une forme d’esquive. Il suffit de faire, avec les modèles, des « retro-prévisions ». Il est possible de tester les sensibilités retenues par le G.I.E.C. à partir des observations faites sur 150 ans et de reconstruire sur 1000 ans l’histoire climatique antérieure à 1880. Le Giec a publié un résultat de ce type[12]. Il ne dégage qu’un flou effaçant les variations que l’histoire a connu pendant l’« optimum médiéval » du xe au xive siècle et le « Petit âge » glaciaire du xve au xviiie siècle. Ce n’est pas être provocateur que de dire que si un modèle n’est pas capable de restituer l’historique passé, c’est qu’il est inefficient à prévoir le futur.

3- Conclusion

Curieusement, des centaines de publications, chaque année, font état de travaux sur l’impact de l’activité solaire sur le climat mais ne sont pas référencées dans les rapports du G.I.E.C. Il est pourtant assez aisé d’en prendre connaissance. Il suffit d’utiliser les moteurs de recherche internet avec quelques mots clefs, de préférence en anglais, comme « Elsevier [13] », « soleil », « rayons cosmiques ». En deux heures de recherche, il est aisé d’avoir accès à ces études et d’en lire les protocoles et les conclusions.

L’analyse, menée ci-dessus sur la question climatique, pourrait aussi bien être détaillée sur ce que certains scientifiques appellent les « neuf limites planétaires »[14] : ozone, biodiversité, particules fines, etc… La présente note n’a pas pour objet, de montrer l’absence de bien des indicateurs planétaires sur ces sujets, l’absence de lois permettant de structurer des modèles et l’absence totale de prévisions fournies par ces modèles. L’auteur de ces lignes restent à la disposition du lecteur pour élargir ce type d’analyse aux autres enjeux planétaires.

[1] Océanographe des universités de Princeton, Fudan à Shanghai, du Centre de recherche sur les océans de Kiel et du français L. Popp à LMD/IPSL, ENS, PSL Research University, École Polytechnique, Sorbonne Université, CNRS, Paris, France. Ils ont reonnu qu’un commentateur externe, Nicholas Lewis, les avaient conduits à se « rendre compte d’incertitudes déclarées sous-estimées en raison de leur traitement de certaines erreurs systématiques … qui a considérablement affaibli les implications d'une révision à la hausse du réchauffement des océans et de la sensibilité climatique.» ! (source : https://www.nature.com/articles/s41586-019-1585-5, site consulté le 9.10.2019)

[2] GIEC-IPCC, WG1 Fifth Assestment Report, Chap. 10, Fig. 10.1, p. 107/131 www.climatechange2013.org/images/report/WG1AR5_SOD_Ch10_All_Final.pdf, (consulté le 28/08/19)

[3] Les cameras à infrarouge (source : https://www.youtube.com/watch?v=f7QttjGu628 , consultée le 9.10.2019), mesurant les émissions de la terre à partir de satellites, montrent précisément que c’est dans les zones tropicales que la terre émet le plus d’infrarouges. L’effet de serre n’agit donc pas en réchauffant l’atmosphère par absorption du rayonnement infrarouge émis par la surface, comme on l’enseigne en classes de SVT, avec la bénédiction du GIEC. Au contraire, il agit en refroidissant l’atmosphère par émission d’infrarouges à haute altitude. Plus la concentration de GES est forte, plus l’altitude d’émission est élevée, et plus la surface doit être chaude pour générer une circulation atmosphérique capable de transférer à plus haute altitude un même flux énergétique à l’équilibre. Conceptuellement, les climatologues prennent le problème à l’envers. Pour des raisons calculatoires, ils adoptent comme point de départ l’émission infrarouge de surface, et ils se focalisent sur le transfert radiatif à travers l’atmosphère, alors que le cheminement causal est inverse.

[4] Giec-IPCC “Most intercomparison studies on RF of greenhouse gases are for clear-sky” IPCC, WG1 Fifth Assestment Report, § 8.3.1, p. 8-18/124, ligne 17, www.climatechange2013.org/images/report/WG1AR5_SOD_Ch08_All_Final.pdf (consulté le 28/08/19)

[5] “The introduction of clouds would greatly complicate the targets of research” ibid., ligne 18.

[6] Phénomène atmosphérique et océanique complexe et périodique observable dans les zones pacifiques tropicales. Son origine est assez mal connue.

[7] Giec-Ipcc, WG1AR5, Fifth Assessment Report, chapter 10, Fig 10.5, p 111/131 , www.climatechange2013.org/images/report/WG1AR5_SOD_Ch10_All_Final.pdf (consulté le 28/08/19)

[8] “Attribution does not require, and nor does it imply, that every aspect of the response to the causal factor in question is simulated correctly”.

GIEC-IPCC, “Climate Change 2013 - The Physical Science Basis: Woking Group 1 contribution to the fith assesment report of the IPCC” , p. 873, www.ipcc.ch/site/assets/uploads/2018/02/WG1AR5_Chapter10_FINAL.pdf (consulté le 28/08/19)

[9] «22 of 23 groups reported adjusting model parameters to achive desired properties such as radiation balance at the top of the atmosphere”, source: Frédéric Hourdin, The Art and Science of Climate Model Tuning (L’art et la science du réglage des modèles climatiques), American Meteorological Society , 9 juillet 2016, https://journals.ametsoc.org/doi/full/10.1175/BAMS-D-15-00135.1 , (consulté le 18/08/19)

[10] Publication, intitulée Earth climate identification vs. anthropic global warming attribution ( Identification du système climatique vs. détection et attribution » et référencée par « ScienceDirect », revue, dans les règles, par les pairs du comité de lecture de Annual Reviews in Control (ARC), une des sept revues scientifiques de l'IFAC, Fédération internationale qui regroupe des milliers d'experts en contrôle, automatique et identification des systèmes complexes. www.sciencedirect.com/science/article/pii/S1367578816300931?via%3Dihub (consulté le 28/08/19)

[11] Giec-Ipcc, “Objective and subjective probabilities are not always explicitly distinguished”. Cette affirmation est le titre exact de la section 2.6.2 du Third Assessment Report of IPCC , “Contribution of the Working Group II: Impacts, Adaptation and Vulnerability”, p. 129, www.ipcc.ch/site/assets/uploads/2018/03/WGII_TAR_full_report-2.pdf (consulté le 28/08/19)

[12] Giec-Ipcc, AR5, Working Group 1, The Physical Science Basis, Report Graphics- Technical Summary- Box TS.5, fig 1-b, http://www.climatechange2013.org/report/reports-graphic/ts-graphics/ (consulté le 28/08/19).

[13] Leader mondial de la diffusion des publications scientifiques soumises à ces comités de lecture.

[14] La revue Sciences express a publié le 15 janvier 2015, une prétendue étude scientifique intitulée : "Planetary Boundaries: Guiding human development on a changing planet".