La maison d'édition anglo-néerlandaise Elsevier B.V. a mis en ligne le 25 octobre 2016, un article, intitulé « identification du climat terrestre vs. détection et attribution ». Cette publication, référencée sur le site ScienceDirect, a été revue dans les règles par les pairs du comité de lecture de Annual Reviews in Control (ARC, 2016 1-12), une des sept revues scientifiques de l'IFAC, fédération internationale qui regroupe des milliers d'experts en contrôle, automatique et modélisation des systèmes complexes.L’auteur, le professeur Philippe de Larminat, est un spécialiste reconnu dans ces disciplines. Il a appliqué les techniques éprouvées de l’identification des systèmes dynamiques au climat terrestre, en exploitant des bases de données paléo-climatiques disponibles auprès des grands instituts et organismes internationaux. Il en résulte que, « avec un niveau de probabilité de 90%, on ne peut pas rejeter l'hypothèse d'une contribution anthropogénique nulle ou insignifiante ». Par ailleurs, « l'hypothèse d'une faible contribution de l'activité solaire doit être rejetée avec un niveau de probabilité supérieur à 90% ».À l’inverse, le Giec, considère comme « extrêmement probable que l'influence de l'homme a été la cause dominante du réchauffement observé depuis le milieu du 20e siècle », ceci sur la base d’une théorie de « Détection et Attribution » explicitement dédiée à l’attribution humaine des récents changements climatiques.

La maison d'édition anglo-néerlandaise Elsevier B.V. a mis en ligne le 25 octobre 2016, un article, intitulé « identification du climat terrestre vs. détection et attribution ». Cette publication, référencée sur le site ScienceDirect, a été revue dans les règles par les pairs du comité de lecture de Annual Reviews in Control (ARC, 2016 1-12), une des sept revues scientifiques de l'IFAC, fédération internationale qui regroupe des milliers d'experts en contrôle, automatique et modélisation des systèmes complexes.L’auteur, le professeur Philippe de Larminat, est un spécialiste reconnu dans ces disciplines. Il a appliqué les techniques éprouvées de l’identification des systèmes dynamiques au climat terrestre, en exploitant des bases de données paléo-climatiques disponibles auprès des grands instituts et organismes internationaux. Il en résulte que, « avec un niveau de probabilité de 90%, on ne peut pas rejeter l'hypothèse d'une contribution anthropogénique nulle ou insignifiante ». Par ailleurs, « l'hypothèse d'une faible contribution de l'activité solaire doit être rejetée avec un niveau de probabilité supérieur à 90% ».À l’inverse, le Giec, considère comme « extrêmement probable que l'influence de l'homme a été la cause dominante du réchauffement observé depuis le milieu du 20e siècle », ceci sur la base d’une théorie de « Détection et Attribution » explicitement dédiée à l’attribution humaine des récents changements climatiques.

L’article [1] présente et clarifie les origines de ces contradictions.

- La principale tient aux durées retenues pour les observations climatiques : mille ans pour l’Identification, au maximum cent cinquante ans pour la Détection-Attribution, ce qui élimine ainsi les évènements millénaires de la période chaude médiévale et du petit âge glaciaire, notoirement corrélés à l’activité solaire. « Cela contribue à minimiser la contribution de l’activité solaire », explique l’auteur.

- La seconde dénonce une confusion entre cause et effet, à propos des événements de type El Niño. On ne peut que s’interroger sur les raisons de cette « erreur méthodologique lourde, qui saute aux yeux de n'importe quel expert en science des systèmes ».

La publication de Philippe de Larminat est-elle de nature à remettre en cause le consensus dominant sur l’origine humaine des changements climatiques, consensus en passe de bouleverser les équilibres économiques mondiaux (COP 21, 22) autant que les repères éthiques (Laudato si) ? Interrogé sur la possible émergence d’un autre consensus, celui d’une action prépondérante de l’activité solaire sur le climat, l’auteur se limite à rappeler que: « Ni les consensus, ni les votes n'ont de place en science ; seules les preuves importent. A l’argument d’autorité, Descartes opposait l’autorité de l’argument. Or, le consensus n'est qu'une soumission à l'argument d'autorité, le plus faible qui soit ».

Cette publication, dont une bonne partie est accessible même à des non-experts confirme les conclusions déjà avancées par l’auteur dans son précédent ouvrage « Changement climatique - identification et projections » (ISTE/Wiley 2014).

Nous mettons ci-après la version française de cet article.

Diffusion: les2ailes.com

Version française de la publication en libre accès : © 2016 Publié par Elsevier Ltd.

Earth Climate Identification vs. Anthropic Global Warming Attribution

(Philippe de Larminat, Annual Reviews on Control, 2016, 1-12)

http://dx.doi.org/10.1016/j.arcontrol.2016.09.018

Identification du climat terrestre vs. Attribution anthropique du réchauffement global*

Philippe de Larminat

Professeur (retraité) de l’Ecole Centrale. Nantes, France

* Cette recherche n’a bénéficié d’aucun financement, ni du secteur public, ni d’entreprises privées, ni d’organismes à but non lucratif.

Mail : Cette adresse e-mail est protégée contre les robots spammeurs. Vous devez activer le JavaScript pour la visualiser.

|

|

Philippe de Larminat (diplôme d’ingénieur, 1964, Ph. D., 1972). Il a été Professeur à l’Institut National des Sciences Appliquées (Rennes, France) et à l’Ecole Centrale (Nantes). Il est l’auteur de 6 ouvrages et de plus de 100 articles publiés dans des journaux et lors de conférences internationales. Depuis 2001, il est consultant indépendant et auteur de plusieurs brevets (par exemple contrôle de centrales électriques, guidage de satellites).

Ses intérêts de recherche incluent la modélisation mathématique, l'identification des processus, le traitement de signaux et la théorie du contrôle. Depuis 2012, il poursuit un travail de pionnier sur l'identification du système climatique terrestre.

|

RÉSUMÉ

|

Historique de l’article

Reçu le 3 février 2016

Révisé le 14 septembre 2016

Accepté le 27 septembre 2016

Disponible en ligne le 25 octobre 2016

|

|

Sur la base de ses modèles et des observations climatiques centennales, le Groupe intergouvernemental sur l’évolution du climat (GIEC) attribue à l’activité humaine la plus grande partie du réchauffement climatique observé depuis la moitié du 20e siècle. Dans ce contexte, cet article présente la première tentative d’envergure jamais réalisée d’identification du système climatique, menée en vue de réduire sensiblement les plages d’incertitude des modèles. Les données climatiques étant ce qu’elles sont, les modèles identifiés ne répondent qu’imparfaitement à cette attente. Néanmoins, malgré la dispersion des paramètres identifiés et des simulations induites, on peut en tirer des conclusions robustes, et qui se révèlent incompatibles avec celles du GIEC : les contributions naturelles (activité solaire et variabilité interne) apparaissent en effet prépondérantes dans le réchauffement récent. Nous confrontons alors notre travail avec l’approche privilégiée par le GIEC, nommément la « detection and attribution related to anthropic climate change ». Nous expliquons les divergences, d’une part par la mise à l’écart par le GIEC des données paléoclimatiques millénaires, et d’autre part en raison d’une confusion manifeste entre cause et effet, lorsque l’indice El Niño est pris en compte dans la détection et attribution.

© 2016 Publié par Elsevier Ltd.

|

|

Mots clés:

Identification des systèmes,

Climat,

Réchauffement global,

Détection et attribution,

Anthropogène.

|

1. Introduction

Le processus climatique est un système hautement complexe, sur lequel les scientifiques expérimentés en théorie des systèmes ont beaucoup à dire. Cela concerne en particulier la modélisation du climat global et l'attribution du réchauffement récent aux causes humaines ou naturelles, ceci sur la base des observations climatiques, présentes ou passées, directes ou indirectes. Une approche particulièrement indiquée devrait être celle de l'identification de systèmes dynamiques, une théorie bien connue des praticiens, mais qui, étonnamment, n’est pas exploitée ni même évoquée par des scientifiques du climat.

En effet, les recherches bibliographiques basées sur les mots clés system identification, climate, global warming ne retournent aucune référence concernant l'identification du processus climatique. En revanche, si l'on ajoute détection et attribution à la liste, on obtient cette fois des dizaines d'articles ayant trait à l'attribution du changement climatique à l'activité humaine. Par ailleurs, les mots-clés restreints aux seules détection et attribution renvoient exclusivement aux changements climatiques anthropiques.

Il apparait donc que la "Détection et Attribution » (D&A), est une théorie émergente, née au début du 21e siècle, exploitée exclusivement dans le cadre spécifique de l'attribution des changements climatiques à l’activité humaine. Ceci se manifeste dans le titre de la publication importante suivante: « Good practice guidance paper on detection and attribution related to anthropogenic climate change », par Hegerl et al. (2010).

L'absence de référence à l’identification est troublante, sachant que la D&A présente des relations étroites avec l'identification, alors que ces deux méthodes conduisent à des résultats mutuellement incompatibles. Le présent article décrit le premier travail d’envergure effectué, selon les règles de l’art, sur l'identification du système climatique. Il reprend certains éléments de notre livre « Changement Climatique, Identification et Projections » (de Larminat, ISTE/Wiley, 2014). Il le complète par des développements sur ses relations avec la D&A, et élucide les raisons des différences entre nos conclusions et celles du GIEC (Groupe Intergouvernemental sur l’Évolution du Climat).

Le dernier rapport du GIEC est le cinquième (AR5, 2013): 1550 pages, 9200 publications citées. Une synthèse en est faite dans le résumé pour les décideurs (Summary for Polycy Makers : SPM, 2013). Une des conclusions majeures est qu’« il est extrêmement probable que l'influence de l'homme a été la cause dominante du réchauffement observé depuis le milieu du 20e siècle ». Elle est étayée par le chapitre 10 de AR5: « détection et attribution - du global au régional ». Mais ces positions sont infirmées par l'identification du système climatique à partir des observations climatiques millénaires : il apparaît que le réchauffement récent est dû principalement aux causes naturelles (l'activité solaire et des variations aléatoires) et que l'on ne peut pas rejeter l'hypothèse que la contribution humaine soit négligeable.

L’objet de cet article est de présenter et de clarifier les causes de cette contradiction. Il est organisé comme suit.

La section 2 présente les données climatiques : entrées : les signaux représentatifs des activités humaine, solaire et volcanique ; sortie : la température globale de la surface terrestre.

La section 3 décrit les caractéristiques fondamentales du système climatique de la Terre et la structure mathématique du modèle identifiable proposé.

Les principaux résultats de l'identification sont présentés en section 4, obtenus par la méthode de l'erreur de sortie (OE), ainsi que l'analyse statistique et les conclusions des tests d’hypothèses.

La section 5 présente et critique des résultats de la D&A: tout d'abord, les périodes d'observation (de quelques dizaines à une centaine d'années) sont trop courtes, ce qui conduit à sous-estimer la variabilité interne et à susciter de fausses détections de la contribution humaine dans le réchauffement climatique.

En outre, elles privilégient la période récente caractérisée par l’accroissement simultané de la température globale et de la teneur en CO2 atmosphérique, sans recouvrir les événements climatiques majeurs (période chaude médiévale, petit âge glaciaire et minimum de Maunder associé), qui mettent en évidence la contribution solaire. Enfin, les études de D&A qui impliquent l'indice El Nino commettent une erreur méthodologique fondamentale, à savoir la confusion d’un effet avec une cause externe dans le processus climatiques. Les conclusions générales sont présentées en section 6.

2. Les données d’entrée-sortie du système climatique

2.1. Causes et effets

Le climat terrestre est un système complexe sur lequel on peut observer une grande quantité de signaux, parmi lesquels il n'est pas toujours facile de distinguer lesquels sont des causes et lesquels sont des effets. Pour les scientifiques de la théorie des systèmes, la question de la causalité n’a de sens que si le système (ou le sous-système) concerné est clairement délimité; on sait que pour des systèmes couplés, le même signal est souvent à la fois cause pour un sous-système et effet pour un autre. La réponse est sans équivoque quand la causalité peut jouer seulement dans une direction, par exemple entre l'activité solaire et le climat terrestre. C'est beaucoup moins clair lorsqu'il s'agit des variables internes au système climatique, comme les phénomènes d'oscillations océaniques et l’indice ENSO associé (El Nino / Southern Oscillation). Nous reviendrons sur ce point dans la Section 5.

Un des moyens disponibles pour évaluer les contributions relatives de causes différentes est la théorie de l'identification des systèmes dynamiques, en particulier la branche consacrée à la détermination de modèles causaux à partir de l’observation de signaux d’entrée et de sortie. Les modèles dynamiques de causalité correspondent typiquement aux fonctions de transfert linéaires, rationnelles ou non et plus généralement aux modèles dans l’espace d’état.

En ce qui concerne le système climatique terrestre, il est clair que la température globale est un effet. Les causes indépendantes potentielles – sur lesquelles la température n'a aucune action en retour – sont l'activité solaire, le volcanisme et, dans une large mesure, les activités humaines.

La question des données climatiques disponibles est cruciale, tant pour l'identification que pour la détection et l'attribution. Le lecteur doit donc avoir une idée précise des ensembles de données que nous avons rassemblés et utilisés. Compte tenu des grandes échelles des temps intervenant dans le système climatique, l’identification exige que la durée des données d’entrée-sortie dépasse largement la période des mesures « historiques » – laquelle, selon les climatologues, commence au mieux en 1850. La paléoclimatologie permet de reconstituer les données climatiques antérieures à partir de mesures de substitution (ou proxies : cernes de croissance des arbres, isotopes archivés dans les sédiments, carottes glaciaires, etc.) Les reconstructions disponibles dans les bases de données accessibles (NOAA, NASA, Hadley Center, etc.) sont loin de se recouper parfaitement, et ne sont pas nécessairement raccordées aux données historiques.

2.2. Température moyenne globale

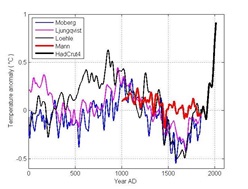

En sortie, l’indicateur climatique retenu est la température moyenne sur l’ensemble de la surface du globe. La figure 1 présente un catalogue de quatre reconstructions (Ljungqvist (2009); Loehle (2007); Moberg et al. (2005); Mann, Bradley, and Hughes, (1999).). Toutes les quatre sont ou ont été citées dans les rapports du GIEC (voir AR5, chapitre 5 : paleoclimate archives). Elles sont raccordées – et prolongées à partir de 1850 – par les mesures modernes (HadCrut4 : courbe noire épaisse).

Fig. 1. Quatre reconstructions de températures

Fig. 1. Quatre reconstructions de températures

Plus on remonte dans le temps, plus les proxys sont rares et imprécis. Certaines séries commencent symboliquement en l'an 1000. Pour des raisons de précision et de disponibilité, nous exploiterons des reconstructions de températures réduites au deuxième millénaire. Les reconstructions de Moberg et Mann sont limités à l’hémisphère nord, celles de Ljungqvist et Loehle aux zones extratropicales. Néanmoins, les différences entre les températures modernes des hémisphères nord et sud sont beaucoup plus faibles que les disparités observées entre les reconstructions ci-dessus, ce qui permet de considérer que les différences climatiques Nord/Sud ou autres sont dominées par des erreurs dues aux proxys et aux techniques de reconstruction.

On note que la courbe de Mann, appelée Graphe en Crosse de hockey, s’écarte significativement des autres, ce qui se répercutera sur les résultats de l'identification.

2.3. Indicateur anthropique : la concentration de CO2

L’activité humaine agit à travers la concentration des GES (gaz à effet de serre), les aérosols industriels, les changements d’utilisation des sols, etc. On définit un indicateur d’activité humaine à partir de la concentration atmosphérique de CO2, notée C :

U1 = log2 (C/C0)

où C0 est la concentration préindustrielle (ante 1750), évaluée à 280 ppm (parties par million).

Plusieurs raisons justifient ce choix. D’abord, l’action du CO2 est réputée prépondérante. Ensuite, les actions anthropiques secondaires (aérosols, autres GES, utilisation des sols) lui sont corrélées et ont plus ou moins tendance à s’équilibrer. Par ailleurs, l’effet de serre induit par le CO2 respecte sensiblement une loi logarithmique. Enfin il est d’usage de considérer le doublement de CO2 comme une variation type, d’où l’intérêt du logarithme à base 2 : le coefficient S1 du modèle (cf. plus loin éq. 7) se définira ainsi comme la sensibilité climatique à l’équilibre au doublement de CO2.

Fig. 2. Signal anthropique: U1 = log2 (C/C0)

Fig. 2. Signal anthropique: U1 = log2 (C/C0)

La figure 2 montre le signal u1, résultant du raccordement des mesures atmosphérique modernes et des archives extraites des carottes glaciaires arctiques ou antarctiques (source : NOAA et CDIAC). Notons que

u1 = 0.5 ↔ C= C0 + 41%

2.4. Activité solaire

Les manifestations d'activité solaire sont multiples et susceptibles d'avoir un impact sur le climat à travers des mécanismes extrêmement divers.

- Tout d'abord, par action directe du flux d'énergie total (TSI : Total Solaire Irradiancy), faiblement variable autour de 1367 Wm-2, qui affecte directement le bilan radiatif de la Terre.

- La distribution spectrale IR/UV agit différemment, par la création stratosphérique d'un gaz à effet de serre, l'ozone.

- Le magnétisme solaire module des radiations cosmiques, susceptibles de provoquer la formation de noyaux de condensation et d’agir ainsi sur la couverture nuageuse terrestre et son effet d'albédo. Cette modulation se retrouve dans des proxys constitués d'isotopes cosmogéniques (ou cosmonucléides : 12Be, 14C).

- Le vent solaire et son rôle connu dans les aurores boréales.

- Le bruit de radio de fond, pas ou peu étudié dans le contexte climatique...

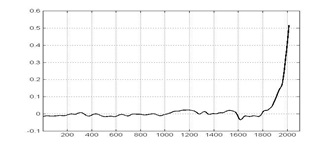

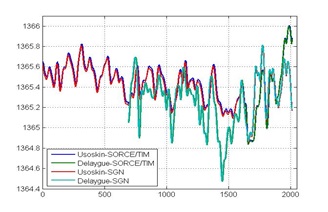

Fig. 3. Décomposition du signal SORCE/TIM

Fig. 3. Décomposition du signal SORCE/TIM

Tous les signaux liés à l'activité solaire apparaissent clairement comme une somme de trois composantes : une première en basse fréquence (LF), une seconde cyclique, d’une période d’environ 11 ans, une troisième en hautes fréquence (HF). Ainsi, la figure 3 montre la décomposition en 3 composantes de la reconstruction de TSI (Total Solar Irradiance), dite SORCE/TIM (SOlar Radiation & Climate Experiment) par Kopp et Lean (2011). Cette reconstruction composite est basée tant sur des mesures satellites modernes que sur des taches solaires observées depuis 1610 (invention de la lunette de Galilée). Notre principe de décomposition est résumé dans l'annexe A.

Dans tous les signaux et proxys liés à l'activité solaire, on peut reconnaitre, avec des amplitudes relatives différentes, la même composante cyclique et la même composante LF (la composante HF étant assimilable à un bruit de mesure). Le ratio mutuel entre les composants cyclique et LF dépend non seulement de la nature des signaux (associé aux mécanismes 1 à 5 ci-dessus), mais aussi des reconstructions données d'un même signal, en particulier le TSI. Ce ratio est extrêmement variable.

Les composants cycliques de toutes les reconstructions TSI ont en effet grossièrement la même excursion maximale (1 Wm–2 au 20ème siècle), mais les variations de la composante LF entre les ans 1700 et 2000 se situent, selon les reconstructions, dans une fourchette allant de 1 (figure 3) à 10 Wm–2 (voir, par exemple, Lean (2004) ou Shapiro et al. (2011). Ces différences résultent de l'absence de mesures directes de TSI sur des périodes suffisamment longues pour assurer une bonne précision du calibrage des proxys liées à l'activité solaire basse fréquence.

D'autre part, il est reconnu que les variations cycliques (11 ans) détectables sur la température globale sont pratiquement négligeables (moins d'un dixième de degré). Alors, en admettant que la reconstruction SORCE/TIM soit valide et que l'activité solaire impacte le climat exclusivement à travers le facteur d'énergie (le mode 1), nous devrions conclure, comme le fait le GIEC, que l'impact d'activité solaire est presque nulle.

Par ailleurs, certains mécanismes impliqués par l’activité basse fréquence (par le champ magnétique héliocentrique, par exemple) ne sont pas encore assez bien appréhendés pour être inclus dans les modèles physiques. Cela n'implique pas qu'ils n'existent pas. Notre identification est précisément destinée à déterminer si les contributions climatiques de l'activité solaire en basse fréquence sont significatives, si non prédominantes.

Si donc on accepte, soit que la composante LF du TSI peut être très supérieure à celle de la figure 2, soit que d'autres mécanismes d'activité solaire peuvent prédominer sur le facteur énergétique, la juste façon de le mettre en évidence sera de limiter les reconstructions et/ou les proxys d'activité solaire à leurs seules composantes LF, puisque la contribution cyclique est reconnue négligeable.

2.5. Indicateur d’activité solaire de basse fréquence

Étant donné la multiplicité des manifestations et des mécanismes d'activité solaire, il n'y aurait pas de raison de favoriser un signal physique plutôt qu'un autre (TSI, champ magnétique héliocentrique, potentiel de modulation solaire …), ou un proxy, de préférence à un autre, particulièrement après réduction à la composante basse fréquence.

Fig. 4. Quatre indicateurs basse-fréquence de l’activité solaire

Fig. 4. Quatre indicateurs basse-fréquence de l’activité solaire

Pour la commodité, on préfère ici tout convertir en termes de TSI. Nous adoptons arbitrairement pour signal de référence, la reconstruction SORCE/TIM, largement utilisée par le GIEC (AR5) et limitée à sa composante LF (figure 3-b). Après calibrage et alignement sur ce composant, la figure 4 combine les composantes LF des quatre proxys suivants :

- La composante SORCE/TIM LF elle-même (1510-2015).

- La série des nombres de groupes de taches solaires (Solar Group Number, SGN, 1610-2015), récemment revue et corrigé par l'Observatoire Royal de Bruxelles (Clette, Svalgaard, le Vaquero et Cliver, 2015).

- La série cosmogénique d'Usoskin, Korte et Kovaltsov (2008), initialement exprimée en ratio de CRII (Cosmic Ray Induced Ionization), basé sur les concentrations de 14C (années 5 à 2005).

- La série cosmogenic de Delaygue et Barde. (2010), initialement exprimé par les anomalies de 10Be (années 695 à 1982).

En connectant Usoskin-SORCE/TIM, Delaygue-SORCE/TIM, Usoskin-SGN, et Delaygue-SGN, on obtient un catalogue de quatre indicateurs solaires (figure 4).

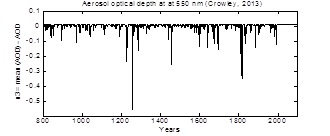

Fig. 5. Activité volcanique

Fig. 5. Activité volcanique

2.6. Activité volcanique

On évalue l’activité volcanique à travers la profondeur optique des aérosols (AOD) émis lors des éruptions (Crowley, T. J. and M. B. Unterman, 2013).

La figure 5 montre cet indicateur u3, recentré sur sa valeur moyenne, et changé de signe en raison de l’action négative du volcanisme sur le climat.

3. Un modèle identifiable

3.1. Les modèles de circulation générale (GCM)

Les GCM (General Circulation Model) sont des modèles de connaissances, simulés par éléments finis, dont les centaines de milliers de cellules (atmosphériques et océaniques) constituent autant de sous-systèmes interconnectés. Les équations qui les régissent sont d’abord celles de la physique fondamentale : conservation de la masse et de l’énergie, mécanique des fluides, thermodynamique, rayonnement, etc.

Ils incorporent aussi une quantité de représentations plus ou moins empiriques concernant par exemple les nuages, leur genèse et leurs propriétés de rayonnement et d’absorption, ou encore les transferts de chaleur à travers la surface terrestre par convection, évapotranspiration, etc. Les paramètres associés à ces phénomènes sont largement arbitraires et constituent autant de variables d’ajustement des modèles.

Cette surabondance de paramètres ajustables donne aux concepteurs la liberté de privilégier à volonté tout résultat souhaité, en particulier la reproduction du réchauffement pendant le dernier quart du XXème siècle.

À noter enfin que la nature même des équations simulées reproduit les fluctuations du chaos atmosphérique ou océanique à l’origine de la « variabilité interne » du climat.

3.2. Modèles à bilan énergétique (EBM)

Les grands modèles numériques sont évidemment les seuls à pouvoir reproduire les particularismes climatiques régionaux. Toutefois, si on s’intéresse prioritairement aux comportements globaux, le système climatique ne fait pas exception à l’immense majorité des systèmes complexes, qui sont susceptibles de se laisser représenter par des modèles de comportement entrée-sortie, dits « boîte noire », (ou « boîte grise » lorsqu’ils incorporent des lois physique macroscopiques).

C’est le cas des modèles dits à bilan énergétique, dont certains ont été développés par le GIEC, (par ex. Meinhausen, M.R. 2011). Ces modèles sont ajustés en sorte de reproduire les comportements globaux des grands modèles numériques, mais leur complexité n’est pas encore assez réduite pour les rendre identifiables à partir des observations climatiques d’entrée-sortie disponibles.

3.3. Structure proposée

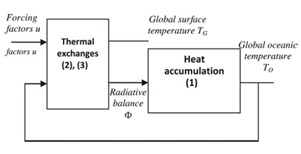

Fig. 6. Structure d’un modèle à bilan énergétique

Fig. 6. Structure d’un modèle à bilan énergétique

Notre modèle climatique est organisé autour de deux sous-systèmes couplés (figure 6).

Le sous-système accumulation thermique comprend l’ensemble des inerties thermiques dans lesquelles le flux de bilan calorifique Φ (en Wm–2) s’accumule, circule et se diffuse. Il est constitué essentiellement de la masse océanique, les inerties thermiques superficielles des continents étant négligeables.

L’inertie thermique de l’atmosphère elle aussi est négligeable. Elle n’accumule pratiquement pas d’énergie et le bilan radiatif Φ en limite supérieure de l’atmosphère (Top Of Atmosphere – TOA) se transmet donc intégralement et sans retard appréciable à l’inertie thermique océanique. L’instantanéité est à interpréter ici à l’échelle des temps climatiques, c'est-à-dire en moins d’une année (unité de temps adoptée en climatologie).

Les échanges thermiques entre les océans, l’atmosphère et l’espace résultent de facteurs causaux d’entrée u, désignés comme des facteurs de forçage et aussi de la température superficielle globale résultante TG, qui dépend elle-même de la température moyenne des océans TO.

3.4. Formulation mathématique du modèle

L’accumulation de chaleur par l’inertie thermique océanique se traduit par l’équation :

IodTo / dt = Φ (1)

où TO est la température océanique moyenne et où l’inertie océanique IO s’exprime en (W / m2) / (K / an).

Les échanges thermiques (Fig 6) se traduisent par des équations algébriques. Quelle que soit leur complexité, on peut toujours admettre l'existence d'approximations linéaires. Classiquement, Φ s’écrit comme suit :

Φ ≈ α1u1 + α2u2 + α3u3 - λ(TG-TE) (2)

On rappelle que les ui sont les écarts des indicateurs de facteurs de forçage par rapport à leurs valeurs nominales. Les termes ai ui sont les flux de forçages radiatifs qui en résultent, où les αi sont les coefficients de forçage radiatifs associés.

TE est la température hypothétique de surface à l’équilibre, celle qu’on observerait, en l’absence de variabilité interne, pour . Elle est inconnue, en raison notamment de l’absence de mesures directes à l’époque préindustrielle.

λ est le coefficient de rétroaction climatique, exprimant la variation du bilan radiatif sous l'effet de l'écart TG –TE.

Tous ces paramètres sont largement répandus en science climatique. Ils découlent directement du concept universellement admis de bilan énergétique.

Dans l’équation (2), la température moyenne de surface TG résulte de la version thermique de la loi d’Ohm :

TG = T0 + rΦ (3)

dans laquelle r désigne la résistance thermique de la surface, dépendant des caractéristiques de convection des couches limites atmosphériques et océaniques et des propriétés d'évapotranspiration de la surface. L’élimination de Φ entre les équations 1 à 3 conduit facilement au modèle d'état monodimensionnel :

Tclim dT0 / dt = - T0 + TE + ΣSiui (4)

TG = (1- ρ)T0 + ρTE + ρΣSiui

où

Tclim = I0(1-rλ) / λ, ρ = rλ / (1+rλ) (5)

Si = αi / λi, i = [1:3] (6)

Une formulation équivalente est la suivante :

(TG-T0) = G(s) (S1u1+ S2u2 + S3u3) (7)

dans laquelle :

G(s) = (1+ρ sTclim) / (1 + sTclim) (8)

où G(0)=1, est une transmittance de gain statique unité, et où

S1 = α1 / λ, S2 = α2/ λ, S3 = α3 / λ,

sont les sensibilités climatiques à l’équilibre vis-à- vis des indicateurs ui.

3.5. Évaluations a priori

Le modèle sera identifié sous la forme réduite (7, 8). Dans son dernier rapport, le GIEC donne des limites pour la sensibilité d'équilibre au doublement de CO2 :

1°C < Si (Prob. > 95%) , Si< 6°C (Prob. > 90%) (9)

Le GIEC ne fournit pas directement de telles limites pour la sensibilité solaire S2. Néanmoins, nous pouvons la déduire, sachant que (6) implique S2 = (α2/α1) S1 . Selon le GIEC, le forçage radiatif au doublement de CO2 est α1 ≈ 3.7 Wm− 2 ± 10 %. Dans les modèles du GIEC, l'activité solaire agit seulement par le facteur énergique, c’est à dire que α2 = 1, ceci après conversion du TSI en Irradiance Solaire Nette: NSI = (1 –0.3)/4 × TSI, où le facteur 1/4 est pour la sphéricité de la terre et la valeur 0.3 pour l'albédo terrestre moyen. En divisant l’équation (9) par α1 = 3.7, nous obtenons les limites suivantes pour la sensibilité à l'irradiation :

0.27°C / Wm-2 < S2 < 1.62°C / Wm-2 (10)

En utilisant nos indicateurs solaires basés sur SORCE/TIM, nous verrons que la limite basse identifiée pour S2 se révèlera beaucoup plus élevée que la limite supérieure ci-dessus, sauf usage de la courbe de crosse de hockey.

3.6. Variabilité interne

Tout d’abord, la variabilité naturelle du climat résulte des variations des causes autres qu’humaines (solaire, volcanique). Elle inclut, et ne se confond pas avec la variabilité interne, qui résulte principalement des turbulences inhérentes à n'importe quel écoulement fluide. Le chaos des circulations atmosphériques et océaniques provient d'un fourmillement de causes indépendantes: les fameux battements d’ailes de papillon susceptibles d'amorcer – ou non – les vastes événements météorologiques ou climatiques. Globalement, la variabilité interne est équivalente à une perturbation additive v agissant sur la sortie du modèle :

(TG-TE) = G(s) Σ[Siui] + v (11)

Cette perturbation n'est évidemment pas un bruit blanc (une séquence indépendante) et son spectre sera pris en compte, sinon dans la méthode d'identification, du moins dans le calcul de variance des paramètres estimés (cf. Annexe B).

4. Identification

4.1. Spécificité de l’identification du processus climatique

En identification, il est généralement recommandé de réserver une partie des données aux fins de validation du modèle. Pour cela, il faut, soit disposer d’expériences multiples, soit fractionner une expérimentation unique, lorsque celle-ci est de durée suffisamment longue.

L’histoire, climatique ou autre, ne se répète pas. Vu les basses fréquences impliquées dans le processus climatique, un millénaire est une durée à peine suffisante et la fractionner la rendrait inutilisable pour l’identification, en particulier en ce qui concerne l’activité solaire. Dans cette situation, la validation via le calcul des plages d’incertitudes, selon des méthodes rigoureuses revêt donc une importance particulière.

Un autre handicap tient aux fortes disparités dans les reconstructions de température et d’irradiance solaire (figures 1 et 4).

Selon les données choisies, certaines plages de d'incertitude se révéleront incompatibles les unes avec les autres (voir plus loin la figure 10-b). En absence de critères rationnels pour rejeter certaines données plutôt que d'autres, la seule attitude objective consiste à exposer l’ensemble des résultats obtenus par identification, pour les 16 combinaisons possibles (4 températures × 4 irradiances), et à laisser aux observateurs leur liberté de jugement.

4.2. Méthode

Depuis plusieurs dizaines d’années, l’identification des systèmes dynamiques est une discipline mature : Astrom and Eykoff (1971) ; de Larminat and Thomas (1977) ; Soderstrom and Stoica (1988) ; Walter and Pronzato (1997) ; Ljung, (1999) ; de Larminat (2009), chapitre 13; Landau (2001).

Dans le cas présent, les données d’identification sont pauvres en évènements et fortement perturbées. Dès lors, la méthode la plus élémentaire et la plus robuste est celle des moindres carrés d’erreur de sortie, (output error method : OE).

Le principe est immédiatement accessible, même aux non spécialistes : il consiste à simuler le modèle (ici l’équation 7), attaqué par les signaux d’entrée ui, et à ajuster les paramètres du modèle jusqu’à minimisation au sens des moindres carrés de l’écart entre la sortie simulée et la sortie observée. Avec l’OE, les données parlent librement, sans contrainte ni paramètre de réglage susceptible d’orienter les résultats : pas de paramètres probabilisés a priori, ni de structure ou de variances de bruits imposées.

Par ailleurs, un point commun à beaucoup de méthodes (AR, ARMAX, B&J, PEM, etc.) est que les caractéristiques des bruits et perturbations, sont extraites des données observées elles-mêmes. C’est une raison pour laquelle on n’exploite pas ici les intervalles de confiance qui sont souvent associées aux données climatiques.

Dans le cas présent, l’erreur de sortie résiduelle est loin d’être un bruit blanc (figure 7.b). La méthode n’est donc pas statistiquement optimale. Cela n’empêche pas de calculer la variance de l’estimateur (aux approximations classique près : normalité, ergodicité, convergence asymptotique, etc. (voir Annexe B).

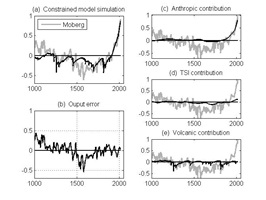

4.3. Première série de résultats

Conformément à la démarche adoptée, nous avons traité successivement toutes les combinaisons de données, mais cette section présente les résultats d’identification pour une première combinaison ponctuelle de température et d’irradiance, nommément Moberg × Usoskin-SORCE/TIM.

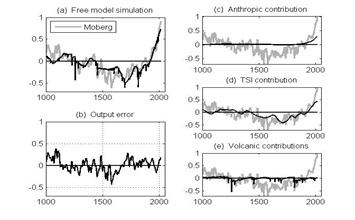

Fig. 7. Identification libre

Fig. 7. Identification libre

La figure 7 visualise (a) la sortie issue du modèle optimal, (b) l’erreur de sortie et (c, d, e) les contributions respectives des trois facteurs de forçage. Dans ces cadres, la courbe grisée montre la sortie observée (ici, Moberg).

On constate que l’erreur de sortie est importante. Elle est néanmoins comparable à celle des simulations millénaires des modèles du GIEC (voir par exemple AR5, 2013, fig. 1(b), p. 78). Elle résulte non seulement des bruits et erreurs de reconstruction ou des erreurs d’identification, mais essentiellement de la variabilité interne du climat (section 3.6), par nature irréductible. Cette dernière composante n’est pas un bruit blanc, en ce sens qu’elle n’est pas une séquence indépendante identiquement distribuée (idd).

Finalement, la contribution anthropique récente s’avère être inférieure à la contribution de l’activité solaire (cadres c et d). Admettant en effet la prépondérance de la variabilité interne dans l’erreur de sortie, la contribution naturelle (activités solaire et volcanique, plus variabilité interne) devient très largement supérieure à la contribution anthropique.

Rappelons que les contributions montrées dans la figure 7 sont spécifiques à notre première combinaison de données. On ne doit donc pas généraliser prématurément ces conclusions.

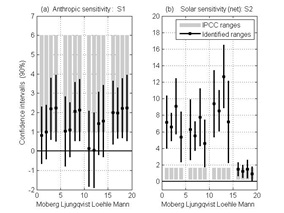

4.4. Tests d’hypothèses

Une autre façon d’exploiter les techniques d’identification consiste à effectuer des identifications forcées, sous les hypothèses dont on souhaite tester le bien fondé. Selon le GIEC, l’activité solaire intervient exclusivement par l’intermédiaire du flux total d’irradiance solaire, avec une sensibilité solaire S2 < 1.62°C / Wm-2 (équation 10).

Fig. 8. Identification sous contrainte

Fig. 8. Identification sous contrainte

Comme on peut le prévoir,une identification effectuée sous cette contrainte conduit à une contribution solaire insignifiante (figure 8-d) et le réchauffement récent est en quasitotalité attribué au facteur anthropique (cadre c).

Certaines indications conduisent à mettre en doute cette hypothèse:

- Dans l'identification libre, l'activité solaire contribue à expliquer la période chaude médiévale et le petit âge glaciaire. Ce n'est pas le cas dans identification sous contrainte (figure 8).

- En conséquence, les erreurs de sortie augmentent de manière visible au cours de ces périodes.

- Il apparaît une inter-corrélation significative (non reportée ici) entre l'indicateur d'activité solaire et l'erreur de sortie, signe d'une causalité non prise en compte.

Des évaluations visuelles n’étant pas des preuves formelles, des tests d'hypothèse s’imposent, pour confirmer si les erreurs de sortie augmentent vraiment significativement, impliquant un rejet de l'hypothèse. Les tests statistiques, basés sur les écarts évalués (Annexe B) montrent que : l’hypothèse d’une faible sensibilité à l’activité solaire doit être rejetée avec un niveau de probabilité supérieur à 90%.

De la même façon on peut tester l'hypothèse d'une sensibilité anthropogénique basse, à la limite S1 = 0. Alors, la reproduction du réchauffement récent est significativement dégradée, mais l’évaluation de la variabilité interne reste comparable avec les valeurs millénaires. Un test d'hypothèse le confirme : avec un niveau de probabilité de 90 %, on ne peut pas rejeter l'hypothèse d'une contribution anthropogène nulle. Autrement dit : la combinaison actuelle de données d'observation infirme l’allégation du GIEC selon laquelle, avec un niveau de probabilité de 95 %, la contribution anthropogène au réchauffement récent est prédominante.

4.5. Résultats d’ensemble

Les résultats précédents sont ponctuels, basés sur une combinaison de données particulière. Plutôt que de détailler des résultats similaires, contributions et tests pour les autres combinaisons, la figure 9 se limite à présenter les évaluations de S1 et S2, avec leurs intervalles de confiance à 90 %, calculés à partir des 16 combinaisons de données. Ils sont groupés en quatre sous-ensembles, relatifs aux reconstructions respectives de Moberg, Ljungqvist, Loehle et Mann. Chaque groupe est subdivisé selon les quatre reconstructions d'irradiance solaire (Section 2.5). Les segments gris montrent les gammes de sensibilité selon le GIEC (Équations 9 et 10).

Fig. 9. Intervalles de confiance

Fig. 9. Intervalles de confiance

La figure 9-b montre clairement une forte disparité entre les intervalles de confiance résultant de l'utilisation de la reconstruction de Mann et ceux des trois premiers. Or, seule cette dernière confirme les domaines de confiance du GIEC, tant pour la sensibilité anthropique que la sensibilité solaire.

Ce n’est pas une raison pour de rejeter a priori la reconstruction de Mann : la vérité scientifique ne se détermine pas à la majorité. Le graphique en crosse de hockey est apparu à plusieurs reprises dans les précédents rapports du GIEC et il est toujours largement utilisé dans beaucoup de vulgarisations en rapport avec le changement climatique. Mais on ne peut pas ignorer qu’elle a l’objet de controverses sérieuses ; il doit également être relevé que le GIEC ne la mentionne plus dans aucune des 1550 pages de son rapport de 2013, même dans le chapitre 5 dédié aux Archives Paléoclimatiques.

Si, suivant l’exemple du GIEC, nous écartons la reconstruction de Mann, les trois premières reconstructions (Moberg, Ljungqvist, Loehle), conduisent aux conclusions suivantes :

Au sujet de la sensibilité anthropique :

Les conclusions partielles de 4.3 et 4.4 ne se retrouvent pas systématiquement. Globalement, la limite basse S2 < 1.62°C / Wm-2 ne peut ni être confirmée, ni infirmée. Cela dépend des reconstructions de TSI. Mais dans tous les cas, la limite haute Si < 6°C apparait irréaliste.

Au sujet de la sensibilité solaire :

Les trois premières reconstructions conduisent à rejeter l'hypothèse du GIEC d'une faible sensibilité à l'activité solaire.

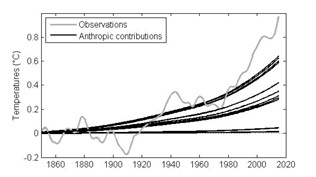

Fig. 10. Contribution anthropique au changement climatique

Fig. 10. Contribution anthropique au changement climatique

Deux explications se présentent. La première pourrait être l'existence de mécanismes d'action solaire autres que le facteur énergétique, seul retenu par le GIEC ; la seconde pourrait être une évaluation trop basse de la valeur du composant LF dans la reconstruction SORCE/TIM, utilisée comme référence dans la Section 2.5. Si on adopte une reconstruction où la composante LF est renforcée, comme chez Shapiro et al. (2011), la gamme de sensibilité identifiée pourrait devenir comparable avec celle du GIEC.

Maintenant, le plus important n'est pas la valeur du coefficient S2, mais de savoir si la contribution de facteurs naturels prévaut sur la contribution humaine. Dans la figure 10, douze simulations (celles issues de Mann étant à nouveau écartées) montrent les contributions anthropogéniques sur le dernier siècle. Le plus souvent, l'affirmation du GIEC n'est pas confirmée selon laquelle l’essentiel du réchauffement observé pendant la deuxième moitié du 20ème siècle est principalement d’origine humaine. Dans certains cas, elle apparait même négligeable.

Pour aller plus loin, d'autres analyses plus raffinées pourraient utilement être exploitées, par exemple (Faivre, Iooss, Mahevas, Makowski et Monod, 2013). De toute façon, on peut penser que les conclusions susdites sont robustes : elles restent pratiquement identiques à celles de nos travaux antérieurs (de Larminat, 2014), malgré des changements quantitatifs et qualitatifs substantiels, notamment de données et de structure de modèle.

5. Détection et attribution

5.1. Commentaires préliminaires au ”Good practice guidance paper on detection and attribution”

D’une façon générale, la détection concerne l’existence d’un phénomène potentiellement masqué par des fluctuations aléatoires; tandis que l'attribution spécifie, ou même quantifie les causes. La D&A opère sur la base d’observations climatiques et de modèles climatiques prédéterminés (GMC ou EBM). Contrairement à l'identification, la D&A ne cherche pas à remanier ou réajuster ces modèles. Notons que le changement climatique induit par l’homme est posé en principe, comme l’indique le titre complet « Good practice guidance paper on detection and attribution related to anthropogenic climate change » (Hegerl, 2010). À noter que l’expression anthropogenic climate change, fait écho à la mission du GIEC: « expertiser les informations scientifiques, techniques et socio-économiques pertinentes pour comprendre les risques liés au changement climatique d’origine humaine» (http://www.ipcc.ch/pdf/ipcc-principles/ipcc-principles.pdf).

Ce « Good Practice Guidance Paper » (GPGP), est pour une bonne part un recueil d’éléments de langage à destination des rédacteurs du rapport AR5 – alors en préparation. Il comporte un compendium de définitions : ainsi, le terme forçage externe désigne les causes extérieures au système climatique vu dans son ensemble (typiquement les actions humaines, solaires ou volcaniques), tandis que la dénomination facteur externe est à usage plus général (e.g., “la réduction de la banquise agit comme un facteur externe sur les populations d’ours polaires”).

Il introduit la notion de facteur de confusion “qui peut masquer ou distordre les effets des forçages ou facteurs externes ”. Une longue liste inclut les items suivants : “… incertitudes et erreurs de modèle ; représentations omises ou impropres des forçages dans les modèles de climat et d’impact ; différences structurelles dans les techniques méthodologiques ; variabilité interne incertaine ou non prise en compte[2] … ”. Chacun des points ci-dessus mériterait des développements : il ne suffit pas de mettre en garde contre des confusions pour garantir que la D&A soit à même d’éviter cet écueil. Ainsi, la “non prise en compte de la variabilité interne” serait un facteur de confusion. On se demande au contraire si ce n’est pas “la prise en compte” plutôt que la non prise en compte de la variabilité interne qui constitue une confusion manifeste entre cause et effet (section 5.5).

Le GPGP fait la liste de diverses méthodes de D&A : attribution à des forçages externes (mono ou multi-étape : selon que la chaîne de causalité est simple ou multiple) ; attribution d’empreinte associée ; attribution à des changements de conditions climatiques, “qui peuvent être l’étape ultime de l’attribution multi-étape ”. Cette dernière incidente est importante : Le GPGP souligne que ”l'évaluation globale sera généralement analogue ou plus faible que le maillon le plus faible”.

Dans le Résumé pour les Décideurs (SPM), on trouve une énumération de 12 effets climatiques attribués à l’influence anthropique. En premier lieu le réchauffement global lui-même. Viennent ensuite, la fonte des banquises, l’augmentation du niveau des mers, la fréquence des évènements extrêmes, les vagues de chaleur, etc. Dans le chapitre 10 de l’AR5, environ soixante contributeurs accumulent des douzaines d’autres exemples d’attribution, donnant ainsi matière à environ 700 références bibliographiques, citées par une soixantaine de contributeurs. Or l’immense majorité des attributions présentées relève de l’attribution multi-step et fait intervenir le réchauffement global en tant qu’étape finale. Si le maillon faible est l’attribution du réchauffement global à l’activité humaine, la réalité de toutes ces attributions devient problématique, et leur accumulation ne constitue évidemment en rien des preuves multiples de l’influence humaine sur le climat.

Dans ce contexte, nous allons donc nous limiter exclusivement par la suite à évaluer la validité de l’attribution du réchauffement global par la D&A.

5.2. Principes de la D&A par fingerprinting

Un des principaux outils utilisés en D&A a pour nom « optimal fingerprinting », concept apparu dans les années 90 (Hasselman, 1993). Le principe est le suivant (voir par exemple Hegerl, G., & Zwiers, F. 2011).

S’agissant ici de la température globale, on définit des fingerprints (empreintes ou patterns) comme les variations Xi de la température simulée, en réponse aux variations des signaux ui de forçage observés, considérés indépendamment. Les modèles de simulation peuvent être aussi bien les grands modèles numériques de circulation générale (GCM), que des modèles simples à bilan énergétiques. Contrairement à la démarche de l’identification, ces modèles sont définis a priori, et la D&A n’a pas pour objet de les réajuster. Par explicitation de l’hypothèse linéaire, on écrit:

y = X1 + X2 + X3 +v (12)

où y est la température globale observée, Xi les fingerprints associés aux indicateurs de forçage respectifs (par exemple les actions humaines, solaires et volcaniques), et v la variabilité climatique interne résultant de fluctuations aléatoires ou d'autres causes non répertoriées. Compte tenu des erreurs de modèle, on écrit :

y = Xa +v (13)

où X = [X1 X2 X3], et où a est un vecteur de facteurs d’échelle, en principe égaux à 1 (éq. 9). On en détermine une estimation par régression linéaire (BLUE : Best Linear Unbiased Estimate):

â = (XTC-1X)-1 XT C-1y (14)

La matrice C est ici la covariance de la variabilité interne, sur la détermination de laquelle on reviendra. La variance des estimations est donnée par l’expression (XTC-1X)-1, de laquelle on peut déduire les intervalles de confiance associés aux estimations . Selon que les intervalles estimés recouvrent ou non les valeurs 0 ou 1, on détectera – ou non, et/ou on attribuera – ou non – les changements observés sur y aux divers facteurs de forçage considérés.

5.3. Rapports avec l’identification

La D&A permet de faire appel aux grands modèles numériques de circulation générale, et par là de considérer des phénomènes régionaux ou ponctuels, ignorés des modèles « boîtes noires ». Par contre, si on se restreint à la question fondamentale de l’attribution du réchauffement global, les rapports de la D&A avec l’identification telle que nous l’avons pratiquée sont tellement étroits qu’on devrait s’attendre à ce qu’ils conduisent aux mêmes conclusions.

Reconsidérons en effet notre structure de modèle (équation 7) :

(TG-T0) = G(s) (S1u1+ S2u2 + S3u3) (7)

Les fingerprints correspondants ne sont alors rien d’autre que les contributions des différentes entrées à la sortie simulée, pour un modèle entièrement déterminé a priori, sensibilités comprises.

Alors, le vecteur obtenu par optimal fingerprinting (éq. 14) permettrait d’effectuer un réajustement des sensibilités, par multiplication des valeurs a priori Si par les facteurs âi . La principale différence entre notre identification et la D&A est que cette dernière maintient la transmittance G(s) hors du champ de l’identification. Dans les GCM, les sensibilités n'apparaissent pas explicitement. Le D&A ne peut donc pas conduire à une identification à proprement parler. A ce détail près, il n’y a pas de différence fondamentale entre les déductions à base de D&A et celles qui sont effectuées à l’issue de l’identification, par tests d’hypothèses et domaines de confiance.

Par nature, l’identification présente l’avantage de tenir compte des incertitudes sur les transitoires modélisés par G(s), tandis que la D&A prétend seulement y être robuste : « L’attribution n’exige ni n’implique que chaque aspect de la réponse au facteur causal en question soit correctement simulé » (AR5, p 873). Si on veut bien l’admettre, il faut chercher ailleurs l’explication des conclusions diamétralement opposées entre la D&A et l’identification.

Les variantes techniques mineures, telles que OE vs. BLUE ne constituent pas une explication suffisante. En fin de compte, l’explication tient avant tout aux données utilisées, à leurs durées et à leurs natures.

5.4. Périodes d’observation

La quasi-totalité des études de D&A porte sur des observations climatiques débutant après 1850, parfois même bien après (1979). Ces durées sont beaucoup trop courtes.

Une première raison tient à l’estimation des caractéristiques statistiques de la variabilité climatique interne (la matrice C de la section 5.2), indispensable pour détecter si une variation émerge au-dessus du niveau de la variabilité interne. Celle-ci peut être déterminée par des simulations de modèles de circulation générale, qui reproduisent « naturellement » les chaos atmosphériques et océaniques, premiers responsables de la variabilité interne. Se pose alors la question de la capacité de ces modèles à reproduire effectivement la variance et surtout le spectre en basse fréquence de cette variabilité.

Ces caractéristiques peuvent aussi être déterminées empiriquement, à partir du résidu v = y - Xâ. Les rédacteurs du chapitre 10 de l’AR5 manifestent quelque gêne et incohérence à ce sujet : “It is difficult to evaluate internal variability on multi-decadal time scales (1950-2010) in observations given the shortness of the observational record and the presence of external forcing” (p. 881). “… it is difficult to validate climate models’ estimates of internal variability over such a long period” (1861-2010), p. 882.

La deuxième raison est que les données paléoclimatiques existent bel et bien et que l’on ne peut se permettre de les ignorer. Les observations millénaires suggèrent en effet une relation causale entre l’activité solaire et la température globale. Le rôle de l’identification, comme de la D&A, est d’évaluer la validité de cette suggestion par l’analyse statistique. En se limitant à une échelle centennale, le GIEC minimise le risque de l’attribution du réchauffement récent à l’activité solaire au détriment de l’influence humaine. Par contre, en retenant des données millénaires, la D&A conduirait nécessairement à des conclusions similaires aux nôtres.

5.5. Un facteur de confusion : El Niño

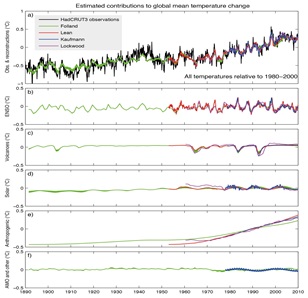

Figure 11 : reproduiction de la figure 10.6 de AR5

Figure 11 : reproduiction de la figure 10.6 de AR5

La variabilité interne résulte principalement du chaos océanique, par la circulation thermohaline, (dénommée aussi MOC : Meridional Overturning Circulation). Le moteur de cette circulation est la plongée des eaux refroidies et densifiées dans les régions polaires. Elles se dispersent et se propagent au fond des océans avant de resurgir, entre autres, au voisinage des côtes Est du Pacifique. Les aléas de la circulation atmosphérique peuvent bloquer plus ou moins longtemps ces résurgences froides, dont l’absence induit alors un réchauffement plus ou moins temporaire. C’est le phénomène El Niño (La Niña se réfère à la situation inverse).

L’intensité des épisodes El Niño est évaluée à travers l’indice ENSO (El Niño Southern Oscillation Index, ou SOI), constitué d’un panier de mesures de pressions, de températures atmosphériques et océaniques, et de vitesses de vent, etc. Une forte corrélation entre l’indice ENSO et les variations ultérieure à court terme de température globale est reconnue, et constitue tout l’intérêt de cet indice.

L’indice ENSO est couramment assimilé à un facteur externe par divers auteurs: Lockwood (2008), Lean (2009), Folland (2010), Kaufmann (2011). Une synthèse de leurs travaux a été effectuée par Imbers Lopez, Huntingford, and Allen (2013), et reprise dans l’AR5. La figure 11 reproduit la figure 10.6 de AR5 [3]. Elle est critiquable à plusieurs égards.

On observe que les contributions anthropiques au réchauffement global sont prépondérantes (cadre d). D’entre elles, la plus faible est celle de Folland, qui porte sur la plus longue durée d’observation :1890-2010 ; Les autres commencent dans les années 1950 ou même plus tard. Clairement, plus la durée se limite à la période récente, plus la corrélation entre le réchauffement et l'activité humaine prédomine. Au contraire, une attribution basée sur des observations millénaires inverserait vraisemblablement les résultats de la D&A, conformément aux résultats de l'identification.

Il y a plus grave : l’assimilation de l’indice ENSO (ou similaires : AMO, SAO, AO) à des forçages externes. Rappelons que ces indices sont constitués de paniers de mesures climatiques. Chacun d'entre eux est un effet des véritables forçages externes, et une combinaison d'effets ne peut en aucun cas être considérée comme une cause pour le système climatique dans son ensemble. En réalité, comme indiqué en 3.6, la variabilité interne résulte d'un fourmillement de causes élémentaires indépendantes, mais lorsqu'un effet mesurable apparaît, il dépend aussi de l'état climatique global ou régional, qui résulte lui-même des causes externes réelles.

Ce n’est pas parce que le chaos océanique ou atmosphérique intervient dans l’apparition d’El Niño que celui-ci est assimilable à une perturbation indépendante : les résurgences sont modulées par le niveau moyen de la thermocline, lui même variable avec la quantité totale de chaleur océanique. Celle-ci est déterminée par le bilan radiatif, qui est fonction d’abord des forçages externes. On ne pourrait le considérer comme une cause (au sens d’un signal extérieur) que vis-à-vis d’un sous-système, à délimiter au sein d’une décomposition du processus climatique en sous systèmes interconnectés par diverses boucles de réaction. Dès lors, traiter El Niño de la même façon qu'un forçage externe est une erreur méthodologique lourde, qui saute aux yeux de n'importe quel expert en science des systèmes.

Le GIEC a pourtant connaissance de nombreux travaux portant sur la dépendance de l’ENSO, et plus généralement des signaux climatiques du pacifique tropical, vis-à-vis de l’activité solaire comme l’attestent les références suivantes :

- van Loon, Meehl, and Shea, 2007 : “This then is physically consistent with the mechanisms that link solar forcing to a strengthening of the climatological mean circulation and precipitation features in the tropical Pacific”;

- van Loon and Meehl, 2008 “in solar peak years the sea level pressure (SLP) is, on average, above normal in the Gulf of Alaska and south of the equator”;

- White and Liu, 2008 “we find most El Nino and La Nina episodes from 1900–2005… Here we find these alignments replicated in both coupled general circulation model and conceptual model driven by 11-yr solar forcing”;

- Meehl, Arblaster, Matthes, Sassi, and van Loon, 2009 “One of the mysteries regarding Earth’s climate system response to variations in solar output is how the relatively small fluctuations of the 11-year solar cycle can produce the magnitude of the observed climate signals in the tropical Pacific associated with such solar variability”;

- Tung and Zhou, 2010 “It is noted that previous reports of a coldtongue (La Nina–like) response to increased greenhouse or to solar-cycle heating were likely caused by contaminations due to the dominant mode of natural response in the equatorial Pacific”;

- Roy and Haigh, 2010 “An important aspect of our paper is to point out that the timing is crucial to show how this produces apparent discrepancies between different analyses and how it may be used to test mechanisms proposed to explain solar-climate links, in the context of ENSO variability”;

- Roy, I., & Haigh, J. D. (2012). Both the SLP and SST signals vary coherently with the solar cycle and neither evolves on an ENSO-like time scale;

- Bal, Schimanke, Spangehl, and Cubasch, 2011 “there is evidence for a La Niña-like response assigned to solar maximum conditions”;

- Haam and Tung, 2012 “The solar peak years can coincide with cold ENSO by chance, even if the two time series are independent”;

- Hood and Soukharev, 2012 “the tropical lowerstratospheric response is produced mainly by a solar-induced modulation”;

- Misios and Schmidt, 2012. “the tropical Pacific Ocean should warm when the sun is more active”.

Toutes les références ci-dessus sont extraites de l’AR5 (Box 10.2: The Sun’s Influence on the Earth’s Climate). Elles sont censées confirmer l’assertion suivante: « it can be difficult to discriminate the solar-forced signal from the El Niño-Southern Oscillation (ENSO) signal ». En fait, cette formulation dénature la substance de l’ensemble de ces travaux cités (à l’exception de la neuvième) : la question n’est pas de discriminer entre deux signaux plus ou moins similaires, mais bien de reconnaitre que le signal ENSO n'est pas une cause externe indépendante et qu'il est injustifiable de l'introduire, comme dans la figure 11, avec le même statut que les forçages externes réels. Il a pour effet de minimiser la contribution d'activité solaire, déjà sous-estimée par l’omission les observations millénaires. Au contraire, la méthode d'identification proposée ci-dessus détecte clairement une forte contribution d'activité solaire dans les variations climatiques récentes.

6. Conclusions

Les modèles de circulation générale constituent un instrument extrêmement puissant pour l’étude du système climatique. Ils incorporent malheureusement encore beaucoup de représentations empiriques, concernant des phénomènes auxquels le climat est extrêmement sensible, entre autres ceux qui font intervenir les nuages. II est possible aussi que certains mécanismes climatiques soient encore totalement inconnus, en particulier ceux qui ont trait à l’activité solaire.

Ces modèles demandent donc à être validés par des observations. S’il s’agit des températures globales, les modèles doivent être évalués d’abord en fonction de leurs capacités à reproduire les évolutions passées de celle-ci. L’approche par « détection et attribution », préconisée par le GIEC, appliquée au réchauffement global constitue une tentative en ce sens, mais elle ne nous apparaît pas convaincante, pour toutes les raisons exposées en sections 5.4 et 5.5.

La première est la restriction systématique des observations à la période « historique » (post 1850), si ce n’est à la période « spatiale » (post 1979), laissant tomber ainsi des données paléoclimatiques incontournables malgré leurs imperfections.

La seconde tient à une erreur systémique flagrante, relative à l’usage des indices de variabilité (ENSO, AMO ou autres). Lorsqu’il y a confusion entre cause et effet, on voit mal comment accorder quelque crédit aux conclusions qui en résultent.

La troisième est que les conclusions de la D&A sont contredites par celles de l’identification du système climatique (sections 2 à 5). Les données d’observation étant ce qu’elles sont, les performances de l’identification sont loin d’atteindre celles que l’on obtient dans des contextes plus favorables. Néanmoins, les domaines de confiance paramétriques et les tests d’hypothèses associés à l’identification permettent la confrontation directe avec la D&A. Il apparaît que, malgré la dispersion des jeux d’observation utilisés, la thèse d’une contribution prépondérante de l’activité humaine au réchauffement climatique doit être abandonnée pour

Annexe A. Décomposition en trois composantes

La décomposition d'un signal (solaire) y en ses trois composantes est obtenue ici par un lissage de Rauch-Tung Striebel (RTS) (voir par exemple Simo Sarkka, 2013). Elle est basée sur le modèle stochastique suivant :

y = y1 + y2 + y3

dy13 / dt3 = w1

dy22 / dt2 + 2π / 11) y2 = w2

y3 = w3

dans lesquels les wi sont supposés être des bruits blancs indépendants gaussiens, dont les spectres de puissance sont les paramètres de synthèse de l'algorithme.

Annexe B. Estimation de la variance du paramètre de probabilité

Explicitons la dépendance d’une sortie observée y d'un processus avec un vecteur θ de paramètres en écrivant :

y = f(θ) + v

où

- y = [y1... yt... yN]T est la séquence de sorties observées, du temps t = 1 à t = N

- f(θ) = [f1(θ)... ft(θ)... fNθ)]T est la séquence des sorties qui résulteraient de la simulation du modèle exact attaqué par les entrées observées.

- v=[v1... vt.... vN]T représente les bruits et les perturbations agissant sur l’entrée, y compris ceux provenant d'erreurs d’entrées. Cette séquence est présumée répondre à une distribution normale, ergodique et centrée, mais non indépendante.

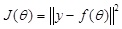

L’estimation par OE est celle qui minimise le critère :

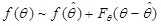

Autour de l'évaluation optimale, le développement au premier ordre de la fonction f(θ) s’écrit :  où Fθ est la matrice jacobienne des dérivées partielles de f. À l'optimum, le gradient Jθ de J(θ) est nul.

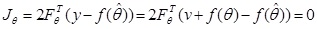

où Fθ est la matrice jacobienne des dérivées partielles de f. À l'optimum, le gradient Jθ de J(θ) est nul.

Il se développe en :

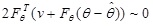

On remplace f(θ) par son développement. Il vient :

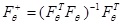

Définissons Fθ+ comme la pseudo-inverse de Fθ :

La pré-multiplication de l’équation précédente par (FθT Fθ)-1 conduit à l’erreur d’estimation :

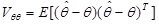

La variance de l’erreur  est donc approximativement:

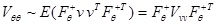

est donc approximativement:  où Vvv = E(vvT)

où Vvv = E(vvT)

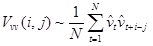

Pour exploiter cette expression, la matrice Jacobienne Fθ est calculée par différences finies, en effectuant n simulations, faisant varier successivement chaque composante : . Conformément à l'hypothèse d’ergodicité, la matrice des erreurs Vvv peut être calculée en utilisant la fonction d'autocorrélation des résidus  :

:

Une fois déterminée la variance Vθθ , on peut effectuer n'importe quelle analyse classique : échelle d'incertitude, tests paramétriques, etc.

References

Åström, K. J., & Eykhoff, P. (1971). System identification—a survey. Automatica, 7(2), 123-162.

AR5, 2013 : Stocker, T. F., Qin, D., Plattner, G. K., Tignor, M., Allen, S. K., Boschung, J., ... & Midgley, B. M. (2013). IPCC, 2013: climate change 2013: the physical science basis. Contribution of working group I to the fifth assessment report of the intergovernmental panel on climate change.

Bal, S., S. Schimanke, T. Spangehl, and U. Cubasch, 2011: On the robustness of the solar cycle signal in the Pacific region. Geophys. Res. Lett., 38, L14809.

Clette, F., Svalgaard, L., Vaquero, J.M., Cliver, E.W., 2015. Revisiting the sunspot number. The solar activity cycle. Springer, New York, 35–103

Crowley, T. J. and M. B. Unterman, 2013, Technical details concerning development of a 1200-yr proxy index for global volcanism. Earth System Science Data, Vol. 5.

de Larminat, P. et Y. Thomas, 1977. Automatique des systèmes linéaires 2. Identification, Flammarion.

de Larminat, P. (2009). Automatique appliquée, Paris, Lavoisier.

de Larminat, P. (2014). Climate change, Identification and projections, London, Wiley & Sons.

Delaygue, G. and E. Bard. 2010. An Antarctic view of Beryllium-10 and solar activity for the past millennium. Climate Dynamics, Published online 1 April 2010.

Faivre, R., Iooss, B., Mahevas, S., Makowski, D., Monod, H., 2013. Analyse de sensibilite et exploration de modeles: Application aux sciences de la nature et de l'environnement. Editions Quae, Paris.

Folland, C. K., et al., 2013 High predictive skill of global surface temperature a year ahead. Geophys. Res. Lett., 40, 761–767.

Forssell, U., & Ljung, L. (1999). Closed-loop identification revisited. Automatica, 35(7), 1215-1241.

Haam, E., and K. K. Tung, 2012: Statistics of solar cycle-La Niña connection: Correlation of two autocorrelated time series. J. Atmos. Sci., 69 2934–2939.

Hasselmann K (1993) Optimal fingerprints for the detection of timedependent climate change. J Clim 6(10):1957–1971

Hegerl, G. C., Hoegh-Guldberg, O., Casassa, G., Hoerling, M. P., Kovats, R. S., Parmesan, C., ... & Stott, P. A. (2010). Good practice guidance paper on detection and attribution related to anthropogenic climate change. In Meeting Report of the Intergovernmental Panel on Climate Change Expert Meeting on Detection and Attribution of Anthropogenic Climate Change (p. 8). IPCC Working Group I Technical Support Unit, University of Bern, Bern, Switzerland.

Hegerl, G., & Zwiers, F. (2011). Use of models in detection and attribution of climate change. Wiley Interdisciplinary Reviews: Climate Change, 2(4), 570-591.

Hood, L. L., and R. E. Soukharev, 2012: The lower-stratospheric response to 11-yr solar forcing: Coupling to the troposphere-ocean response. J. Atmos. Sci., 69, 1841–1864.

Imbers, J., A. Lopez, C. Huntingford, and M. R. Allen, 2013: Testing the robustness of the anthropogenic climate change detection statements using different empirical models. J. Geophys. Res. Atmos.

Kaufmann, R. K., H. Kauppi, M. L. Mann, and J. H. Stock, 2011: Reconciling anthropogenic climate change with observed temperature 1998–2008. Proc. Natl. Acad. Sci. U.S.A., 108, 11790–11793.

Kopp, G., & Lean, J. L. (2011). A new, lower value of total solar irradiance: Evidence and climate significance. Geophysical Research Letters, 38(1).

Landau, I.D. (2001). Identification des systèmes. Hermès science publications.

Lean, J. 2004. Solar Irradiance Reconstruction. IGBP PAGES/World Data Center for Paleoclimatology Data Contribution Series # 2004-035. NOAA/NGDC Paleoclimatology Program, Boulder CO, USA.

Lean, J. L., and D. H. Rind, 2009: How will Earth’s surface temperature change in future decades? Geophys. Res. Lett., 36, L15708.

Ljung, L. (1998). System identification (pp. 163-173). Birkhäuser Boston.

Ljungqvist, F.C. 2009. N. Hemisphere Extra-Tropics 2,000yr Decadal Temperature Reconstruction. IGBP PAGES/World Data Center for Paleoclimatology Data Contribution Series # 2010-089. NOAA/NCDC Paleoclimatology Program, Boulder CO, USA.

Lockwood, M., and C. Fröhlich, 2008: Recent oppositely directed trends in solar climate forcings and the global mean surface air temperature: II. Different reconstructions of the total solar irradiance variation and dependence on response time scale. Proc. R. Soc. London A, 464, 1367–1385.

Loehle, C., 2007, “A 2000-years global temperature reconstruction based on non-treering proxies”, Energy & Environment, Vol. 18, No. 7+8

Mann, Michael E., Raymond S. Bradley, and Malcolm K. Hughes. (1999) "Northern hemisphere temperatures during the past millennium : Inferences, uncertainties, and limitations." Geophysical Research Letters 26: 759-762.

Meehl, G. A., J. M. Arblaster, K. Matthes, F. Sassi, and H. van Loon, 2009: Amplifying the Pacific climate system response to a small 11-747year solar cycle forcing. Science, 325 1114–1118.

Meinshausen, M., Raper, S. C. B., & Wigley, T. M. L. (2011). Emulating coupled atmosphere-ocean and carbon cycle models with a simpler model, MAGICC6–Part 1: Model description and calibration. Atmospheric Chemistry and Physics, 11(4), 1417-1456.

Misios, S., and H. Schmidt, 2012: Mechanisms involved in the amplification of the 11-yr solar cycle signal in the Tropical Pacific ocean. J. Clim., 25, 5102–5118.

Moberg, A., et al. 2005. 2,000-Year Northern Hemisphere Temperature Reconstruction. IGBP PAGES/World Data Center for Paleoclimatology Data Contribution Series # 2005-019. NOAA/NGDC Paleoclimatology Program, Boulder CO, USA.

Roy, I., and J. D. Haigh, 2010: Solar cycle signals in sea level pressure and sea surface temperature. Atmos. Chem. Phys., 10 3147–3153.

Roy, I., & Haigh, J. D. (2012). Solar cycle signals in the Pacific and the issue of timings. Journal of the Atmospheric Sciences, 69(4), 1446-1451.

Sarkka, S., 2013. Bayesian filtering and smoothing (vol. 3). Cambridge University Press.

Shapiro, A.I., Schmutz, W., Rozanov, E., Schoell, M., Haberreiter, M., Shapiro, A.V., Nyeki, S., 2011. A new approach to the long-term reconstruction of the solar irradiance leads to large historical solar forcing. Astronomy & Astrophysics 529, A67.

Söderström, T., & Stoica, P. (1988). System identification. Prentice-Hall, Inc..

Tung, K.-K., and J. Zhou, 2010: The Pacific’s response to surface heating in 130 yr of SST: La Niña-like or El Niño-like? J. Atmos. Sci., 67, 2649–2657.

Usoskin, I.G., M. Korte, and G.A. Kovaltsov. 2008. Role of centennial geomagnetic changes in local atmospheric ionization. Geophys. Res. Lett., Vol. 35, L05811.

van Loon, H., G. A. Meehl, and D. J. Shea, 2007: Coupled air-sea response to solar forcing in the Pacific region during northern winter. J. Geophys. Res. Atmos., 112, D02108.

van Loon, H., and G. A. Meehl, 2008: The response in the Pacific to the sun’s decadal peaks and contrasts to cold events in the Southern Oscillation. J. Atmos. Sol. Terres. Phys., 70 1046–1055.

Walter, E., & Pronzato, L. (1997). Identification of parametric models. Communications and Control Engineering, 8.

White, W. B., and Z. Y. Liu, 2008: Non-linear alignment of El Nino to the 11-yr solar cycle. Geophys. Res. Lett., 35, L19607.

[1] Lien libre accès en anglais : http://www.sciencedirect.com/science/article/pii/S1367578816300931

[2] C’est nous qui soulignons

[3] From Imbert et al. (2013). (Top) The variations of the observed global mean surface temperature anomaly (HadCRUT3), and the best multivariate fits using the method of Lean , Lockwood, Folland and Kaufmann. (Below) The contributions to the fit from (a) El Niño-Southern Oscillation (ENSO), (b) volcanoes, (c) solar forcing, (d) anthropogenic forcing and (e) other factors (Atlantic Multi-decadal Oscillation (AMO) for Folland and a 17.5-year cycle, semi-annual oscillation (SAO), and Arctic Oscillation (AO) from Lean)