Les sciences qui traitent de systèmes complexes, le système climatique par exemple, ont besoin de faire appel à des modèles que ce soient des modèles numériques très utilisés par le Giec, ou des modèles par identification utilisés par les systémiciens. Dans tous les cas, une des grandes difficultés est celle du « réglage » des paramètres du modèle (en anglais « tuning »). Un membre du Giec, Frédéric Hourdin[1], est réputé pour sa bonne connaissance des difficultés rencontrées par les techniques de modélisation. Il est cité à plusieurs reprises, dans le journal du CNRS, dans une série d’articles intitulés « Évolution du climat: peut-on se fier aux modèles ? ». Il explique la prudence dont il faut faire preuve pour tirer des conclusions à partir des modèles numériques.

Les sciences qui traitent de systèmes complexes, le système climatique par exemple, ont besoin de faire appel à des modèles que ce soient des modèles numériques très utilisés par le Giec, ou des modèles par identification utilisés par les systémiciens. Dans tous les cas, une des grandes difficultés est celle du « réglage » des paramètres du modèle (en anglais « tuning »). Un membre du Giec, Frédéric Hourdin[1], est réputé pour sa bonne connaissance des difficultés rencontrées par les techniques de modélisation. Il est cité à plusieurs reprises, dans le journal du CNRS, dans une série d’articles intitulés « Évolution du climat: peut-on se fier aux modèles ? ». Il explique la prudence dont il faut faire preuve pour tirer des conclusions à partir des modèles numériques.

Il est surtout le coauteur d’une publication intitulée « The Art and Science of Climate Model Tuning » (L’art et la science du réglage des modèles climatiques) parue le 9 juillet 2016 dans la revue en ligne de l’American Meteorological Society (AMS). Il y explique que 23 des principaux centres de modélisation climatiques ont été interrogés « pour savoir comment ils ajustent les modèles ». La réponse est étonnante : « 22 des 23 groupes ont déclaré avoir ajusté les paramètres du modèle pour obtenir les propriétés souhaitées ». On est donc loin d’une méthode scientifique qui ne devrait pas préjuger des résultats.

Ce qui fait de Frédéric Hourdin un cas étrange, c’est que, malgré sa lucidité, il continue à croire à la cause anthropique de la période chaude contemporaine. Pourquoi cette contradiction ? Très probablement pour une raison simple : il ne remet pas en cause la période d’observation de seulement 150 ans que s’impose le Giec, alors qu’un modèle, pour quantifier des relations de cause à effet devrait a minima retenir au moins 1000 ans de variations climatiques.

Nous résumons ici un certain nombre de points concernant le paramétrage des modèles.

Commentaires: "les2ailes.com"

1- Peut-on se fier aux modèles ?

Le couplage de plusieurs modèles entre eux, "s'il est mal réglé, va amplifier les défauts de chaque modèle et le climat qui est simulé risque alors de dériver »[2].

L’article reconnaît en effet que, dès qu’on fait « des simulations sur près de 300 ans …la vingtaine de modèles dits "de circulation générale" (MCG) qui tournent à travers le monde…. » produisent des résultats qui « diffèrent très sensiblement ». Les scientifiques sont face à un dilemme : se limiter à 150 ans et faire croire à un consensus, ou reconnaître que leurs modèles ne sont pas au point et ne peuvent expliquer des variations sur une période plus longue. Malheureusement, le Giec a fait le premier choix. Comme le dit Frédéric Hourdin : « le Giec préfère continuer à les utiliser tous même s'ils conduisent à des résultats différents pour donner un large état de la planète ».

La question se pose alors : "D'où vient cette différence entre les modèles ? ». l’article explique qu’« un modèle global est une alchimie de différents paramètres codés, … les modèles actuels sont encore très loin de représenter tous les processus qui rentrent en jeu dans le climat… » !

Mais y arrivera-t-on un jour ? Les chercheurs en doutent. "Plus un modèle se complexifie, plus il est difficile de le fiabiliser, et plus la possibilité qu'il fasse des erreurs augmente", admet Frédéric Hourdin. Peut-être faudrait-il les simplifier et limiter le nombre de paramètres ? Mais comment prendre en compte alors des microphénomènes souvent déterminants, comme les nuages ou les tourbillons océaniques ? Or certains phénomènes déterminants se produisent à trop petite échelle pour être capturés par le maillage actuel. C'est le cas pour les nuages dans l'atmosphère ou pour les transferts d'énergie induits par les tourbillons dans l'océan. "Il faudrait créer un filet au maillage bien plus étroit pour capter ces phénomènes".

"Le problème, c'est que nous manquons terriblement de données" » reconnaît l’étude.

Les prévisions proposées par le Giec ne sont que des « scénarios économistes » retenant des « projections démographiques, des taux d'industrialisation et de surface agricole ». L'étude ajoute: « Ces scénarios ne peuvent pas être considérés comme des prévisions. Ils restent entachés de nombreuses incertitudes ».

Actuellement, près de la moitié du globe est influencé par un phénomène climatique de grande ampleur, El Niño (ENSO, El Niño South Oscillation), qui régule le climat tropical tout en provoquant tous les cinq ou six ans des événements extrêmes. En Europe, on parle beaucoup également d'un phénomène plus local et de moindre ampleur, l'Oscillation Nord-Atlantique (NAO), qui perturbe régulièrement notre climat. Ce sont ces événements-là parmi bien d'autres[3] que les climatologues ne comprennent pas encore entièrement. "Malgré l'ampleur des connaissances, des pans entiers de la climatologie échappent encore aux modèles et aux observations", admet Jean Jouzel, directeur de recherche au CEA et directeur de l'Institut Pierre-Simon Laplace[4].

« Ce qui est inquiétant, c'est que si nos modèles ne parviennent pas à prédire avec certitude des signaux aussi forts, je ne vois pas comment ils pourraient prévoir tous les autres événements climatiques", ajoute Pascale Delecluse, directrice de recherche CNRS au Laboratoire de Sciences du climat et de l'environnement.

On ne s'étonne pas que Michel Déqué ajoute qu' "il n'est pas inenvisageable… que les dix prochaines années puissent être un peu plus froides que la décennie précédente"!

2- Quand le Giec paramètre ses modèles en fonction des résultats souhaités !

Frédéric Hourdin a contribué à un article sur l’art et la science du paramétrage des modèles climatiques[5].

Il explique que « le processus d’estimation des paramètres visant un ensemble choisi d’observations est un aspect essentiel de la modélisation numérique ». En effet, « les choix et les compromis faits au cours de l'exercice d'ajustement peuvent affecter de manière significative les résultats du modèle et influencer les évaluations qui mesurent une distance statistique entre le climat simulé et observé».

Malheureusement, ajoute-t-il, « l'importance du tuning est souvent ignoré lors de la discussion des performances des modèles climatiques dans les analyses multi-modèles. En fait, la stratégie d'optimisation ne faisait même pas partie de la documentation requise pour les simulations ».

Frédéric Hourdin pose la question: “Pourquoi un tel manque de transparence? Peut-être parce que le tuning est souvent vu comme une partie inévitable mais grossière de la modélisation climatique [considéré] plus comme conception que comme science et comme un bricolage qui ne mérite pas de faire l’objet d’un enregistrement dans la littérature scientifique » !

Les auteurs ont voulu savoir comment, les centres de modélisation réglaient leurs modèles en “interrogeant 23 différents centres de modélisation qui développent des modèles couplés atmosphère et océan ».

Le résultat de l’enquête surprend: “22 des 23 groupes ont déclaré avoir ajusté les paramètres du modèle pour obtenir les propriétés souhaitées ». Qui plus est, « tous les groupes étaient d'accord ou plutôt d'accord sur le fait que le réglage était justifié ».

D’ailleurs les auteurs expliquent que « le résultat désiré est connu de ceux qui développent [un modèle] et devient par conséquent un objectif du développement ». Ils ajoutent que « Certains groupes de modélisation prétendent ne pas adapter leurs modèles au réchauffement du XXe siècle; Cependant, même pour les développeurs de modèles, il est difficile de s'assurer que cela est absolument vrai en pratique en raison de la complexité et de la dimension historique du développement du modèle ».

Quand on lit une telle analyse, comment peut-on encore parler de conclusions hautement probables à propos du réchauffement du 20ième siècle. On a le sentiment que les modèles climatiques reflètent essentiellement l’opinion de leurs auteurs. Linguee n’a pas tord de traduire un article de l’UNESCO utilisant l’adage anglais « Garbage in – garbage out » par « foutaises en entrée, foutaises en sortie ».

Le Giec a d'ailleurs toujours reconnu que, dans ses modèles, il est obligé d'introduire des "flux de correction"! Il s'agit, par là, de remédier aux écarts entre les résultats obtenus par la simulation et la réalité. L’introduction de ces flux est une preuve indiscutable de l’inexactitude des modèles. L’IPCC-95 le reconnaît sans détours : « La nécessité d’introduire des flux de correction est une reconnaissance explicite des insuffisances des composants des modèles climatiques couplés [océan-atmosphère]. » (IPCC-95, p. 267). Le même rapport reconnaît que les flux sont « relativement importants »(IPCC-95, p. 249)

Une illustration disponible dans le rapport 1992 (IPCC-92, p. 110) permet de constater qu’ils sont du même ordre de grandeur que les valeurs simulées, voire à peu près opposés. Or, les flux de corrections ne sont légitimes que s’ils sont « relativement faibles » (IPCC-92, pp. 238 et 310). Or le rapport de 1995 note qu’en comparaison [des flux naturels], ils sont importants » et qu’à certains endroits, ils sont souvent plus importants que les flux climatiques moyens (IPCC-92, p. 347). Ils peuvent atteindre ≈100 W/m², voire localement 200 W/m², (IPCC-92, pp. 310 et 245) alors que la perturbation due au doublement de la concentration en CO2 se limite à 4 W/m². Par ailleurs, l’IPCC note que les flux de correction sont « additifs et ne garantissent pas l’absence de dérive ultérieure » (IPCC-90, p. 87, 123).

Dès lors il n'est pas sûr que l’on puisse affirmer que l’amélioration obtenue par ces paramétrisations, et l'ajout de ces flux de correction, provienne véritablement d’une description adéquate des processus ou d’une simple coïncidence!

3- Que dire des modélisations sur l’évolution du « trou d’ozone » ?

Quand on lit la littérature sur l’ozone, il semble que les approximations sont du même ordre.

J. Molina et F. S. Rowland ont reçu le prix Nobel pour avoir publié, en 1974, dans Nature[6], leur étude "Stratospheric Sink for Chloro-fluoro-methanes: Chlorine Atom-Catalysed Destruction of Ozone". Leur raisonnement partait des mesures de CFC (Chloro-Fluoro-Carbonés) atmosphériques de Lovelock et d’autres. Ils constataient le taux de production [important] de CFC par l’industrie chimique. S’appuyant sur des données spectroscopiques et chimiques compilées avec un œil critique dans des tables, ils mettent en œuvre des calculs informatiques, qui utilisaient des "coefficients hypothétiques" ("assumed coefficients") extraite d'un modèle de "diffusion tourbillonnaire" ("eddy diffusion") à une dimension pour trouver l’altitude à laquelle les CFC seraient décomposés par les rayons UV.

Les modèles de l’époque, beaucoup moins sophistiqués que ceux du Giec, buttaient, eux aussi sur le problème de réglage des coefficients.

Frédéric Hourdin a le mérite d’être un des rares spécialistes en matière de modèle de type « Eddy diffusion »[7]. Il connait la difficulté, en particulier, à modéliser les turbulences nuageuses. Rien n’a été publié depuis sur leur effet sur la couche d’ozone.

Conclusion

Il faut reconnaître le courage d’un chercheur comme Frédéric Hourdin. Grâce à lui, on ne pourra donc plus déclarer que remettre en cause les modèles du GIEC, c’est remettre en cause les lois de la physique. On a le sentiment d’être en face de modèles incapables de reproduire le passé sans « réglages » (tout est dans le choix des mots !) et dont les prévisions ne correspondent pas aux observations. On peut imaginer mieux en matière de preuve.

Ce qui fait de Frédéric Hourdin un membre du Giec étrange c’est que malgré ses analyses, il confirme que « la seule explication disponible aujourd'hui pour le changement climatique observé est bien l'augmentation des gaz à effet de serre dans l'atmosphère, prédite, comprise et expliquée avant d'être confirmée par l'observation »[8]

[1] Frédéric Hourdin est chercheur au Laboratoire de Météorologie Dynamique, IPSL, CNRS, UPMC, Paris, France

[2] Évolution du climat : peut-on se fier aux modèles ? - enquête du Journal du CNRS n°174, mai 2004 - Chapitre « projection vers le futur » par Fabrice Imperiali

[3] Il existe d'autres signaux comme le Pacific North America (PNA), le Pacific Decadal Oscillation (PDO) ou l'Indian Ocean Zonal Mode (IOZM)...

[4] Évolution du climat : peut-on se fier aux modèles ? - enquête du Journal du CNRS n°174, mai 2004 - Chapitre « La traque des évènements climatiques » par Fabrice Imperiali

[5] The Art and Science of Climate Model Tuning

Authors: Frédéric Hourdin and al. - Laboratoire de Météorologie Dynamique, IPSL, CNRS, UPMC, Paris, France

Nous en donnons ici, sans plus de vérification, une traduction effectuée par Google-traducteur :

Résumé

Nous examinons la logique et la diversité des méthodes de tuning, aspect fondamental de la modélisation du climat qui devrait être documenté plus systématiquement et pris en compte dans une analyse multi-modèles.

Le processus d’estimation des paramètres visant un ensemble choisi d’observations est un aspect essentiel de la modélisation numérique. Dans le milieu de la modélisation numérique on appelle généralement ce processus ‘ réglage’ (tuning). Dans les modèles du climat, la variété et la complexité des processus physiques mis en jeu, et leurs interactions à travers une large gamme d’échelles spatiales et temporelles, doivent être synthétisées dans une série de sous-modèles approximatifs. La plupart de ces sous-modèles dépendent de paramètres incertains. Le tuning consiste à ajuster les valeurs de ces paramètres pour amener la solution dans son ensemble à s’aligner avec les aspects du climat observé. Le tuning est un aspect essentiel de la modélisation climatique avec ses propres problèmes scientifiques, ce qui n’est probablement pas assez connu en dehors de la communauté des développeurs de modèles.

L’optimisation des modèles du climat soulève d’importantes questions sur la mesure dans laquelle les méthodes de tuning à priori contraignent les résultats des modèles dans des directions imprévues affectant notre confiance dans les prévisions climatiques. Nous présentons ici la définition et la logique sous-tendant le tuning des modèles, analysons les aspects méthodologiques spécifiques, et examinons la diversité des approches de tuning utilisées dans les modèles de climat actuels. Nous discutons également des défis et opportunités de l’application de méthodes dites ‘objectives’ dans la mise au point du modèle climatique. Nous discutons de la mesure dans laquelle les méthodologies de tuning peuvent affecter les résultats fondamentaux des modèles du climat, comme la sensibilité climatique. L’article se conclut par une série de recommandations afin de rendre le processus de mise au point de la modélisation du climat plus transparent.

Comme c'est souvent le cas dans les sciences qui traitent de systèmes complexes, les modèles numériques sont devenus essentiels dans la science du climat (Edwards, 2001). Les modèles de circulation générale de l'atmosphère ont été initialement développés pour la prévision numérique du temps (par exemple, Phillips 1956). Le couplage des modèles atmosphériques et océaniques globaux a commencé avec Manabe et Bryan (1969) et a pris de l'âge dans les années 1980 et 1990. Les modèles climatiques mondiaux ou les modèles du système Terre (ESM) sont aujourd'hui largement utilisés pour étudier les changements climatiques causés par les perturbations anthropiques et naturelles (Lynch 2008, Edwards 2010). L'évaluation et l'amélioration de ces modèles globaux sont le moteur de nombreuses recherches théoriques et observationnelles. Les publications qui analysent les simulations coordonnées au niveau international dans le cadre du projet d'inter-comparaison de modèles couplés (CMIP) constituent une grande partie du matériel synthétisé dans les rapports d'évaluation du Groupe d'experts intergouvernemental sur l'évolution du climat (GIEC). Au-delà de leur utilisation pour la prédiction et la projection à des échelles de temps météorologiques à climatiques, les modèles globaux jouent un rôle clé dans la science du climat. Ils sont utilisés pour comprendre et évaluer les mécanismes à l'œuvre, tout en tenant compte de la complexité du système climatique et des échelles spatiales et temporelles en jeu (Dalmedico 2001, Held 2005).

Le développement d'un modèle climatique est un projet à long terme. Lors de la publication d'un nouveau modèle ou d'une nouvelle version d'un modèle, une série de sous-modèles, parfois développés ou améliorés au fil des années dans des équipes distinctes, sont combinés et optimisés pour produire un climat correspondant à certains aspects clés du climat observé. Si la physique fondamentale du climat est généralement bien établie, les sous-modèles ou les paramétrisations sont approximatifs, soit en raison de problèmes de coûts numériques (limitation de la résolution, accélération du calcul du transfert radiatif), soit parce qu'ils tentent de synthétiser des processus complexes. une représentation idéalisée et approximative. Chaque paramétrage repose sur un ensemble d'équations internes et dépend souvent de paramètres dont les valeurs sont souvent faiblement contraintes par les observations. Le processus d'estimation de ces paramètres incertains afin de réduire l'inadéquation entre des observations spécifiques et les résultats du modèle est généralement appelé syntonisation dans la communauté de modélisation climatique.

La mise au point des modèles climatiques est un processus complexe qui présente des analogies avec la recherche de l’harmonie en musique. Produire une bonne symphonie ou un concert de rock nécessite d’abord une bonne composition et de bons musiciens qui travaillent individuellement leur partition. Puis, en jouant ensemble, les instruments doivent être accordés, ce qui est un réglage bien défini des fréquences que l’on peut effectuer avec l’aide de systèmes électroniques. Mais on atteint l’harmonie de l’orchestre en adoptant un tempo commun de même que par des combinaisons subjectives d’instruments, de niveaux de volume ou d’interprétations de musiciens, ce qui dépendra des intentions du chef d’orchestre ou des musiciens. En réunissant différents éléments d’un modèle pour simuler le climat global, il y a aussi beaucoup de problèmes scientifiques et techniques, et on peut définir le tuning lui-même comme un processus objectif d’estimation de paramètres pour s’adapter à un jeu prédéfini d’observations, prenant en compte une certaine incertitude, processus qu’on peut concevoir. Cependant, en raison de la complexité du système climatique et des choix et approximations faits dans chaque sous-modèle, et à cause des priorités spécifiées dans chaque pôle climatique, on trouve aussi de la subjectivité dans le tuning des modèles climatiques (Tebaldi and Knutti 2007) de même qu’un savoir faire substantiel d’un nombre limité de personnes possédant une vaste expérience d’un modèle particulier. L'un des objectifs de cet article est de rendre ces connaissances plus explicites.

Les choix et les compromis faits au cours de l'exercice d'ajustement peuvent affecter de manière significative les résultats du modèle et influencer les évaluations qui mesurent une distance statistique entre le climat simulé et observé. En théorie, le réglage doit être pris en compte dans toute évaluation, inter-comparaison ou interprétation des résultats du modèle. Bien que le besoin d'ajustement des paramètres ait été reconnu dans les travaux de modélisation pionniers (Manabe et Wetherald, 1975) et considéré comme un aspect important dans les études épistémologiques de modélisation climatique (Edwards 2001), l'importance du tuning n'est probablement pas annoncée comme il se doit. Il est souvent ignoré lors de la discussion des performances des modèles climatiques dans les analyses multimodèles. En fait, la stratégie d'optimisation ne faisait même pas partie de la documentation requise pour les simulations CMIP phase 5 (CMIP5). Dans les meilleurs cas, la description de la stratégie d'ajustement était disponible dans les publications de référence des groupes de modélisation (Mauritsen et al 2012, Golaz et al 2013, Hourdin et al 2013a, b, Schmidt et al., 2014). Pourquoi un tel manque de transparence? Peut-être parce que le tuning est souvent vu comme une partie inévitable mais grossière de la modélisation climatique [considéré] plus comme conception que comme science et comme un bricolage qui ne mérite pas de faire l’objet d’un enregistrement dans la littérature scientifique. Il y a peut-être aussi quelque préoccupation car expliquer que les modèles sont tunés peut renforcer les arguments de ceux qui revendiquent de questionner la validité des projections du changement climatique. Le tuning peut être considéré comme une façon grossière de compenser les erreurs des modèles.

Le but de cet article est d'aider à rendre le processus de réglage du modèle plus explicite et transparent. Le réglage est une partie intrinsèque et fondamentale de la modélisation du climat qui devrait être mieux documentée et discutée en tant que telle dans la littérature scientifique. Le réglage peut être décrit comme une étape d'optimisation et suit une approche scientifique. Tuning peut fournir des informations importantes sur les mécanismes climatiques et les incertitudes des modèles. Certains biais dans les modèles climatiques peuvent être réduits ou supprimés par accord, tandis que d'autres restent obstinément résistants. Il est important de comprendre pourquoi si nous voulons améliorer les modèles. Nous présentons ci-dessous une définition de l'optimisation, documentons les pratiques et méthodologies actuelles et abordons les problèmes émergents. Nous concluons avec des recommandations sur le réglage du modèle et sa documentation.

DÉFINITION DU REGLAGE DE MODÈLE CLIMATIQUE.

Le réglage ou l'étalonnage du modèle n'est ni un nouveau concept ni spécifique à la modélisation du climat. En sciences statistiques, Fisher a introduit trois étapes dans le processus de modélisation (Fisher 1922, Burnham et Anderson 2002): (i) la formulation du modèle, (ii) l'estimation des paramètres et (iii) l'estimation de l'incertitude. Cette catégorisation s'applique également au contexte plus large de la modélisation numérique. Il est conceptuellement utile de faire la distinction entre la formulation du modèle et l'estimation des paramètres, même si cette distinction n'est nullement évidente dans l'ajustement du modèle climatique, comme expliqué ci-dessous.

Le développement de modèles climatiques est fondé sur une physique bien comprise combinée à un certain nombre de représentations de processus heuristiques. Les mouvements fluides dans l'atmosphère et l'océan sont résolus par le noyau dynamique jusqu'à un espacement de 25 à 300 km pour les modèles globaux, basé sur des formulations numériques des équations du mouvement de la mécanique des fluides. Les mouvements turbulents et convectifs à l'échelle du sous-type doivent être représentés par des paramétrisations approximatives à l'échelle du sous-type (Smagorinsky 1963, Arakawa et Schubert 1974, Edwards 2001). Ces paramétrisations à l'échelle du sous-maille incluent le couplage avec la thermodynamique; radiation; hydrologie continentale; et, facultativement, la chimie, la microphysique d'aérosol ou la biologie.

Les paramétrisations sont souvent basées sur une vue mixte, physique, phénoménologique et statistique. Par exemple, la fraction de nuages nécessaire pour représenter l'effet moyen d'un champ de nuages sur le rayonnement peut être liée à l'humidité et à la température résolues grâce à une relation empirique. Mais la même fraction de nuages peut également être obtenue à partir d'une description plus élaborée des processus régissant la formation et l'évolution des nuages. Par exemple, pour un ensemble de cumulus à l'intérieur d'une cellule horizontale, les nuages peuvent être représentés par un panache d'air chaud et humide de la surface (Tiedtke 1989, Jam et al., 2013) ou avec un ensemble de tels nuages. panaches (Arakawa et Schubert 1974). Des paramétrisations similaires sont nécessaires pour de nombreux composants ne se prêtant pas aux approches de premier principe à l'échelle de la grille d'un modèle global, y compris les couches limites, l'hydrologie de surface et la dynamique des écosystèmes. Chaque paramétrage, à son tour, dépend typiquement d'un ou de plusieurs paramètres dont les valeurs numériques sont faiblement contraintes par les premiers principes ou les observations à l'échelle de la grille des modèles globaux. Étant des descriptions approximatives de processus non résolus, il existe différentes possibilités pour la représentation de nombreux processus. Le développement d'approches concurrentes pour différents processus est l'un des domaines les plus actifs de la recherche climatique. La diversité des approches possibles et des valeurs des paramètres est l'une des principales motivations des projets d'intercomparaison de modèles dans lesquels un protocole strict est partagé par différents groupes de modélisation afin de mieux isoler l'incertitude des simulations climatiques issue de la diversité des modèles (incertitude modèle) .

Une configuration de modèle est déterminée par deux aspects: sa complexité et sa résolution. Pour les modèles climatiques globaux ou ESM, la configuration retenue résulte généralement de compromis entre résolution, complexité, longueur et nombre de simulations. Différents groupes de modélisation peuvent avoir des priorités différentes en termes de questions scientifiques et d'applications, ce qui rend différents jugements sur la façon de mieux équilibrer les ressources finies. Le choix de la complexité et de la résolution elle-même peut être considéré comme un réglage au sens large, car il est souvent motivé par la capacité du modèle à reproduire avec un certain réalisme certains aspects clés du système climatique.

Ici, nous nous concentrons sur la définition classique de l'accord qui correspond à l'estimation des paramètres dans la terminologie de Fisher. Une fois qu'une configuration de modèle est fixée, le réglage consiste à choisir des valeurs de paramètre de telle sorte qu'une certaine mesure de l'écart de la sortie du modèle à partir d'observations ou de théories choisies soit minimisée ou réduite à une plage acceptable. Défini de cette façon, le réglage est généralement appelé étalonnage dans d'autres domaines d'application de modèles numériques complexes (Kennedy et O'Hagan 2001). Cependant, certains modélisateurs du climat hésitent à utiliser ce terme, car ils savent qu'en ajustant les paramètres, ils compensent également, intentionnellement ou non, certaines carences (souvent inconnues) de la formulation du modèle elle-même.

Le réglage des paramètres lui-même se produit à différents niveaux qui correspondent aux étapes du développement du modèle. Un étalonnage initial peut être effectué pendant la phase de développement d'un nouveau paramétrage, par exemple en utilisant une version à une colonne du modèle climatique. Bien que souhaitable en principe, cet ajustement de paramétrage est souvent difficile en pratique car les processus sont fortement couplés entre eux et à la dynamique à grande échelle. À l'étape suivante, un certain nombre de paramétrages sont réglés ensemble lorsqu'ils sont assemblés en composants: atmosphère, océan et surface continentale. Cet ajustement de composant est effectué en utilisant des composants autonomes avec des conditions aux limites qui seraient autrement fournies par d'autres composants. Par exemple, un modèle océanique avec un stress de vent de surface imposé, des apports d'eau douce, des précipitations et des rayonnements pourrait être ajusté pour obtenir des températures de surface de la mer ou une circulation de retournement méridional correspondant aux attentes. Un réglage du système est finalement nécessaire pour assurer la cohérence à travers le système climatique complet une fois que les composants sont couplés ensemble.

PRATIQUES ET OBJECTIFS COMMUNS.

L'ajustement des modèles du système terrestre couplé suit généralement une pratique courante, mais avec des cibles et des priorités qui peuvent varier d'un groupe à l'autre. Cela a été confirmé par un sondage réalisé en août-septembre 2014 (voir l'encadré «Comment les centres de modélisation adaptent-ils leurs modèles?» Pour les résultats). La plupart des principaux groupes de modélisation du climat (23 centres modèles) ont répondu à un questionnaire sur les raisons et les modalités d'ajustement de leurs modèles.

COMMENT LES CENTRES DE MODÉLISATION RÉGLENT-ILS LEURS MODÈLES?

Une enquête a été menée en août-septembre 2014, interrogeant 23 différents centres de modélisation qui développent des modèles couplés atmosphère et océan pour savoir comment ils ajustent les modèles. Dans la plupart des centres, un certain nombre de personnes discutaient des réponses avant de les soumettre (une réponse par groupe). Les résultats complets peuvent être trouvés dans les informations supplémentaires en ligne (http://dx.doi.org/10.1175/BAMS-D-15-00135.2); 22 des 23 groupes ont déclaré avoir ajusté les paramètres du modèle pour obtenir les propriétés souhaitées, comme le bilan radiatif au sommet de l'atmosphère. Les pourcentages sont déclarés en fonction de la fraction des répondants. 83% des centres utilisent uniquement l'atmosphère et la terre (température de surface fixe ou océan de données) pour ajuster les paramètres et 44% utilisent des modèles à colonne unique, tandis que 74% effectuent leur ajustement avec une configuration atmosphère-océan préindustrielle couplée. % utilisent des simulations actuelles couplées. De nombreux groupes ajustent également les paramètres des modèles océaniques (48%) et terrestres (39%) en utilisant des configurations autonomes. En outre, 21% utilisent des simulations historiques du XXe siècle et 17% utilisent des modèles d'océan de dalles.

Les objectifs de réglage sont assez uniformes. Les groupes ont été interrogés sur 26 paramètres différents: une grande variété. Environ un tiers (8 sur 26) des mesures ont été jugés décisifs ou très importants par au moins un tiers (35%) des centres de modélisation. Cependant, il y avait beaucoup d'accord sur les paramètres décisifs (les plus importants): le flux global net de l'atmosphère (70%) et la température de surface moyenne mondiale (26%). Sur la base de ces objectifs de réglage, un certain nombre de paramétrages différents sont ajustés pour les atteindre. Puisque le réglage est généralement axé sur le bilan radiatif superficiel et de surface, les propriétés les plus courantes ajustées sont les propriétés incertaines des nuages et ensuite les propriétés qui affectent l'albédo de surface; 29% ont ajusté chaque paramétrage demandé occasionnellement ou fréquemment. Les paramétrisations les plus courantes fréquemment ajustées sont les nuages dans l'atmosphère, y compris la microphysique des nuages (65%), la convection (52%) et la fraction des nuages (52%). Les paramètres les plus fréquemment ajustés sont la neige (79%) et la glace de mer (57%), ainsi que le mélange océanique (57%), la traînée orographique (57%) et les propriétés optiques des nuages (48%). Les propriétés du sol (43%) et de la végétation (39%) ont également été ajustées. Ces ajustements sont compatibles avec le sentiment que la physique des nuages atmosphériques et la convection atmosphérique étaient les plus susceptibles d'introduire des biais dans le modèle, avec la physique des océans et le mélange en troisième.

Enfin, on a demandé aux groupes si différentes pratiques d'ajustement étaient admissibles (justifiées) sur une échelle de cinq points de désaccord, plutôt en désaccord, neutre, plutôt d'accord et d'accord. Tous les groupes étaient d'accord ou plutôt d'accord sur le fait que le réglage était justifié; 91% ont estimé que l'ajustement de la température moyenne mondiale ou du bilan radiatif global était justifié (convenu ou plutôt accepté). Étant donné qu'il s'agissait de groupes participant à une réunion sur le sujet, il y a un biais d'autosélection. En utilisant les mêmes catégories que l'accord d'enregistrement, plus de la moitié des répondants ont jugé acceptable la circulation atmosphérique (74%), le volume ou l'étendue de la glace de mer (70%) et les effets radiatifs des nuages par régime et la variabilité (les deux 52%).

Avec la diversité croissante des applications des modèles climatiques, le nombre de cibles potentielles pour le réglage augmente. Il existe une variété d'objectifs pour des problèmes spécifiques, et différents modèles peuvent être optimisés pour mieux fonctionner sur une métrique particulière, liée à des objectifs spécifiques, à l'expertise ou à l'identité culturelle d'un centre de modélisation donné. Les groupes plus focalisés sur le climat européen peuvent donner plus d'importance au transport de chaleur océanique dans l'Atlantique Nord, alors que d'autres peuvent être plus concernés par le climat tropical et la convection. Certains groupes peuvent accorder plus de poids aux mesures qui mesurent la capacité à reproduire la climatologie moyenne actuelle ou les modes de variabilité observés, tandis que d'autres privilégient les mesures axées sur les processus qui dominent la réponse au forçage anthropique.

Il existe cependant une cible partagée dominante pour les modèles climatiques couplés: le système climatique devrait atteindre une température d'équilibre moyenne proche des observations lorsque l'énergie reçue du soleil est proche de sa valeur réelle (≃340 W m-2). Cette source d'énergie sera équilibrée par l'énergie perdue dans l'espace par la lumière solaire réfléchie et le rayonnement thermique infrarouge si le modèle conserve l'énergie numériquement (ce qui ne peut pas toujours être strictement imposé). Nous savons en effet que le système est presque en équilibre, mais pour l'absorption de chaleur de l'océan, on estime à environ 0,5 W m-2 dans notre climat de réchauffement, une valeur beaucoup plus petite que le modèle et les incertitudes observationnelles. Cela fournit une contrainte forte et à grande échelle.

Une pratique courante pour remplir cette contrainte est d'ajuster le bilan énergétique de surface ou de surface dans des simulations atmosphériques uniquement exposées aux températures de surface de la mer observées (réglage des composants) et de vérifier si la température obtenue dans les modèles couplés est réaliste. Cet ajustement du bilan énergétique est crucial car un changement de 1 W m-2 du bilan énergétique global produit généralement une variation d'environ 0,5-1,5 K de la température de surface moyenne globale dans les simulations couplées en fonction de la sensibilité du modèle donné.

En général, les paramètres reçoivent des valeurs a priori et idéalement une gamme autour de cette valeur. Cette information peut provenir de la théorie, d'une estimation de retour de l'enveloppe, d'expériences numériques (réglage d'un coefficient de diffusion turbulent à partir de simulations explicites du processus turbulent) ou d'observations (une gouttelette moyenne effective de nuages par exemple). Notez que de nombreux paramètres internes ne sont pas directement observables. Compte tenu de ces informations, une pratique courante consiste à ajuster les paramètres les plus incertains qui affectent de manière significative les paramètres climatiques clés. En effet, tous les paramètres ne sont pas connus avec la même précision. Il existe un consensus (voir le sondage) selon lequel les paramètres les plus incertains qui affectent le rayonnement atmosphérique sont ceux entrant dans le paramétrage des nuages et de l'albédo de la surface de la Terre. Les nuages exercent un effet de refroidissement net important (environ -20 W m-2), mais cet effet est incertain à quelques watts par mètre carré (Loeb et al., 2009). Une variation de 1 W m-2 des effets radiatifs des nuages est seulement une variation de 5% de l'effet net de refroidissement des nuages et 2% de l'effet solaire (ou ondes courtes), bien en dessous des incertitudes observationnelles et modèles (L'Ecuyer et al.).

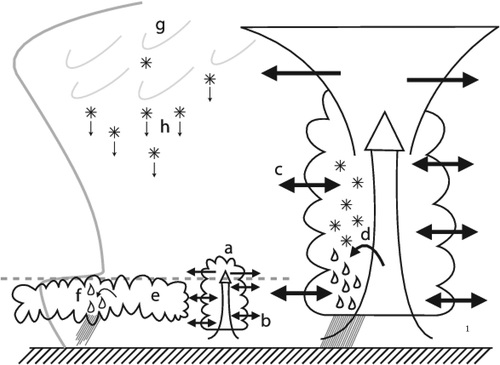

La plupart des paramètres de réglage sont spécifiques aux choix de sous-modèles (paramétrage). Les paramètres contrôlant le mélange des nuages convectifs avec l'environnement dépendront de la description spécifique du transport vertical convectif, les paramètres contrôlant la distribution de la taille des gouttelettes du nuage dépendront de la sophistication de la microphysique, et ainsi de suite. A titre d'exemple, la figure 1, reproduite de Mauritsen et al. (2012, leur Fig. 1), illustre les différents paramètres utilisés pour le réglage d'un modèle particulier.

Fig. 1. Exemple d'approche de réglage pour le modèle ECHAM (d'après Mauritsen et al., 2012). La figure illustre les principaux processus Cloud incertains liés au climat fréquemment utilisés pour ajuster le climat du modèle ECHAM. Les nuages stratiformes de liquide et de glace et les nuages convectifs peu profonds et profonds sont représentés. La courbe grise à gauche représente les températures troposphériques, et la ligne pointillée est le sommet de la couche limite. Les paramètres sont (a) le flux massique convectif au-dessus du niveau de non-gonflement, (b) le taux d'entraînement latéral des nuages convectifs peu profonds, (c) le taux d'entraînement latéral des nuages convectifs profonds, (d) le homogénéité des nuages, (f) taux de conversion des eaux de nuages liquides en pluie, (g) homogénéité des nuages de glace et (h) vitesse de chute des particules de glace.

Fig. 1. Exemple d'approche de réglage pour le modèle ECHAM (d'après Mauritsen et al., 2012). La figure illustre les principaux processus Cloud incertains liés au climat fréquemment utilisés pour ajuster le climat du modèle ECHAM. Les nuages stratiformes de liquide et de glace et les nuages convectifs peu profonds et profonds sont représentés. La courbe grise à gauche représente les températures troposphériques, et la ligne pointillée est le sommet de la couche limite. Les paramètres sont (a) le flux massique convectif au-dessus du niveau de non-gonflement, (b) le taux d'entraînement latéral des nuages convectifs peu profonds, (c) le taux d'entraînement latéral des nuages convectifs profonds, (d) le homogénéité des nuages, (f) taux de conversion des eaux de nuages liquides en pluie, (g) homogénéité des nuages de glace et (h) vitesse de chute des particules de glace.

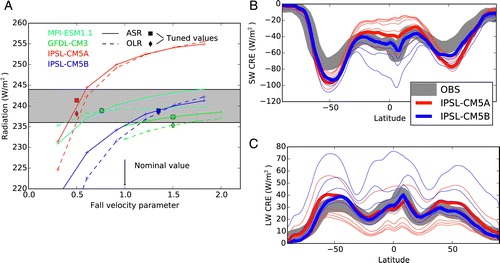

Certains paramétrages et paramètres d'optimisation associés sont cependant partagés par plusieurs modèles. Nous montrons sur la figure 2 comment un facteur d'échelle de la vitesse de chute des cristaux de glace (processus h sur la figure 1) est utilisé pour contraindre le rayonnement global à ondes courtes et longues pour correspondre à la valeur observée de 240 ± 4 W m-2 les modèles qui partagent la même formulation pour la vitesse de chute des cristaux de glace (Heymsfield et Donner, 1990). Une vitesse de chute plus importante réduit systématiquement la quantité de nuages de glace et augmente ainsi à la fois le rayonnement absorbé des ondes courtes (albédo planétaire réduit) et le rayonnement sortant des ondes longues (effet de serre réduit). Au-delà des valeurs globales, le réglage est parfois appliqué aux variations spatiales des flux radiatifs comme la dépendance latitudinale qui entraîne la circulation générale ou les contrastes terre-mer qui alimentent les circulations de mousson. Les figures 2b et 2c illustrent, pour deux modèles, comment le même facteur de vitesse de chute des cristaux de glace affecte la distribution latitudinale du rayonnement solaire absorbé et du rayonnement à ondes longues sortant.

Fig. 2. Exemple d'ajustement du bilan énergétique global de la haute atmosphère avec un paramètre de nuage pour le modèle climatique du Laboratoire de Dynamique des Fluides Géophysiques, version 3 (GFDL CM3), Modèle du Système Terre Max Planck Institute, version 1.1 (MPI-ESM1 .1), et deux versions (A et B) du modèle Coupled L'Institut Pierre-Simon Laplace, version 5 (IPSL-CM5), qui diffèrent par la représentation de la couche limite convective, des nuages et de la convection. (a) Radiation à ondes courtes absorbées globales (ASR, courbe complète) et rayonnement sortant (OLR, en pointillés) au sommet de l'atmosphère. L'axe horizontal correspond à la valeur d'un paramètre d'échelle dans l'équation de vitesse de chute des cristaux de glace, Eq. (5) de Heymsfield et Donner (1990), qui est partagé par les quatre modèles. Les simulations sont effectuées sur plusieurs années avec une température de surface de la mer imposée. La différence entre les courbes en pointillés et pleines donne le bilan énergétique global. Les carrés et losanges correspondent aux valeurs par défaut conservées après une phase d'accord (pour GFDL et IPSL-CM ils correspondent aux valeurs retenues pour CMIP5, mais comme les expériences ont été refaites avec des versions récentes des mêmes modèles, l'équilibre n'est pas entièrement satisfait avec les valeurs sélectionnées). Pour les modèles IPSL, nous montrons comment l'ajustement du paramètre d'échelle affecte la variation latitudinale de l'effet radiatif des nuages calculée comme la différence entre le rayonnement total et le ciel clair pour (b) les ondes courtes et (c) les ondes longues. Les courbes fines correspondent aux différentes valeurs du paramètre d'accord (plus la vitesse de chute est faible, plus l'effet radiatif du nuage absolu est important dans les ondes longues et les ondes courtes) et les courbes épaisses aux valeurs retenues après l'accord. Les observations correspondent au produit L3b CERES (Energy Radiant Energy System) de Clouds et de la Terre (EBAF) pour Loeb et al. (2009). La hauteur du rectangle gris en (a) et l'épaisseur des courbes grises en (b) et (c) correspondent à une incertitude d'observation de ± 4 W m-2. Notez, cependant, que les vraies barres d'erreur ne sont pas disponibles pour ces observations.

Fig. 2. Exemple d'ajustement du bilan énergétique global de la haute atmosphère avec un paramètre de nuage pour le modèle climatique du Laboratoire de Dynamique des Fluides Géophysiques, version 3 (GFDL CM3), Modèle du Système Terre Max Planck Institute, version 1.1 (MPI-ESM1 .1), et deux versions (A et B) du modèle Coupled L'Institut Pierre-Simon Laplace, version 5 (IPSL-CM5), qui diffèrent par la représentation de la couche limite convective, des nuages et de la convection. (a) Radiation à ondes courtes absorbées globales (ASR, courbe complète) et rayonnement sortant (OLR, en pointillés) au sommet de l'atmosphère. L'axe horizontal correspond à la valeur d'un paramètre d'échelle dans l'équation de vitesse de chute des cristaux de glace, Eq. (5) de Heymsfield et Donner (1990), qui est partagé par les quatre modèles. Les simulations sont effectuées sur plusieurs années avec une température de surface de la mer imposée. La différence entre les courbes en pointillés et pleines donne le bilan énergétique global. Les carrés et losanges correspondent aux valeurs par défaut conservées après une phase d'accord (pour GFDL et IPSL-CM ils correspondent aux valeurs retenues pour CMIP5, mais comme les expériences ont été refaites avec des versions récentes des mêmes modèles, l'équilibre n'est pas entièrement satisfait avec les valeurs sélectionnées). Pour les modèles IPSL, nous montrons comment l'ajustement du paramètre d'échelle affecte la variation latitudinale de l'effet radiatif des nuages calculée comme la différence entre le rayonnement total et le ciel clair pour (b) les ondes courtes et (c) les ondes longues. Les courbes fines correspondent aux différentes valeurs du paramètre d'accord (plus la vitesse de chute est faible, plus l'effet radiatif du nuage absolu est important dans les ondes longues et les ondes courtes) et les courbes épaisses aux valeurs retenues après l'accord. Les observations correspondent au produit L3b CERES (Energy Radiant Energy System) de Clouds et de la Terre (EBAF) pour Loeb et al. (2009). La hauteur du rectangle gris en (a) et l'épaisseur des courbes grises en (b) et (c) correspondent à une incertitude d'observation de ± 4 W m-2. Notez, cependant, que les vraies barres d'erreur ne sont pas disponibles pour ces observations.

Après les nuages, les paramètres d'accord les plus courants sont ceux entrant dans les paramétrisations de l'albédo de la neige et de la glace de mer, du mélange océanique et de la traînée orographique. Les propriétés du sol et de la végétation sont également parfois utilisées pour le réglage.

En raison des incertitudes dans les observations et dans la formulation du modèle, les choix de paramètres possibles sont nombreux et différeront d'un groupe de modélisation à l'autre. Ces choix devraient être plus souvent pris en compte dans les études d'inter-comparaison de modèles. La diversité des choix d'accord reflète l'état actuel de notre compréhension du climat, de l'observation et de la modélisation. Il est vital que cette diversité soit maintenue. Il est cependant important que les groupes communiquent mieux leur stratégie de réglage. En particulier, lorsque l'on compare des modèles sur une métrique donnée, que ce soit pour l'évaluation d'un modèle ou pour la compréhension des mécanismes climatiques, il est essentiel de savoir si certains modèles ont utilisé cette mesure comme cible de réglage.

APPLICATION DE MÉTHODES OBJECTIVES.

Il existe une abondante littérature sur l'optimisation paramétrique utilisant des approches objectives développées dans les communautés de la statistique, de l'ingénierie et de l'informatique. Par méthodes objectives, on entend qu'un cadre mathématique ou statistique bien fondé est utilisé pour effectuer le réglage du modèle, par exemple en définissant et en minimisant une fonction de coût ou en introduisant une formulation bayésienne du problème d'étalonnage (Kennedy et O'Hagan 2001 ). L'utilisation de méthodes objectives n'élimine en aucun cas la nécessité d'un jugement subjectif concernant les priorités et les objectifs du processus d'ajustement. Un algorithme objectif identifie simplement les parties de la procédure qui nécessitent l'expertise scientifique subjective du modélisateur. Il faut que le modélisateur formule ce jugement en termes de nombres ou de formules mathématiques, parfois très exigeantes mais contribuant aussi à rendre le processus de réglage plus explicite et reproductible. Les méthodes objectives fournissent alors une procédure d'accord automatique basée sur ces jugements.

De manière générale, les méthodes objectives tombent dans l'une des deux catégories. La première consiste à optimiser rapidement une fonction de coût en mesurant la distance entre les simulations du modèle et une petite collection d'observations. Les applications de telles méthodes dans la science du climat incluent Bellprat et al. (2012), Yang et al. (2013), Zou et al. (2014), et Zhang et al. (2015). La deuxième classe de méthodes représente une approche bayésienne et fait maintenant partie d'une classe de méthodes sous la bannière de la quantification de l'incertitude (UQ, Kennedy et O'Hagan 2001). UQ, pour le réglage des paramètres, vise à fournir une incertitude pour les paramètres en utilisant un modèle statistique reliant le modèle climatique aux observations qui quantifie explicitement les sources clés d'incertitude présentes dans le problème: incertitude d'observation, incertitude de condition initiale (variabilité interne) (physique manquante ou incorrecte). Les applications de ces méthodes aux modèles climatiques incluent Rougier (2007), Jackson et al. (2008), Edwards et al. (2011), et Williamson et al. (2013). Les méthodes UQ, par exemple, ont été utilisées pour fournir les projections climatiques du Royaume-Uni (Murphy et al., 2009, Sexton et al., 2012).

Les deux classes de méthodes objectives (optimisation et UQ) partagent des avantages par rapport à des approches d'essais et d'erreurs plus arbitraires qui se concentrent sur l'ajustement d'un ou deux paramètres à la fois. Par exemple, en perturbant plusieurs paramètres simultanément et systématiquement, les méthodes automatiques peuvent surmonter les inquiétudes selon lesquelles un optimum local pour un objectif peut ne pas être une bonne solution pour d'autres objectifs et peut même ne pas être un optimum global pour la métrique d'accordage (Qian et al. Williamson et al., 2015).

Les deux classes de méthodes partagent également certains des mêmes défis. Le principal défi est le coût de calcul du modèle climatique avec suffisamment de choix de paramètres pour explorer l'espace des paramètres. Pour les modèles climatiques à haute résolution (ou même leurs composants), la puissance de superordinateur disponible et le temps disponible entre les cycles de réglage, généralement de l'ordre de un à quelques années entre deux versions, limitent même les institutions les mieux équipées.

Pour surmonter ces problèmes de calcul, des émulateurs statistiques (également appelés métamodèles) peuvent être utilisés. Développés par des statisticiens depuis la fin des années 1980 (Sacks et al 1989, Currin et al., 1991, Haylock et O'Hagan, 1996), les émulateurs utilisent de petits ensembles de formation pour former des modèles statistiques capables de prédire la réponse du modèle climatique très rapidement. 2010), rapportant une mesure de l'incertitude (offrant généralement une distribution de probabilité complète pour le modèle climatique à tout choix de paramètres). L'incertitude de l'émulateur doit être incluse dans les méthodes UQ bayésiennes pour le réglage des paramètres, bien qu'elle soit ignorée dans certaines applications de méthodes d'optimisation avec la fonction de moyenne d'émulateur utilisée directement.

Pour les modèles haute résolution et les modèles avec un temps d'activation long, exécuter le modèle suffisamment pour créer un émulateur représente un énorme défi. Des ensembles de simulations plus courtes pour remplacer les simulations climatologiques traditionnelles à long terme ont été proposés (Wan et al., 2014), et la littérature UQ a longtemps proposé et démontré le succès de modèles couplés de résolutions différentes pour construire émulateurs. Par exemple, Williamson et al. (2012) ont construit un émulateur pour le modèle CMIP5, le Hadley Center Coupled Model, version 3 (HadCM3), utilisant seulement 16 intégrations et un grand ensemble de la version basse résolution Fast Met Office / U.K. Universities Simulator (FAMOUS). C'est un domaine de recherche actif en UQ.

Un défi majeur pour les méthodes de réglage automatique est que le réglage d'une poignée de métriques risque d'améliorer les performances de ces métriques au détriment du comportement non physique des métriques ou des processus qui ne sont pas utilisés pour le réglage, c.-à-d. les mauvaises raisons ». Ce problème, connu sous le nom de sur-ajustement ou de surchauffe, apparaîtra dès qu'une minimisation ou une sélection de paramètres effectuée ne tient pas correctement compte des incertitudes structurelles de l'observation et du modèle. Il apparaîtra également lors de l'ajustement à des observations partielles (c'est-à-dire, ne pas ajuster le vecteur d'état entier du modèle climatique) ou à des données de sur-ajustement qui sont en partie simplement de la variabilité naturelle (Notz 2015). Ensuite, le réglage peut être considéré comme un processus de compensation d'erreur plutôt que comme un calibrage de modèle. Le sursaut peut également se produire lors d'un réglage manuel, mais la confiance aveugle dans un outil automatique peut être plus risquée car elle nous empêche d'exercer la partie du jugement d'expert qui ne peut pas facilement être traduite en fonctions objectives ou exprimée mathématiquement comme incertitudes.

La surenchère est une réelle préoccupation et la raison d'être des méthodes bayésiennes UQ. Cependant, comme les principales sources d'incertitude dans le problème d'accord, l'incertitude d'observation et l'erreur structurelle sont si mal comprises et difficiles à quantifier, le réglage automatique a encore du chemin à parcourir avant d'être adopté par les principaux centres de modélisation. Une classe de méthodes UQ qui évite explicitement le «overtuning», appelé appariement historique, a récemment été proposée pour la communauté de réglage du modèle climatique (Williamson et al., 2015). Ils évitent le overtuning en changeant le problème de la recherche d'une seule valeur optimale des paramètres à la recherche de valeurs de paramètres inacceptables et en excluant itérativement les régions correspondantes de l'espace des paramètres.

RÉGLAGE ET AMÉLIORATION DU MODÈLE.

Bien que le tuning permette de réduire efficacement l’écart entre le modèle et les observations sélectionnées, il risque également de masquer des problèmes fondamentaux et le besoin d’amélioration du dit modèle.

Il est clair que nombre d’erreurs sont intrinsèques aux modèles et proviennent des approximations de paramètres clés et de leurs interactions. Par exemple, certains modèles sous-estiment systématiquement les précipitations sur les régions de mousson, alors que d'autres font le contraire. D'autres biais sont systématiques à travers les modèles, comme la présence d'une double zone de convergence intertropicale du Pacifique (ZCIT) persistante des deux côtés de l'équateur ou des biais chauds sur les océans tropicaux orientaux. Ces biais de modèle sont en effet souvent résistants au réglage du modèle. L'optimisation d'un modèle pour améliorer ses performances sur une cible spécifique dégrade souvent les performances sur d'autres métriques. Par exemple, l'ajustement d'un modèle pour améliorer la variabilité intrasaisonnière des précipitations dans les tropiques se fait souvent au prix de biais accrus dans l'état moyen (Kim et al., 2012).

De plus, l’introduction d’une nouvelle paramétrisation ou amélioration diminue souvent la compétence du modèle sur certaines mesures. La version préexistante d’un modèle est généralement optimisée à la fois par le tuning de paramètres incertains et la sélection de combinaisons de modèles donnant des résultats acceptables, induisant probablement des erreurs de compensation (over-tuning). Améliorer une partie du modèle peut alors empirer le soin apporté aux observations, même s’il est mieux formulé. Plus le tuning précédent a été poussé, plus il sera difficile de démontrer un impact positif de l’amélioration du modèle et d’obtenir un nouveau réglage acceptable. Dans ce sens, le tuning (en cas d’over-tuning) peux même ralentir le processus d’amélioration du modèle en empêchant l’incorporation d’idées neuves et originales. Cette difficulté est connue depuis des décennies dans les centres de prévision numérique opérationnelle et pourrait être surmontée en ne sur-pondérant pas les paramètres de performance climatique (ceux qui importent pour les utilisateurs finaux ou pour les modèles d'impact) par rapport aux processus. Les métriques orientées sur les processus ont pour but d'aider à relier les biais à grande échelle à la déformation de processus spécifiques à l'échelle des sous-maillages. Les mesures axées sur les processus comprennent, par exemple, la composition de nuages ou de précipitation par régimes dynamiques (Bony et al., 2004), la composition de profils d'humidité relative basés sur des percentiles de précipitations pour évaluer la sensibilité des systèmes de convection à l'humidité relative (Kim et al. ou en évaluant les propriétés microphysiques simulées des nuages (et leur co-variabilité) directement à partir des mesures par satellite (Suzuki et al., 2013).

D'autre part, le réglage peut mettre en évidence où l'amélioration du modèle est nécessaire. Si les valeurs de paramètres nécessaires pour satisfaire une mesure donnée sont en dehors de la plage acceptable, ou si différentes valeurs sont nécessaires pour différentes régions ou différents régimes climatiques, les développeurs peuvent envisager de revoir la formulation du paramétrage ou en développer de nouvelles. Ensuite, le processus de réglage peut être repoussé à un niveau plus profond à l'intérieur du modèle tout en augmentant le réalisme physique du modèle.

Pour les nuages et la convection, le développement du paramétrage est souvent réalisé en utilisant des versions à une seule colonne du modèle global par rapport aux simulations explicites à haute résolution des processus paramétrés suivant une stratégie définie il y a 20 ans (voir par exemple Ayotte et al. Liu et al., 2001). La simulation explicite donne accès à des variables difficilement accessibles par observation (comme les champs 3D de température et d'humidité ou vitesses verticales) mais aussi à l'estimation de paramètres sans contrepartie observationnelle (comme les taux d'entraînement et de désamorçage entre un panache moyen et son environnement ou vitesse moyenne de chute des cristaux de glace à l'échelle de la grille du modèle). De tels paramètres peuvent être déduits en échantillonnant et en caractérisant l'équivalent des structures paramétrées dans les simulations explicites, comme cela a été fait, par exemple, par Couvreux et al. (2010), pour calculer les vitesses de mélange entre un panache moyen et son environnement. Le processus de développement de paramétrisation peut ainsi aider à contraindre certains paramètres mais propose également des sous-modèles à base physique pour d'autres.

L'une des façons de réduire davantage les biais de modèle à grande échelle et les processus de développement de paramétrage consiste à définir une plage acceptable de valeurs de paramètres au lieu d'une seule valeur issue des études de processus susmentionnées et à utiliser cette plage lors de simulations globales. Pour atteindre cet objectif, les méthodes UQ pourraient être appliquées au modèle à colonne unique en utilisant des simulations de processus explicites comme référence. Il est important que la représentation de la turbulence, de la microphysique et du rayonnement continue d'être améliorée dans les simulations explicites à haute résolution, de sorte que la paramétrisation puisse être évaluée non seulement en termes de dynamique d'échelle sous-maille mais aussi termes de l'effet radiatif des nuages.

Une autre approche émergente consiste à utiliser des simulations initialisées ou poussées (Zhang et al., 2014) dans le processus de réglage. Dans les simulations poussées, le modèle est contraint de suivre la trajectoire observée en relaxant les vents et éventuellement la température et l'humidité vers l'analyse météorologique, avec une constante de temps de typiquement quelques heures. Avec des simulations initialisées ou décalées, la météorologie simulée et observée suit la même trajectoire et la comparaison avec les observations peut être faite au jour le jour. Le nudging par vent seulement permet de séparer l'accord de paramétrage pour une situation météorologique donnée (comme c'est le cas en mode 1D) de celui du couplage du paramétrage avec la dynamique à grande échelle. Le déplacement avec des constantes de temps assez courtes (typiquement de quelques heures) élimine la nature chaotique de la circulation atmosphérique à grande échelle et les lentes réactions de cette circulation sur des processus rapides (comme les nuages). Des simulations décalées ou initialisées peuvent également aider à accélérer le réglage des modèles climatiques à haute résolution.

Quelle que soit l'approche, il est nécessaire de s'appuyer davantage sur des études observationnelles à l'échelle du processus pour ajuster le budget radiatif d'une manière plus physique. Des progrès seront réalisés en intégrant davantage le réglage du modèle comme une analyse d'incertitude dans le processus de développement du paramétrage.

ACCORDER AU RECHAUFFEMENT DU XXE SIÈCLE?

L’augmentation d’à peu près un degré Kelvin de la température globale moyenne depuis le début de l’ère industrielle, désormais réchauffement du 20ème siècle, est une mise à l’épreuve de facto pour les modèles climatiques. Cependant, comme test de qualité du modèle il n’est pas sans défaut car le résultat désiré est connu de ceux qui le développent et devient par conséquent un objectif du développement.

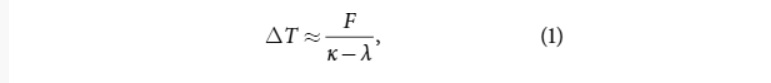

L'amplitude du réchauffement du vingtième siècle dépend principalement de l'ampleur du forçage radiatif, de la sensibilité au climat et de l'efficacité de l'absorption de chaleur par les océans. En linéarisant au sujet d'un état climatique stationnaire basique, le changement de température global moyen pour un forçage graduellement croissant peut être approché comme suit:

où T désigne la température de surface moyenne mondiale, F est un forçage radiatif imposé, κ est l'efficacité d'absorption de chaleur dans les profondeurs océaniques, et λ est le paramètre de rétroaction qui est inversement proportionnel à la sensibilité climatique d'équilibre (ECS ≈ -F / λ) . Les modèles climatiques ont des valeurs de λ comprises entre -0,6 et -1,8 W m-2 K-1 et κ entre environ 0,5 et 1,2 W m-2 K-1. En moyenne, dans les modèles, le dénominateur (κ - λ) est d'environ 2 W m-2 K-1, et en 2003, le forçage est d'environ 1,7 W m-2 (Forster et al., 2013).

où T désigne la température de surface moyenne mondiale, F est un forçage radiatif imposé, κ est l'efficacité d'absorption de chaleur dans les profondeurs océaniques, et λ est le paramètre de rétroaction qui est inversement proportionnel à la sensibilité climatique d'équilibre (ECS ≈ -F / λ) . Les modèles climatiques ont des valeurs de λ comprises entre -0,6 et -1,8 W m-2 K-1 et κ entre environ 0,5 et 1,2 W m-2 K-1. En moyenne, dans les modèles, le dénominateur (κ - λ) est d'environ 2 W m-2 K-1, et en 2003, le forçage est d'environ 1,7 W m-2 (Forster et al., 2013).

Le paradigme souvent déployé de la projection du changement climatique est que les modèles climatiques sont développés en utilisant la théorie et les observations actuelles, tandis que ECS est une propriété émergente du modèle et l'appariement du réchauffement du XXe siècle constituant une évaluation modèle a posteriori. Certains groupes de modélisation prétendent ne pas adapter leurs modèles au réchauffement du XXe siècle; Cependant, même pour les développeurs de modèles, il est difficile de s'assurer que cela est absolument vrai en pratique en raison de la complexité et de la dimension historique du développement du modèle.

La réalité de ce paradigme est remise en question par les découvertes de Kiehl (2007), qui a découvert l'existence d'une anti-corrélation entre le forçage radiatif total et la sensibilité climatique dans un ensemble modèle; les modèles à haute sensibilité se sont révélés avoir un forçage total plus petit et les modèles à faible sensibilité ont montré un forçage plus important, produisant moins de variation du réchauffement historique par rapport à l'ensemble croisé que prévu. Même si d'autres explications ont été proposées et même si les résultats n'étaient pas aussi clairs pour le CMIP5 (voir Forster et al., 2013), cela pourrait suggérer que certains modèles ont pu être adaptés par inadvertance ou intentionnellement au réchauffement du XXe siècle.

Il existe un large éventail de méthodes pour améliorer la ressemblance du modèle avec le réchauffement du 20ème siècle, allant de choisir simplement de ne plus modifier la valeur d’un paramètre sensible lorsque la représentativité est déjà bonne pour un modèle donné, ou de sélectionner des paramétrisations physiques qui améliorent la représentativité, jusqu’à clairement ajuster le forçage ou la rétroaction, tous deux incertains et dépendant de façon critique de paramètres ajustables. La sélection de modèle peut, par exemple, consister à choisir d’inclure ou d’exclure des processus nouveaux comme l’interaction entre nuages et aérosols pour mieux représenter le réchauffement historique, ou choisir de travailler ou remplacer une paramétrisation suspectée de causer un forçage irréaliste (trop haut ou trop bas) de la sensibilité climatique.

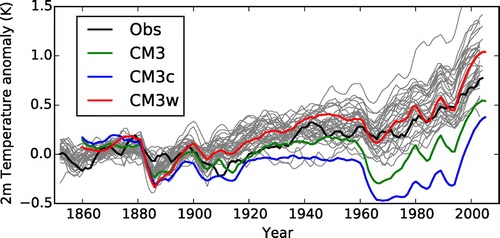

Une illustration de l'accord du XXe siècle avec le modèle GFDL-CM3 est présentée à la figure 3. Le modèle (vert) produit un réchauffement relativement faible au cours du XXe siècle en raison d'un fort effet de refroidissement des interactions aérosols-nuages. Les tests de sensibilité, effectués après congélation du modèle, ont montré qu'il est possible de réduire cet effet et d'obtenir ainsi un réchauffement plus réaliste. Cependant, ceci a été réalisé en abaissant la taille du seuil pour la conversion des gouttelettes de nuages en pluie à des valeurs plus petites que celles supportées par les observations (Golaz et al., 2013, Suzuki et al., 2013, et leurs références).

Fig. 3. Simulations de la température du vingtième siècle avec l'ensemble de modèles CMIP5 (courbes grises). Chaque courbe correspond à une moyenne mobile de 5 ans de l'anomalie de la température moyenne globale à 2 m au-dessus de la surface. L'anomalie est calculée en utilisant comme période de référence les années 1850-99. La courbe noire correspond à la version 4 des observations du Hadley Centre / Climatic Research Unit (HadCRUT). Les courbes colorées correspondent à trois configurations du modèle GFDL CM3. CM3 désigne le modèle CMIP5, tandis que CM3c et CM3w désignent des configurations alternatives avec un refroidissement plus ou moins important, respectivement, des interactions d'aérosols dans le nuage.

Fig. 3. Simulations de la température du vingtième siècle avec l'ensemble de modèles CMIP5 (courbes grises). Chaque courbe correspond à une moyenne mobile de 5 ans de l'anomalie de la température moyenne globale à 2 m au-dessus de la surface. L'anomalie est calculée en utilisant comme période de référence les années 1850-99. La courbe noire correspond à la version 4 des observations du Hadley Centre / Climatic Research Unit (HadCRUT). Les courbes colorées correspondent à trois configurations du modèle GFDL CM3. CM3 désigne le modèle CMIP5, tandis que CM3c et CM3w désignent des configurations alternatives avec un refroidissement plus ou moins important, respectivement, des interactions d'aérosols dans le nuage.

Ajuster le réchauffement du vingtième siècle nécessiterait en principe une série de simulations multicentenaires avec le modèle océan-atmosphère couplé en raison de la longue rotation de l'état de l'océan requise avant de commencer les simulations transitoires du vingtième siècle. Cependant, on sait depuis longtemps que de courtes simulations atmosphériques peuvent être utilisées pour estimer le forçage ajusté lorsqu'elles sont forcées avec une composition atmosphérique perturbée (Hansen et al., 2005) ou ECS lorsqu'elles sont soumises à des perturbations de la température de surface de la mer (Gettelman et al. al., 2012). Ainsi, il est possible de cibler des valeurs spécifiques de F et λ pensées pour fournir une bonne correspondance avec le réchauffement historique basé sur l'expérience avec les versions précédentes du modèle.

Tout réglage ECS devrait prendre en compte trois sources principales d'incertitudes. Tout d'abord, comme d'habitude, il ne faut pas oublier l'incertitude de l'observation de la température de surface moyenne mondiale, même si l'on pense aujourd'hui qu'elle est beaucoup plus petite que la dispersion inter-modèle. Alors le forçage radiatif F lui-même est incertain. Il est composé d'un forçage des gaz à effet de serre assez bien connu qui est en partie compensé par un forçage incertain des aérosols et modifié par une série d'autres agents de forçage moins importants. L'ajustement du XXe siècle pourrait, par exemple, être obtenu avec un ECS trop volumineux équilibrant un forçage radiatif d'aérosol trop fort. Dans un tel cas, et parce que l'effet des gaz à effet de serre dominera à l'avenir, cela entraînerait une surestimation du réchauffement climatique futur. La troisième source importante d'incertitude provient de la variabilité climatique interne qui peut entraîner des variations entre les réalisations avec des conditions initiales différentes de réchauffement typiquement de ± 0,1 K à 100 ans; Puisque l'observé ne représente qu'une telle réalisation, un modèle n'a pas besoin d'être plus proche que cela pour correspondre à la cible. Essayer de faire correspondre le réchauffement climatique du vingtième siècle sans tenir compte des sources d'incertitude conduirait inévitablement au dépassement.

La question de savoir si le réchauffement du 20ème siècle doit être considéré comme un objectif de développement de modèle ou une propriété émergente polarise la communauté de la modélisation du climat, avec 35 pour cent des modélisateurs déclarant que le réchauffement du 20ème siècle devait être considéré comme de très important à décisif, alors que 30 pour cent ne le prennent pas du tout en compte lors du développement. Certains voient les données de température comme des données d’évaluation indépendantes à ne pas utiliser, alors que d’autres les voient comme une observation pertinente contraignant le développement du modèle. De même les opinions divergent sur la question de savoir quelles mesures, du forçage et de l’ECS (Sensibilité Climatique à l’Équilibre), sont légitimes pour améliorer la correspondance du modèle avec le réchauffement observé. La question du développement en vue du réchauffement du 20ème siècle est par conséquent le sujet de vigoureux débats au sein de la communauté..

Cependant, la capacité à contrôler le réchauffement modélisé du vingtième siècle offre également de nouvelles possibilités d'explorer les limites de la sensibilité climatique modélisée (Golaz et al., 2013); En combinant l'altération du SCE et du forçage des aérosols, il est techniquement possible de construire des modèles aberrants de faible et de haute sensibilité qui correspondent au réchauffement observé. L'évaluation de tels modèles avec d'autres aspects observés, tels que le réchauffement du milieu du siècle ou les modes de variabilité, et leur utilisation dans des climats préhistoriques, tels que le Dernier Maximum Glaciaire ou le Pliocène, pourrait potentiellement nous permettre d'exclure les valeurs extrêmes de forçage ECS et / ou d'aérosols. .

Le fait que certains modèles soient explicitement ou implicitement adaptés pour mieux correspondre au réchauffement du vingtième siècle, alors que d'autres ne le sont peut-être pas, complique clairement l'interprétation des résultats des ensembles de modèles combinés tels que le CMIP. La diversité des approches est inévitable car les centres de modélisation individuels poursuivent le développement de leur modèle pour atteindre leurs objectifs scientifiques spécifiques. Cependant, il est essentiel que les décisions affectant le forçage ou la rétroaction durant le développement du modèle soient documentées de manière transparente.

CONCLUSIONS, IMPLICATIONS ET RECOMMANDATIONS.

Il y avait un débat entre les auteurs sur l'idée d'utiliser le mot art dans le titre de l'article. Tuning est considéré par certains modélisateurs comme un exercice d'étalonnage purement technique, qui consiste à appliquer des outils objectifs ou automatiques basés sur des considérations purement scientifiques. D'autres le voient comme un art expérimenté ou comme un art: "une compétence qui est atteinte par l'étude, la pratique ou l'observation". Comme dans l'art, il y a aussi de la diversité et de la subjectivité dans le processus de réglage du système et à cause des choix faits parmi les représentations également possibles du système. Il est essentiel de maintenir cette diversité dans les approches et l'ajustement des modèles en raison de la nature approximative des modèles, de l'absence de contreparties observationnelles pour de nombreux paramètres du modèle interne et de l'importance des prévisions de changement climatique pour lesquelles aucune observation n'existe.

Cette subjectivité ne contredit pas la nature scientifique fondamentale et double du réglage du climat. D'un côté, le processus d'accord implique de nombreuses questions scientifiques comme la compréhension physique des phénomènes à modéliser, la formulation algorithmique des lois physiques, la base mathématique de l'optimisation et les statistiques de la variabilité interne. À son tour, la compréhension des mécanismes du climat peut être inspirée par l'acte de réglage qui est intrinsèquement basé sur une vaste exploration des climats possibles à travers des expériences de sensibilité. Cela nous permet d'identifier et de comprendre le rôle des différents processus modélisés et des retours d'expérience impliqués. L'optimisation peut également aider à identifier les erreurs structurelles du modèle, par exemple, si la valeur optimale d'un paramètre tombe en dehors de la plage acceptable ou si différentes valeurs du même paramètre sont optimales pour différentes situations. En ce sens, le réglage est une forme d'analyse d'incertitude.

Le tuning affectant le comportement d’un modèle du climat, et la confiance que l’on peut accorder à l’utilisation particulière de ce modèle, il est important de documenter la part de tuning dans le processus de développement du modèle. Nous recommandons que pour le prochain exercice CMIP6, les groupes de modélisation fournissent un document spécifique sur leur stratégie et objectifs de tuning, qui serait référencé lors de l’accès données. Nous recommandons de distinguer trois niveaux dans le processus de tuning : tuning de paramétrisation individuelle, tuning de composant et tuning de système climatique. Au niveau du composant, l’accent doit être mis sur le poids relatif donné aux indicateurs de performance climatique par rapport à ceux inhérents au processus, et sur les conflits possibles avec le niveau de tuning de paramétrisation..

Pour le tuning du système climatique, on doit insister particulièrement sur la façon dont l’équilibre énergétique a été obtenu dans le système complet : a-t-il été fait par ajustement indépendant des divers composants, ou un réglage final a-t-il été nécessaire ? On doit aussi décrire la mesure dans laquelle on a ou non utilisé la tendance du 20ème siècle pour l’ajustement. Les comparaisons avec les observations, l’ajustement du processus de forçage ou de rétroaction devraient être notés. A chaque étape, on doit mettre en lumière toute occasion où une équipe a du se battre avec un paramètre ou le pousser aux limites pour résoudre une déficience particulière du modèle. Cette information peut être valable scientifiquement comme une trace de l’incertitude d’une formulation de modèle.

Il serait également utile de produire et de documenter deux ou plusieurs versions du même modèle qui ne diffèrent que par leur réglage. On peut imaginer changer un paramètre dont on sait qu'il affecte la sensibilité, en gardant ce paramètre et l'ECS dans la fourchette acceptable prévue et en réaccordant le modèle autrement avec la même stratégie vers les mêmes cibles.

Enfin, le développement de nouvelles méthodologies est fortement encouragé. Parmi les idées les plus prometteuses, citons: 1) l'utilisation systématique des simulations à colonne unique par rapport aux simulations explicites, 2) l'utilisation de métriques axées sur les processus et 3) les simulations avancées pour combler le vide entre paramétrage et ajustement des composants. L’utilisation systématique de méthodes objectives au niveau du processus de façon à estimer la plage de valeurs paramétriques acceptable pour le tuning au niveau supérieur est probablement une stratégie à encourager et peut aider à rendre le processus de tuning du modèle plus transparent et traçable.

Il est légitime de se demander si le tuning doit être effectué de préférence au niveau du processus, et l’équilibre radiatif global et autres métriques climatiques utilisées pour une évaluation à postériori de la performance du modèle. Il serait bon d’évaluer notre degré actuel de compréhension du système climatique et d’estimer le niveau d’incertitude de l’ECS. Restreindre l’ajustement au niveau du processus peut être également une bonne façon d’éviter les erreurs structurelles de compensation du modèle dans la procédure de tuning.

Cependant, en raison de la nature multi-applications des modèles climatiques, des problèmes de cohérence au sein du modèle et de ses composants, des limitations des procédures d’études métriques (problèmes d’échantillonnage, manque de contraintes énergétiques), et aussi tout simplement parce que le système climatique lui-même n’est pas observé avec suffisamment de fidélité pour contraindre pleinement le modèle, un réglage à postériori restera probablement nécessaire pour quelque temps. Ceci est spécialement important pour les contraintes de l’énergie globale qui sont un aspect fort et fondamental des modèles du climat global. L'ajustement sera généralement effectué en ajustant les paramètres les plus incertains impliqués dans la représentation des processus qui affectent le plus les rayonnements tels que les cirrus ou les nuages bas dans des limites acceptables. Le réglage induira probablement une compensation des défauts ou des erreurs dans les paramétrages ou la configuration du modèle. Cependant, cette compensation d'erreur est probablement inévitable et souhaitable pour les modèles actuels, en raison de l'importance de l'accord énergétique pour une simulation raisonnable de la plupart des aspects du système climatique. Le niveau de précision requis pour le réglage global de l'énergie (de quelques dixièmes de watts par mètre carré) est, par exemple, inférieur à l'erreur résultant du non-calcul du rayonnement à chaque pas de temps, comme souvent pour économiser les calculs (sur le ordre de plusieurs watts par mètre carré, voir par exemple Balaji et al., 2016). Il est toutefois recommandé de s'assurer que l'accord global final n'est pas obtenu pour un ensemble de valeurs de paramètres qui ne seraient pas acceptables en termes d'études de processus et de métriques axées sur les processus.