"Nous croulons sous l'information, mais la connaissance nous échappe"

"Nous croulons sous l'information, mais la connaissance nous échappe"

(E.O. Wilson, biologiste américain [1])

L’effet de serre est l’un des mécanismes qui régissent le climat terrestre. En gros, les gaz à effet de serre (GES : vapeur d’eau, dioxyde de carbone, méthane, etc.) piègeraient l’énergie solaire en la laissant entrer, mais pas ressortir.

On sait tous que le « réchauffement climatique » a quelque chose à voir avec un « effet de serre », mais lorsqu’il s’agit d’aller plus loin, les propos tournent s’appuient sur de nombreuses fausses conceptions.

En l’absence de quantification fiable des paramètres globaux tels que la sensibilité climatique, le GIEC appuie ses prévisions sur les simulations issues de vastes modèles numériques.

Nous reprenons ici des extraits d’un article rédigé par Philippe de Larminat pour aider à la compréhension. Diplôme d’ingénieur en 1964 (et Ph. D. en 1972), il a été Professeur à l’Institut National des Sciences Appliquées (Rennes, France) et à l’Ecole Centrale (Nantes). Il est l’auteur de 6 ouvrages et de plus de 100 articles publiés dans des journaux et lors de conférences internationales. Depuis 2001, il est consultant indépendant et auteur de plusieurs brevets (par exemple contrôle de centrales électriques, guidage de satellites).

Ses intérêts de recherche incluent la modélisation mathématique, l'identification des processus, le traitement de signaux et la théorie du contrôle. Depuis 2012, il poursuit un travail de pionnier sur l'identification du système climatique terrestre.

Transcription : les2ailes.com

Sommaire

- Chercher à comprendre ?

- Des conceptions fausses.

- Une représentation correcte de l’effet de serre.

- Un peu de physique.

- L’effet de serre en action, de visu.

- Que retenir ?

- Fiabilité des modèles climatiques.

- Conclusion.

1. Chercher à comprendre ?

L’effet de serre est l’un des mécanismes qui régissent le climat terrestre. En gros, les gaz à effet de serre (GES : vapeur d’eau, dioxyde de carbone, méthane, etc.) piègeraient l’énergie solaire en la laissant entrer, mais pas ressortir. En simplifiant, on peut dire que :

1 – Les GES sont transparents au rayonnement énergétique solaire (véhiculé dans le spectre visible), qui peut ainsi réchauffer la surface terrestre.

2 – Ils ont la capacité d’absorber le rayonnement infrarouge émis par la surface terrestre, et aussi de le réémettre. Ils modulent ainsi l’évacuation de la chaleur vers l’espace en fonction de leur concentration.

En l’absence de GES, le climat terrestre n’aurait rien à voir avec ce qu’il est. Le véritable problème est celui de la quantification. En effet, la concentration de CO2 pourrait bientôt avoir doublé par rapport à son niveau préindustriel. Les effets prévisibles d’une telle variation sont-ils insignifiants ou potentiellement catastrophiques ? Toute la question est là.

On aimerait pouvoir répondre à cette question par quelque calcul imparable, issu des lois élémentaires de la physique, basé sur quelques constantes naturelles (chaleurs massiques, constante de Stephan[1bis]…), et quelques données d’observation, telles que le flux énergétique solaire intercepté par la Terre. Certains calculs sont immédiats et ne manquent pas d’intérêt. Par exemple, celui qui permet d’estimer à –18 °C la température de la surface terrestre en l’absence d’effet de serre. Mais cela ne suffit pas pour déterminer si la « sensibilité climatique à l’équilibre au doublement de CO2 » est insignifiante, de l’ordre du degré, ou beaucoup plus préoccupante (jusqu’à 6 °C).

En fait, l’effet de serre est indissociable de l’ensemble du processus climatique. Ce sont toutes les équations de la physique climatique qu’il faut associer et résoudre, sur l’ensemble de la surface terrestre. Globalement, ces équations sont analytiquement insolubles, de par leur nombre et leur complexité. La seule façon de les exploiter consiste à les organiser en modèles mathématiques, simulables par calculateur numérique, et à expérimenter sur la « planète numérique » ainsi obtenue. Si on pouvait déterminer directement la dépendance des équilibres climatiques vis-à-vis des variables causales (activités humaine, solaire, volcanique), ce serait un grand pas de fait, mais pour obtenir ces états d’équilibre, il faut en passer par la simulation des états transitoires.

Les modèles climatiques dérivent des modèles météorologiques. Ces derniers s’intéressent aux phénomènes à court terme : le jour ou la semaine ; les premiers voient à long terme : au moins dix ans. Néanmoins, ils sont basés sur le même principe : la résolution des équations de la physique par une technique dite des éléments finis [2], qui consiste à décomposer mentalement l’atmosphère (et les océans) en cellules (ou mailles) suffisamment petites pour que leur état (température, pression, humidité, vent, courant, etc.) puisse y être considéré comme homogène. On calcule alors l’évolution de cet état sur un pas de temps fini, et on recommence. Le problème est que la nature des choses exige des pas de temps de quelques dizaines de minutes au plus, même lorsque les modèles climatiques doivent simuler sur des durées se comptant en centaines d’années. Pour ne pas conduire à des temps de calcul prohibitifs, les mailles doivent être sensiblement plus grandes que celles des modèles météo, ceux-ci déjà très voraces en puissance de calcul.

L’intégration par éléments finis exige des simplifications et des approximations déjà délicates pour les modèles météo, et plus encore pour les modèles climatiques. La simulation des équations relatives aux écoulements turbulents engendre – comme dans la réalité – des comportements aléatoires, nécessitant de nombreuses simulations pour en extraire les comportements moyens. Beaucoup de phénomènes ne sont modélisables qu’empiriquement ; par exemple les sursaturations ou surfusion dans les nuages, l’évaporation en surface, fortement tributaire du vent, de l’état de la mer ou de la végétation. Enfin divers phénomènes physiques sont encore mal élucidés (influence du rayonnement cosmique). Certains sont peut-être encore totalement insoupçonnés[3].

Globalement, les modèles climatiques restent néanmoins basés sur les mêmes équations que les modèles météorologiques, dont personne n’imagine qu’ils pourraient enfreindre les lois fondamentales de la physique. Et pourtant, les prévisions (ou projections[4]) des modèles climatiques sont beaucoup plus contestées que celles des modèles météo. Ces derniers seront toujours perfectibles, mais leurs limites sont contraintes par le chaos atmosphérique bien plus que par des incertitudes ou des défauts de connaissance, qui affectent peu le comportement à court terme. À l’échelle des temps climatiques, le chaos océanique prévaut, et des défauts de modélisation sans conséquence en météorologie peuvent devenir rédhibitoires. C’est en particulier le cas de tout ce qui concerne le bilan radiatif de la planète : une erreur systématique de quelques Wm–2 en plus ou en moins ne change rien aux prévisions météorologiques à court terme, mais bouleverse de fond en comble les prévisions climatiques à long terme. Les modèles climatiques ne peuvent donc se targuer de leur parenté avec les modèles météo pour garantir leur fiabilité.

Dans ce contexte, il importe évidement d’évaluer la confiance qu’on peut accorder aux modèles climatiques, ce qui ne signifie pas remettre en cause leur conception générale, basée tantôt sur les lois de la physique, tantôt sur des lois empiriques a priori recevables.

Pour synthétiser les résultats de simulation, une démarche rationnelle consiste à en extraire des paramètres climatiques globaux, comme, par exemple, la sensibilité climatique – laquelle désigne, en l’absence d’autre précision, la sensibilité à l’équilibre de la température globale à un hypothétique doublement de concentration de CO2. D’autres paramètres climatiques ont pour nom forçage radiatif, réaction climatique, etc. « Comprendre l’effet de serre » et, plus généralement, comprendre les modèles climatiques, consiste à percevoir des relations claires entre les différents phénomènes, à déterminer comment interviennent les paramètres climatiques, sans se laisser submerger par le détail de la complexité des modèles numériques.

Qui, dira-t-on, peut prétendre avoir « compris » les modèles numériques, sinon leurs propres concepteurs? Mais est-il certain qu’ils les aient eux-mêmes vraiment compris ? La question se pose : nous connaissons tous des ingénieurs ou des chercheurs capables d’aligner des équations au kilomètre sans en percevoir véritablement la signification[5]. Curieusement, on rencontre des dizaines de fois l’expression « bien compris » (well understood) dans le rapport 2013 du groupe 1 du GIEC, dévolu aux fondements scientifiques de la question climatique. Elle est accompagnée, tantôt de « maintenant » (en 2013, il est temps !), tantôt de « pas encore ». La science climatique est-elle mature ?

Concernant l’effet de serre, tout le monde s’accorde à le présenter comme un processus essentiellement radiatif, qui module l’évacuation par la Terre de la chaleur reçue du soleil. En réalité, l’évacuation se fait en deux étapes : 1. Transport de la chaleur en altitude via les transferts radiatifs et la circulation atmosphérique. 2. Rayonnement de la chaleur vers l’espace, par les hautes couches atmosphériques. Le premier volet est aussi important que le second pour la compréhension de l’effet de serre.

A travers leurs myriades d’équations, les modèles climatiques tentent de reproduire la réalité de l’effet de serre, aux approximations numériques et paramètres empiriques près. Mais si les concepteurs avaient réellement compris ce qui se passe dans leurs modèles, ils seraient capables d’expliquer clairement la décomposition fondamentale en deux étapes annoncée ci-dessus, et on ne verrait pas les vulgarisateurs ressasser indéfiniment les mêmes à-peu-près ou inexactitudes. Je mets au défi quiconque de trouver sur internet un schéma analogue à notre figure 3 (voir plus loin), accompagnée du discours approprié, qu’il soit exposé par les alarmistes ou par les sceptiques de l’effet de serre. Quiconque n’a pas assimilé un tel schéma peut-il prétendre avoir compris l’effet de serre ? Et quel est le niveau de compréhension des soi-disant 97.1 % de « scientifiques du climat » qui participent au consensus selon lequel le dernier réchauffement climatique serait d’origine humaine ? Combien sont capables de décrypter le spectre d’émission infrarouge issu de la Terre (voir la figure 9) ?

Mais, dira-t-on, l’essentiel n’est-il pas que les modèles simulent correctement la réalité ? Et peu importe alors la « compréhension » et les éclaircissements qui devraient les accompagner. Il importe pour deux raisons. La première est que les physiciens, les astronomes, les biologistes ou les ingénieurs sont généralement capables de mettre leurs travaux à la portée du grand public, qui peut ainsi se faire une idée de leur sérieux. Pourquoi pas les climatologues ? Le climat est-il réellement plus complexe que le moindre organisme vivant ? La deuxième est que si le public comprenait mieux, il pourrait éprouver quelque scepticisme devant des projections climatiques issues de modèles dont il percevrait alors l’ampleur des incertitudes.

2. Des conceptions fausses

On sait tous que le « réchauffement climatique » a quelque chose à voir avec un « effet de serre », mais lorsqu’il s’agit d’aller plus loin, les propos tournent souvent au n’importe quoi. Analysons le texte capital ci-dessous :

« En se concentrant dans l’atmosphère, les gaz à effet de serre empêchent la chaleur des rayons solaires réfléchis par la terre de se perdre dans l’espace ».

Relisons : il est bien question de rayons solaires réfléchis par la Terre. Or la physique est là : les gaz à effet de serre sont pratiquement transparents dans le spectre visible, sans effet sur le rayonnement solaire, avant comme après réflexion[6]. Les GES n’interfèrent qu’avec le rayonnement infrarouge. Ce dernier est de nature différente : il est émis, et non pas réfléchi par la surface terrestre. Ceci est du niveau SVT[7].

Scientifiquement, cet énoncé ne tient donc pas debout. Peu importe, dira-ton : le message est que l’effet de serre a quelque chose à voir avec des gaz dits justement à effet de serre (réputés imputables à l’activité humaine) et qu’il concerne des rayonnements. Il importe beaucoup quand on sait que le texte ci-dessus s’adresse à l’humanité entière, étant extrait de l’encyclique « Laudato si » (18 juin 2015)[8]. À ce niveau, on n’a pas le droit de manifester une telle ignorance les lois élémentaires de la physique (qu’il s’agisse du Pape ou de ses conseillers, peu importe : c’est au chef d’assumer)[9]. Plutôt que de faire étalage d’ignorance, mieux vaudrait se taire, surtout quand la suite revendique un « consensus scientifique très solide » concernant l’attribution du réchauffement climatique aux gaz à effet de serre d’origine humaine.

Mais que vaut ce consensus ? Une recherche sur Internet pour effet de serre retourne plusieurs centaines d’images, toutes plus ou moins semblables à la figure 1 qui suit[10]. On en trouve d’analogues dans tous les manuels scolaires de SVT. Malheureusement, de telles figures propagent des idées fausses à la pelle.

Figure 1. Effet de serre : Un catalogue d’idées fausses

Figure 1. Effet de serre : Un catalogue d’idées fausses

Bien évidemment, les gaz à effet de serre (GES) ne sont pas localisés dans une couche mince analogue à la paroi vitrée d’une serre horticole[11]. Bien entendu, les GES ne sont pas responsables de la fraction d’énergie solaire renvoyée vers l’espace (en haut à gauche) : cette fraction est réfléchie par le sol et les nuages (le coefficient de réverbération total a pour nom albédo, et il est de l’ordre de 30 %). Chacun sait aussi – ou devrait savoir– que rayonnement infrarouge ne joue pratiquement aucun rôle dans les serres horticoles : elles fonctionnent très bien avec des parois plastiques transparentes aux infrarouges : elles sont un obstacle aux courants d’air, pas au rayonnement.

La figure 1 suggère encore (en haut à droite) que les GES réfléchissent vers la surface une partie du flux infrarouge rayonné par celle-ci. Faux encore : les GES ne réfléchissent pas le rayonnement : ils agissent par absorption et émission. Un effet de serre dont le principe serait conforme à cette figure violerait les lois de la physique : la surface ne saurait être réchauffée par le flux infrarouge rayonné en altitude par les gaz à effet de serre, puisque l’atmosphère en altitude est plus froide que la surface : cela contreviendrait au second principe de la thermodynamique, qui établit l'irréversibilité des phénomènes physiques, en particulier lors des échanges thermiques.

Le texte de la figure 1 énonce que « les gaz à effet de serre retiennent une partie de la chaleur émise ». Est-ce bien vrai ? En situation d’équilibre thermique, le total des flux énergétiques évacués vers l’espace doit équilibrer le flux reçu du soleil. Or les GES n’interviennent pas sur l’albédo, (du moins en première approximation). Le flux infrarouge restitué vers l’espace reste donc le même, quelle que soit la concentration de GES. Certes, ceci n’est vrai qu’à l’équilibre, mais cette invariance contribue aux difficultés de compréhension de l’effet de serre.

Après cette critique de la figure 1, passons à un extrait du document suivant : Le climat, collection « CEA jeunes », 15eme volume. http://www.cea.fr/comprendre/Pages/climat-environnement/climat.aspx?Type=Chapitre&numero=5

« À 15 °C (288 K), la Terre émet un rayonnement infrarouge dont le maximum d’intensité se situe à une longueur d’onde de 10 μm. Dans la gamme de longueurs d’onde de ce rayonnement infrarouge, un certain nombre de gaz présents à l’état de traces dans l’atmosphère l’absorbent.  L’atmosphère, qui est transparente à la quasi-totalité du rayonnement solaire incident, se comporte donc comme un absorbeur qui piège une part importante du rayonnement tellurique. Ainsi réchauffée, elle se comporte aussi comme un corps noir, qui va rayonner de l’énergie sous forme infrarouge. À cause de sa température plus froide, l’atmosphère va rayonner moins d’énergie que la surface. Et comme elle la rayonne de façon isotrope, la moitié du rayonnement réémis va l’être en direction de la surface de la Terre. Il va donc y avoir piégeage de l’énergie entre l’atmosphère et la surface, et donc un réchauffement de la surface ».

L’atmosphère, qui est transparente à la quasi-totalité du rayonnement solaire incident, se comporte donc comme un absorbeur qui piège une part importante du rayonnement tellurique. Ainsi réchauffée, elle se comporte aussi comme un corps noir, qui va rayonner de l’énergie sous forme infrarouge. À cause de sa température plus froide, l’atmosphère va rayonner moins d’énergie que la surface. Et comme elle la rayonne de façon isotrope, la moitié du rayonnement réémis va l’être en direction de la surface de la Terre. Il va donc y avoir piégeage de l’énergie entre l’atmosphère et la surface, et donc un réchauffement de la surface ».

Un grand absent dans ce texte : la circulation atmosphérique qui transporte la chaleur en altitude depuis la surface. Et une formulation mal venue : l’atmosphère étant en contact avec la surface de la Terre, il n’y a rien entre les deux qui puisse piéger l’énergie !

C’est pourtant là que maints auteurs de manuels de SVT vont trouver leurs explications de l’effet de serre ! Les climatologues les plus avertis (et eux seul) savent que ce texte n’est pas une vision pédagogique ou simplifiée de l’effet de serre, mais une vision fausse. Il s’appuie sur une atmosphère supposée en équilibre radiatif, ce qui est faux en soi et conduit à une absurdité maintes fois signalée par d’autres : un « piégeage de l’énergie entre l’atmosphère et la surface » : les équations basées sur un équilibre radiatif conduisent à une discontinuité en surface incompatible avec prémisses de ces mêmes équations. Les compétences du CEA en matière climatique sont issues du Laboratoire des sciences du climat et de l’environnement (LSCE : CEA-CNRS-UVSQ/IPSL), que faut-il penser de ce dernier ?

Que conclure de toutes ces conceptions fausses ? Paradoxalement, même si celles-ci émanent du GIEC, à travers des scientifiques ou des vulgarisateurs qui s’en réclament, le GIEC reste inattaquable.

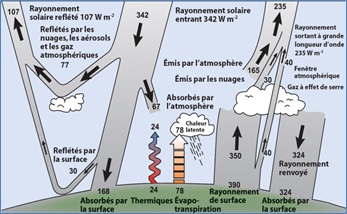

Figure 2. Les flux énergétiques, selon le GIEC

Figure 2. Les flux énergétiques, selon le GIEC

S’il est facile en effet de se livrer à une critique des conceptions du GIEC à travers ce genre de représentation, la moindre des choses consiste à remonter à la source, par exemple à la figure 2, reprise du troisième rapport d’évaluation du GIEC, elle-même publiée initialement par Trenberth[12] (2009). Nous la critiquerons le moment venu, mais elle est exempte des principales erreurs introduites par des illustrateurs et vulgarisateurs mal inspirés.

De toute façon, les évaluations climatiques du GIEC se fondent essentiellement sur l’exploitation de ses modèles numériques. Ce sont donc les modèles qu’il faut critiquer si on veut en contester les conclusions. Le problème est que ces modèles sont à la limite invérifiables, à moins de s’y immerger, armé de connaissances encyclopédiques, et d’être en même temps parfaitement au fait des techniques numériques de simulation par éléments finis. Existe-t-il de tels experts universels, même au sein du GIEC ? Cette invérifiabilité de fait ne doit empêcher, ni les experts, ni les honnêtes gens, de chercher à dégager les aspects fondamentaux du processus climatique, et de s’en faire une idée qui ne soit pas caricaturale : les climatologues ne sont a priori ni des ignares ni des faussaires.

Il existe un juste milieu entre l’impossible critique approfondie et détaillée des modèles du GIEC, et la confiance aveugle en leurs concepteurs. Entre les deux, se trouve la représentation mentale, si possible quantifiée, que l’on peut se faire des mécanismes climatiques, permettant de porter un jugement sur le caractère pertinent ou fallacieux des arguments mis en avant pour défendre l’origine humaine ou non du réchauffement climatique.

3. Une représentation correcte de l’effet de serre

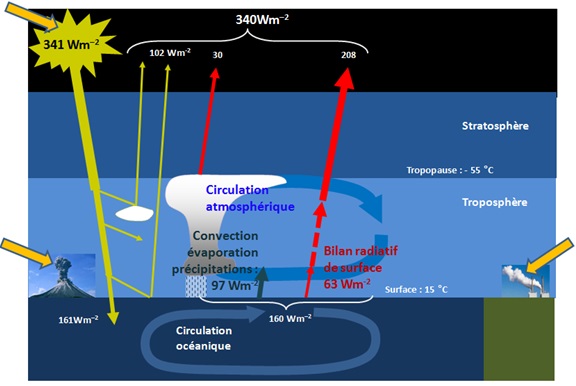

Le principal défaut de la figure 1 et de ses pareilles, même expurgées des erreurs les plus grossières, est de focaliser l’attention sur les échanges énergétiques par rayonnement, en omettant le rôle fondamental joué par la circulation atmosphérique dans le processus d’évacuation de la chaleur vers l’espace. La figure 3 vient combler cette lacune.

Figure 3. L’effet de serre : une autre perception

Figure 3. L’effet de serre : une autre perception

Pour la lisibilité, on a omis la fraction de flux solaire directement absorbée par l’atmosphère, et le rayonnement émis directement depuis la surface vers l’espace, à travers la « fenêtre atmosphérique » (cf. fig. 2), l’un comme l’autre secondaires en première approximation.

On retrouve d’abord (à gauche) les notions communément admises relatives au rayonnement solaire

- Le flux solaire incident. Lorsque le soleil est au zénith, la terre reçoit environ 1 367 Watts /mètre carré. C’est la « constante solaire », faiblement variable avec les paramètres orbitaux et l’activité solaire. Compte tenu de l’effet jour/nuit, il faut diviser par 2. Compte tenu de la rotondité de la demi-face éclairée, il faut encore diviser par 2. D’où les 342 Wm–2 indiqués sur la figure.

- Albédo. Une partie du flux incident est directement renvoyée vers l’espace, soit par réflexion sur sol, soit par la face supérieure des nuages. Le coefficient de réverbération global, ou albédo, est d’environ 30 %. Le reste, soit 240 Wm–2 est absorbé par la surface, qu’il réchauffe. Pour simplifier, on n’a pas représenté ici les fractions minimes absorbées ou diffusées par l’atmosphère.

- Conservation de l’énergie. En situation d’équilibre climatique, la terre doit évacuer autant de chaleur qu’elle en reçoit. Les 240 Wm–2absorbés doivent donc être renvoyés vers l’espace. Les échanges de matière avec l’espace étant infinitésimaux, celui-ci ne peut absorber que de l’énergie rayonnée, et ceci dans le spectre infrarouge (flux représentés en rouge). Comme indiqué sur la figure 3, les sources d’émission sont, soit les formations nuageuses (brouillards d’eau liquide ou de cristaux de glace), soit les gaz à effet de serre eux-mêmes (vapeur d’eau comprise).

Les flèches rouges représentent les échanges par rayonnement infrarouge. La partie en tirets symbolise la cascade d’émissions, absorption, réémission et rétro-émissions engendrés par la présence des gaz à effet de serre. La symbolique de cette représentation en tirets est que, en première approximation, les couches basses de l’atmosphère sont opaques aux infrarouges : le rayonnement émis par le sol ou par les couches basses est totalement absorbé par les couches adjacentes : aucun photon émis par la surface n’atteint directement l’espace[13].

Il en résulte que la source des rayons infrarouge atteignant l’espace ne se situe pas au sol, mais en altitude, là où la raréfaction de l’air (et des GES) finit par rendre l’atmosphère transparente aux IR. Évidemment, la transition est progressive entre une troposphère opaque et une stratosphère transparente, et cette altitude est variable aussi avec la longueur d’onde du rayonnement, selon les bandes d’absorption des différents GES présents et leur concentration.

Pour boucler le circuit énergétique, il faut décrire enfin comment la chaleur absorbée par la surface parvient à rejoindre les sources d’émission en altitude. Le cheminement est complexe. Il fait intervenir la circulation océanique, la diffusion par conduction dans le sol des continents, la fonte et la reconstitution des glaces polaires, les échanges à travers la surface, par rayonnement, convection et évapotranspiration (la flèche verte regroupe l’ensemble de ces modes de transmission), la cascade d’émissions-réémission troposphérique, enfin la circulation atmosphérique, qui transporte en altitude l’air chaud de la surface, où il se refroidit en rayonnant vers l’espace, avant de revenir à son point de départ.

Dans les cours de physique de l’atmosphère, plusieurs pages de calcul sont parfois consacrées à la détermination du «transfert radiatif ». Il faut d’ailleurs distinguer entre la fraction qui atteint directement l’espace, nulle en dehors d’une « fenêtre atmosphérique» étroite, et le total du flux IR émis vers l’espace.

Le calcul fait intervenir le profil de température de l’atmosphère, dont dépend la puissance des émissions IR. Il faut distinguer le profil thermique radiatif théorique, qui résulterait du seul équilibre des émissions-réémissions par les GES, dans une atmosphère immobile, et le profil thermique réel, fortement affecté par la circulation atmosphérique. Seul le dernier nous intéresse évidemment.

Et il faut encore distinguer entre le rayonnement réémis par les GES et le rayonnement issu des nuages. Notre figure 3 ne représente ni ne quantifie le détail des flux énergétiques : elle se contente de ne pas véhiculer d’idées fausses.

En fait, l’opacité aux infrarouges mentionnée ci-dessus dérange tout le monde. D’un côté elle contredit l’objection « de bon sens » selon laquelle la très faible concentration des GES (0.04 % pour le CO2)[14] serait incompatible avec quelque action réelle sur le climat. À l’opposé, elle semble impliquer que l’effet de serre serait saturé, c’est-à-dire insensible à tout accroissement supplémentaire de concentration de GES.

En réalité, il existe pourtant un mécanisme d’action du CO2. Il est clair qu’un accroissement de concentration des GES va augmenter l’altitude où l’atmosphère devient transparente aux infrarouges, c'est-à-dire l’altitude d’émission, celle où le rayonnement émis peut atteindre l’espace. La température chutant avec l’altitude, le rayonnement émis diminue avec celle-ci, ce qui restaure une modulation de l’effet de serre par la concentration des GES.

Mais voici un nouveau rebondissement. Si la zone d’émission par les GES s’élève jusque dans la stratosphère, où la température d’émission ne décroît plus avec l’altitude, l’effet de serre va derechef se retrouver saturé.

En définitive, ce ne sera pourtant pas au point d’annihiler complètement toute action des GES sur les bilans radiatifs. À ce niveau, discourir est vain ; il faut quantifier. Les calculs de transfert radiatifs effectués à partir d’un profil d’atmosphère standard montrent qu’un doublement de CO2 induirait, toutes choses égales par ailleurs, une variation de flux infrarouge vers l’espace de 3.4 Wm–2 (figure 11), ce qui n’est pas négligeable, mais n’est jamais que de l’ordre du centième des flux énergétiques échangés avec l’espace.

Ces calculs sont incontestables, mais irréalistes en ce sens qu’ils supposent un ciel clair, « sans nuages ni autres aérosols » pour reprendre l’hypothèse retenue par le Giec dans ses exercices d’intercomparaison de codes de transfert radiatifs[15]. Et puis, le calcul du déséquilibre radiatif n’est qu’une première étape dans la détermination de la température d’équilibre qui va en résulter. Dans les modèles, les incertitudes sur l’ensemble de tous les échanges thermiques interfèrent et dominent de très loin celles qui concernent la faible contribution des échanges radiatifs internes. La quasi-saturation de l’effet de serre ne les empêche pas de conduire aux projections catastrophistes que l’on sait. Néanmoins, le GIEC ne tient pas trop à communiquer sur toutes ces saturations, suivant en cela en les conseils du Professeur Schneider (… faire des déclarations simplifiées et dramatiques et éviter de mentionner le moindre doute que nous pourrions avoir). Il y a place en effet pour le doute, non dans les codes de transfert programmés, mais dans la pertinence d’intercomparaisons académiques basées sur une atmosphère sans nuages et respectant un profil de température standard parfaitement conventionnel.

De tout cela, il ressort déjà que l’effet de serre est autrement plus complexe que les visions simplistes, qu’elles soient développées dans les livres scolaires, les sites de vulgarisation, une encyclique ou même certaines hypothèses du GIEC. Il convient donc de poursuivre notre effort de compréhension.

4. Un peu de physique

La principale des lois physiques du rayonnement est extrêmement simple. C’est la loi de Stephan-Boltzmann. Elle régit la puissance rayonnée par une classe d’objets idéalisés, dit corps noirs, en fonction de leur température T (en degré Kelvin) : P = σT4

où P est en W par mètres carrés de surface rayonnante, et où σ = 5.67 10-8 est la constante de Stéphan.

Le soleil se comporte, avec une très bonne approximation, comme un corps noir. Avec une température superficielle de l’ordre de 6 000 K, chaque mètre carré de soleil rayonne vers l’espace une puissance de 73 MW. Vu la décroissance fonction du carré de la distance, il parvient 1 366 Wm–2 au niveau de la Terre.

On entend souvent dire qu’en l’absence d’effet de serre, la température de la surface terrestre serait de – 18 °C. C’est une application directe de la loi de Stefan : sachant que la Terre doit évacuer via les infrarouges (figure 3), on trouve effectivement T = (P/σ )1/4 = 255K, soit – 18 °C. On moque parfois ce calcul comme relatif à une planète imaginaire, sans atmosphère, sans eau, ni nuages, ni végétation, ni océans, mais dont la capacité de réverbération du rayonnement solaire (l’albédo) resterait néanmoins identique à l’actuel, soit 30 %. De plus, il faudrait encore que la surface de cette Terre rayonne comme un « corps noir » abstrait, dont le flux énergétique émis serait déterminé par la loi de Stéphan-Boltzmann.

Paradoxalement, ces – 18 °C correspondent néanmoins à une réalité extrêmement concrète : c’est la température équivalente de corps noir de la Terre, telle qu’on l’observe effectivement depuis l’espace.

5. L’effet de serre en action, de visu

James Tyrwhitt-Drake

James Tyrwhitt-Drake

James Tyrwhitt-Drake, a mis en ligne une vidéo fascinante, réalisée à partir des données obtenues par les satellites géostationnaires GEOS-13 et GEOS-15 de la NASA, recouvrant le mois de janvier 2015.

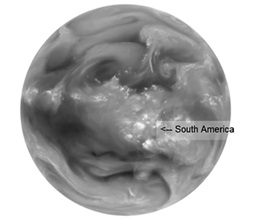

Figure 4. Vue infrarouge de la terre

Figure 4. Vue infrarouge de la terre

La figure 4 en est extraite (vers 2 : 40). Les niveaux de gris indiquent la puissance du rayonnement émis à la longueur d’onde 6.5 mm. Celle-ci est située en plein infrarouge, dans les bandes d’émission-absorption de la vapeur d’eau[16]. La puissance émise varie avec la température d’émission, et celle-ci décroît avec l’altitude. Il en résulte que les zones noires (faibles puissances émises) correspondent aux émissions à haute altitude.

Figure 5. Négatif de la précédente + vue du Brésil (NASA)

Figure 5. Négatif de la précédente + vue du Brésil (NASA)

Pour obtenir une impression visuelle plus intuitive, la figure 5 présente le négatif de l’image précédente. Les zones claires correspondent maintenant aux faibles niveaux d’émissions, à basse température et hautes altitudes. Bien entendu, l’impression de relief est fortement exagérée : les variations d’altitude réelle sont inférieures au millième du rayon terrestre.

De façon inattendue, la planète vue de l’espace se révèle en moyenne plus froide à l’équateur qu’aux pôles, et c’est au dessus de la forêt amazonienne, région chaude et humide s’il en est, que l’effet est le plus accentué. L’explication est qu’il s’agit d’une zone de fortes ascendances : l’atmosphère ne commence à devenir transparente aux infrarouges qu’à haute altitude, où elle est froide et n’émet donc qu’à faible intensité.

Plus précisément, en admettant que la température moyenne d’émission de corps noir de la Terre soit de , l’altitude moyenne pour l’ensemble des infrarouges se situerait à environ 5 000 m [17]. Noter cette moyenne inclut les émissions par la vapeur d’eau, beaucoup plus présente que le CO2 à basse altitude. L’altitude d’émission spécifique au CO2 pourrait donc être (beaucoup ?) plus élevée.

La figure 5 (et la vidéo dont elle est extraite) illustrent que l’effet de serre n’agit pas en réchauffant l’atmosphère par absorption du rayonnement infrarouge émis par la surface, comme on l’enseigne en classes de SVT, avec la bénédiction du GIEC. Au contraire, il agit en refroidissant l’atmosphère par émission d’infrarouges à haute altitude. L’énoncé suivant est à méditer ; il résume le mécanisme réel de l’effet de serre :

Plus la concentration en GES est forte, plus l’altitude d’émission est élevée, et plus la surface doit être chaude pour générer une circulation atmosphérique capable de transférer à plus haute altitude un même flux énergétique à l’équilibre.

Conceptuellement, les « radialogues » prennent le problème à l’envers. Pour des raisons calculatoires, ils adoptent comme point de départ l’émission infrarouge de surface, et ils se focalisent sur le transfert radiatif à travers l’atmosphère, alors que le cheminement causal est inverse, et que les échanges radiatifs sont secondaires par rapport aux échanges par convection et chaleur latente.

Qu’est-ce que cela change ? Répétons que les modèles programmés ne sont pas tributaires de la compréhension qu’en ont leurs concepteurs, mais pour y comprendre soi-même quelque chose, il faut dépasser la vision simpliste diffusée par les climatologues, ce qui peut se faire sans pour autant se perdre dans le labyrinthe des équations des modèles.

6. Que retenir ?

On l’aura compris, « comprendre l’effet de serre », et surtout le quantifier ne relève pas de l’évidence. Il ressort d’une identification des systèmes climatiques que sensibilité climatique à l’équilibre peut s’expliciter sous la forme d’un rapport , où les deux termes de la fraction sont extrêmement incertains.

est le « forçage radiatif » au TOA (Top of Atmospher) qui résulterait d’un doublement de concentration de CO2. Une valeur admise est . Elle résulte des spectres d’émission infrarouge des gaz à effet de serre, et se base sur le profil thermique réel de l’atmosphère. N’en déplaise aux « sceptiques », et malgré des vulgarisations fâcheuses (cf. note 32), son calcul est parfaitement rigoureux et conforme aux lois de la physique. Dans les conditions réelles, en présence de nuages et aérosols, le GIEC admet que le forçage pourrait être notablement inférieur à cette valeur. Une simple réduction de 25 % nous soulagerait déjà d’un énorme effort dans la réduction des émissions de CO2 demandée pour tenir les objectifs de la COP 21.

est le « coefficient de réaction climatique terrestre ». Un calcul élémentaire, basé sur la loi de Stephan, donne . En combinant avec la valeur haute du forçage radiatif , il en résulterait une sensibilité climatique au doublement de CO2 atteignant à peine 1 °C, limite inférieure extrême admise par le GIEC dans son « Résumé pour les décideurs ». En réalité, la réaction climatique doit être corrigée par des facteurs aussi divers que difficiles à évaluer, fortement tributaires de la modélisation des nuages. Plus la réaction est petite, plus la sensibilité climatique pourrait être élevée, et le GIEC communique lourdement sur les facteurs déstabilisant, occultant la réaction fondamentale selon laquelle, plus la Terre est chaude, plus elle rayonne. Finalement, l’incertitude est énorme sur le rapport final : la sensibilité climatique. Ceci dans un sens comme dans l’autre, et les faibles sensibilités ne sont pas les moins improbables.

7. Fiabilité des modèles climatiques

En l’absence de quantification fiable des paramètres globaux tels que la sensibilité climatique, le GIEC appuie ses prévisions sur les simulations issues de vastes modèles numériques. Malheureusement, le détail de leurs équations n’a pas de raison d’être moins incertain que les paramètres climatiques évalués globalement.

Selon le GIEC, la cinquantaine de modèles dont il est fait état dans son dernier rapport se valideraient néanmoins mutuellement, du fait que leurs simulations et projections se recoupent relativement bien. En fait, tous ces modèles incorporent une quantité de lois empiriques et d’approximations numériques, qui exigent des ajustements délicats pour conduire à des résultats acceptables. Or, bien évidemment, seuls sont considérés comme acceptables par le GIEC ceux qui reproduisent la forte hausse des températures observées très précisément entre 1978 et 1998, et dont la cause la plus apparente est l’accroissement de CO2 atmosphérique. Les projections séculaires qui résultent des modèles ainsi alignés conduisent alors obligeamment aux perspectives alarmistes préconisées par le professeur Schneider.

Malheureusement, en dehors de la période sélectionnée, aucune des simulations ne reproduit les températures globales observées sur le dernier millénaire : ni la période chaude médiévale, ni le petit âge glaciaire, ni la hausse continue depuis le début du XVIII siècle, ni la hausse continue des années 1910-1944, antérieure au développement industriel de l’après guerre, ni la pause qui accompagne justement ce développement entre 1945 et 1975, ni enfin la nouvelle pause que nous connaissons depuis 1998, alors que les émissions de CO2 n’ont jamais été aussi fortes. Vingt ans d’accord sur plus d’un millénaire, c’est bref.

Faute de mieux, un chapitre entier, le n° 10 du dernier rapport d’évaluation technique du GIEC est intitulé « Détection et Attribution du changement climatique». Ici encore, l’argument d’autorité s’exerce à fond : il revendique environ 700 références bibliographiques. Il se trouve que les techniques statistiques exploitées en Détection et Attribution (D&A) présentent certains points communs avec les méthodes de modélisation des systèmes, basées sur l’observation de leur comportement externe. Ces dernières ont été développées dans le cadre de la théorie des systèmes, sous le nom de « System Identification » – dont je suis un spécialiste. L’identification des systèmes dynamiques est une discipline préexistante, incontournable et parfaitement mature, universellement enseignée, et applicable au processus climatique. Il est inconcevable qu’aucun des auteurs du GIEC ne l’ait exploitée, et qu’elle ne soit même pas citée une seule fois. En regard, la D&A n'existe, dans la documentation scientifique, qu’associée à la climatologie. Lorsqu’une communauté de chercheurs travaille en marge d'autres disciplines reconnues, le risque existe toujours qu’elle soit juge et partie, sans garantie d’une totale indépendance du jugement scientifique. Le maître à penser du GIEC en matière de D&A est G. Hegerl, citée plus de 20 fois parmi les références bibliographiques du chapitre en question, co-auteur des recommandations aux rédacteurs du GIEC : « Good practice guidance paper on detection and attribution related to anthropogenic climate change » (2010). Le consensus sur lequel repose l’attribution à l’origine humaine du réchauffement climatique se réduit finalement à l’autorité de cette seule et unique personne, dont on note qu’elle postule l’origine anthropique du changement climatique, qu’elle entend démontrer.

A contrario, j’ai personnellement appliqué – selon les règles de l’art – les techniques standards de l’identification au processus climatique, sur la base des observations modernes et paléoclimatiques disponibles, recouvrant plus d’un millénaire. Les conclusions de mon travail sont diamétralement opposées à celles du GIEC : tout indique que le réchauffement observé dans la deuxième partie du 20e siècle est imputable à l’activité solaire et à la variabilité naturelle. Rien ne permet d’affirmer qu’une contribution anthropique soit significative, ni que des perspectives catastrophiques soient à craindre, même en cas de poursuite inconsidérée de la consommation des énergies fossiles. Ces résultats sont étayés, non seulement par des analyses statistiques et tests d’hypothèse, mais par la capacité des modèles obtenus à reproduire les évènements climatiques passés. Mieux encore, les prédictions effectuées sur la base des observations antérieures à l’an 1999 prédisent étonnamment bien le plafonnement actuel des températures, alors que les modèles du GIEC s’avèrent incapables de les expliquer a postériori.

Je ne suis certes pas le seul chercheur à être en désaccord avec le GIEC. Nous sommes des dizaines à mettre en question la conception des modèles et leur complétude. Certains se basent – comme moi – sur les observations. Je m’appuie ici sur mon propre travail, le premier à proposer des modèles globaux, validés et opposables à ceux du GIEC.

8. Conclusion

Le Giec joue sur tous les registres. D’abord, si on en croit son ex-président, ceux qui nient les effets de la contribution humaine à l’effet de serre seraient des earth-flatters (terre-platistes), négationnistes de certitudes établies. Si tout est si simple, pourquoi faudrait-il alors que seuls les climatologues « professionnels » soient habilités à émettre un avis autorisé sur la question ?

Dans le présent document, on a montré que l’effet de serre est bien loin de l’évidence prétendue. Quant à la compétence des climatologues « ordinaires », seule une infime minorité des spécialistes de la physique de l’atmosphère disposent des bases nécessaires en théorie des systèmes pour en tirer les conclusions.

Dans son ensemble, la corporation des « paraclimatologues » suscitée par le GIEC ne possède évidemment pas une once de l’autorité qui lui est attribuée pour se prononcer sur le sujet. Ses membres se soutiennent mutuellement, assurés que si la croyance en un péril climatique disparaissait, la plupart d'entre eux se retrouveraient, sinon au chômage, du moins dans un placard, sans crédits de recherche ni tribune médiatique. Au plan individuel, dès lors que le système des rapports du GIEC existe, ils savent aussi que pour faire carrière, il faut que le GIEC trouve à citer dans leurs publications au moins des paragraphes et des tableaux qui l'arrangent. Quant aux réserves que les plus sérieux d’entre eux émettraient par acquis de conscience, les dévots du GIEC sauront bien, et les édulcorer dans les rapports complets, et les ignorer en totalité dans les résumés.

[1] "E.O.Wilson "Consilience: the Unity of Knowledge" New-York, Vintage Books, 1999, p. 294

[1bis] Constante physique exprimant la relation entre la température et la puissance rayonnée par un corps noir.

[2] Finis car non infiniment petits.

[3] Qui aurait pu croire que les micro-organismes présents dans l'atmosphère participent à la formation des cristaux de glace ou des précipitations. http://www.journaldelascience.fr/environnement/articles/atmosphere-regorge-bacteries-2924

[4] les « projections » sont des prédictions sous condition de scénarios modulables : activité humaine, activité solaire…

[5] http://www.leseoliennes.be/GHG/AGWfr.htm

https://books.google.fr/books?id=vzNuo1oYp2sC&pg=PA97&lpg=PA97&dq=rayonnement+entre+deux+corps&source=bl&ots=eQ40E7zfTm&sig=c00pG-srB6dO7Z1WN6LwvOWgO7o&hl=fr&sa=X&ved=0ahUKEwjd45--xpzUAhUG2BoKHbAeAio4MhDoAQhLMAc#v=onepage&q=rayonnement%20entre%20deux%20corps&f=false

[6] Une exception mineure : l’ozone, qui absorbe les UV. Ce qui ne va pas sans engendrer des confusions : « La destruction progressive de la couche d'ozone et l'effet de serre qu'elle provoque ont atteint désormais des dimensions critiques », message de Jean-Paul II, 1er janvier 1990.

[7]« Sciences de la Vie et de la Terre », pour ceux qui en sont restés aux « leçons de choses » de leur jeune temps.

[8] Extrait : A number of scientific studies indicate that most global warming in recent decades is due to the great concentration of greenhouse gases (carbon dioxide, methane, nitrogen oxides and others) released mainly as a result of human activity. Concentrated in the atmosphere, these gases do not allow the warmth of the sun’s rays reflected by the earth to be dispersed in space. The problem is aggravated by a model of development based on the intensive use of fossil fuels, which is at the heart of the worldwide energy system. Another determining factor has been an increase in changed uses of the soil, principally deforestation for agricultural purposes.

- Warming has effects on the carbon cycle. It creates a vicious circle which aggravates the situation even more, affecting the availability of essential resources like drinking water, energy and agricultural production in warmer regions, and leading to the extinction of part of the planet’s biodiversity. The melting in the polar ice caps and in high altitude plains can lead to the dangerous release of methane gas, while the decomposition of frozen organic material can further increase the emission of carbon dioxide

En italien : La loro concentrazione nell’atmosfera impedisce che il calore dei raggi solari riflessi dalla terra si disperda nello spazio.

[9] Un rapprochement instructif : en 1951, le Pape Pie XII croit pouvoir démontrer l'existence de Dieu par les apports récents de la science (discours Un' Ora, évoquant les travaux de l’abbé George Lemaire, inventeur du bigbang). Cette relation entre science et théologie n'est pas du tout en accord avec les conceptions de ce dernier. Sa critique est respectueuse, suggérant que le discours avait été écrit par une autre personne.

[10] http://www.americaherald.com/carbon-dioxide-is-responsible-for-the-greenhouse-effect-new-study-suggests/23317/

[11] A force de parler de couche d’ozone, on finit par imaginer que le CO2 atmosphérique est situé lui aussi dans une « couche ».

[12] Trenberth, K. E., Fasullo, J. T., & Kiehl, J. (2009). Earth's global energy budget. Bulletin of the American Meteorological Society, 90(3), 311-323.

[13] On fait pour l’instant abstraction d’une « fenêtre atmosphérique », située entre les longueurs d’onde 8 et 12 mm, où le rayonnement émis par la surface s’échappe directement vers l’espace. Cf. fig. 3.

[14] Concrètement, la pression atmosphérique équivaut à dix mètres de hauteur d’eau. Celle du CO2 à 4 millimètres d’eau.

[15] Référence : AR5, section 8.3.1

[16] Voir aussi

[17] Pour un gradient de température atmosphérique standard de 6.5 °C/km.